Entre Lolf et Shanghai

Quel espace pour l’évaluation ?

L’évaluation des publications reste un facteur dominant dans les procédures de caractérisation des unités de recherche. En France, elle est notamment régie par le programme P150 de la loi organique relative aux lois de finances (Lolf). Les principaux objectifs du programme relatifs à l’aspect documentaire de l’évaluation (performances mesurées par les publications, transfert de technologie et coopération internationale) sont repris par l’Observatoire des sciences et des techniques à travers ses propres indicateurs. Le modèle d’analyse sur deux ans, préconisé par l’Institute for Scientific Information (ISI), favorise la recherche appliquée. Il marginalise de ce fait les sciences humaines dont les usages et les structures de publication se prêtent mal à l’exécution des méthodes scientométriques adaptées au domaine des sciences, de la technologie et de la médecine. Une prise de conscience de la communauté scientifique, en synergie avec les professionnels de l’information-documentation, devrait permettre de développer en France une réflexion sur les ajustements nécessaires, tant sur le plan méthodologique que sur celui de la déontologie.

Evaluating publications remains a significant factor in characterising research groups. In France, the process of evaluation falls under programme P150 of the organic law relating to the finance laws (LOLF, loi organique relative aux lois de finances). The programme’s main objectives in defining how documents should be evaluated (measuring performance by publication, technology transfer, and international co-operation) have been adopted by the Observatoire des sciences et des techniques, using its own indicators. The two-year analysis model recommended by the Institute for Scientific Information (ISI) favours applied research, to the detriment of the humanities, whose modes of publication are ill-suited to the kind of scientometric methods developed for the fields of science, technology, and medicine. Information and communication professionals need to work with the scientific community to raise awareness of such issues, leading to discussion of necessary changes to the methodology and professional ethics of evaluation practice in France.

Die Evaluierung der Publikationen bleibt ein führender Faktor bei den Charakterisierungsverfahren der Forschungseinheiten. In Frankreich wird sie insbesondere durch das Programm P150 des Gesetzes über die Führung der öffentlichen Haushalte (LOLF, loi organique relative aux lois de finances) geregelt. Die sich auf den dokumentarischen Aspekt der Bewertung beziehenden Hauptziele des Programms (durch die Publikationen gemessene Leistungen, Technologietransfert, internationale Kooperation) werden vom Institut für Wissenschaft und Technik (Observatoire des sciences et des techniques) anhand seiner eigenen Indikatoren übernommen. Das vom ISI (Institute for Scientific Information) empfohlene Auswertungsmodell über zwei Jahre fördert die angewandte Forschung. Es grenzt aufgrund dieser Tatsache die Geisteswissenschaften aus, deren Publikationsbräuche und – strukturen sich schlecht zur Anwendung szientometrischer Methoden, die an den Wissenschafts-, Technologie- und Medizinsektor angepasst sind, eignen. Eine Bewusstwerdung der Wissenschaftsgemeinschaft im Zusammenwirken mit den Informations- und Dokumentationsspezialisten sollte ermöglichen, in Frankreich ein Nachdenken über die notwendigen Anpassungen sowohl auf methodologischer als auch auf deontologischer Ebene zu entwickeln.

La evaluación de las publicaciones es aún un factor dominante en los procedimientos de caracterización de las unidades de investigación. En Francia, ella está regida por el programa P150 de la ley orgánica relativa a las leyes de finanzas (Lolf, loi organique relative aux lois de finances). Los principales objetivos del programa relativos al aspecto documental de la evaluación (performances medidas por las publicaciones, transferencia de tecnología y cooperación internacional) son retomados por el Observatorio de las ciencias y de la técnicas a través de sus propios indicadores. El modelo de análisis en dos años, preconizado por el Institute for Scientific Information (ISI), favorece la investigación aplicada. Este marginaliza por este hecho a las ciencias humanas cuyos usos y estructuras de publicación se prestan mal a la ejecución de los métodos cientométricos adaptados al ámbito de las ciencias, de la tecnología y de la medicina. Una toma de conciencia de la comunidad científica, en sinergía con los profesionales de la información-documentación, debería permitir desarrollar en Francia una reflexión sobre los ajustes necesarios, tanto sobre el plan metodológico como sobre el de la deontología.

« Évaluer tue » : un titre qui se voudrait provocateur, celui d’un dossier du Nouvel âne, le magazine international lacanien 1, reprend l’antienne d’une mouvance certes minoritaire mais bien présente dans le milieu de la recherche.

S’il est exact que les méthodes d’évaluation actuellement en vigueur en France peuvent être à l’origine d’abus dûment constatés, il n’est pas prouvé qu’une attitude simplement négatrice soit la plus adaptée pour engager une analyse critique et constructive. Au contraire.

La recherche ouverte, à risque parce que franchement innovante (de type « blue sky »), est fortement mise à mal par un milieu plutôt prédisposé aux tendances déjà affirmées de la recherche. Se démarquer des modèles ambiants pose des problèmes mis en avant par d’éminents chercheurs, qui ont initié un débat significatif sur ce thème dans la revue Nature en 2003. D’abord sous la plume de Peter Lawrence, du laboratoire de biologie moléculaire de Cambridge, qui n’hésite pas à s’exprimer sur le népotisme rampant de certains comités de lecture 2. Son jugement est corroboré par David Colquhoun, du département de pharmacologie de l’University College de Londres, sous un autre titre parlant : « Challenging the tyranny of impact factors 3 ». Ce niveau d’analyse critique touche progressivement le milieu de la recherche française et, avec lui, les professionnels de l’information et de la documentation. C’est vers un objectif de coopération entre ces acteurs que tend la réflexion qui suit.

Elle fera le point sur les principes qui régissent actuellement en France l’évaluation des publications. Elle laissera volontairement de côté l’analyse de nombreux modèles expérimentaux souvent bénéfiques et intéressants : bases de citations liées aux archives ouvertes, indices de distribution de type H alternatifs, Eigenfactor, boîtes à moustaches (box plots) et indices de notoriété, réseaux de co-citations, etc. 4

Des référentiels qui favorisent le domaine STM (sciences, technologie, médecine)

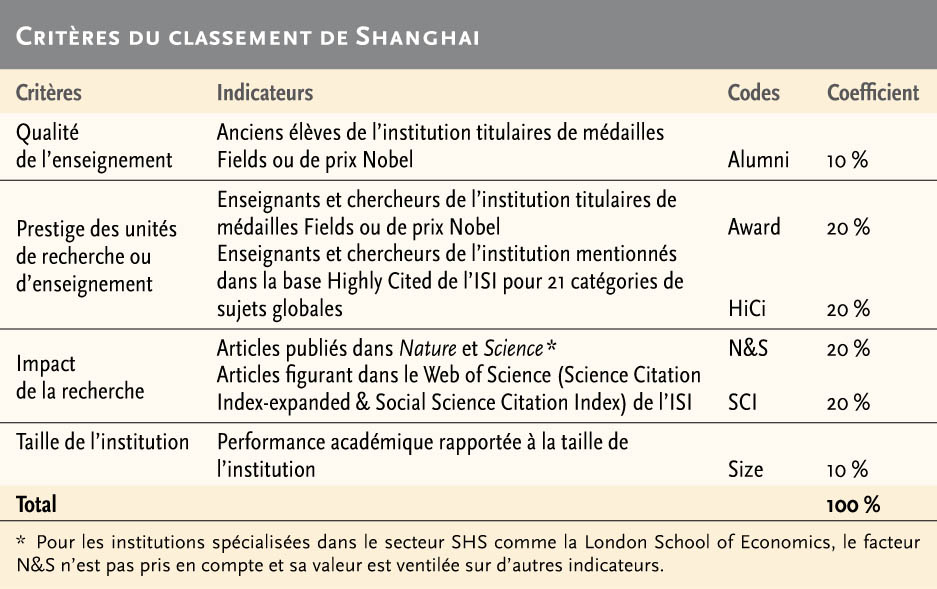

Colonne vertébrale d’un système d’information, la structure d’un référentiel oriente les résultats du traitement des données. Dans le domaine de l’évaluation bibliométrique, on peut évoquer deux éléments moteurs, l’un national (le programme 150, alias P150, de la Lolf 5, la loi organique relative aux lois de finances promulguée en 2001), l’autre international (le classement de Shanghai) 6.

Nous verrons qu’en France la visée concomitante des objectifs 7 à 11 du P150 va infléchir très sensiblement le résultat des mesures effectuées en faveur de la recherche en sciences exactes et appliquées. Quant au classement de Shanghai, son allégeance assez significative aux critères de l’Institute for Scientific Information (ISI) induit une tendance ouvertement défavorable aux sciences humaines et à une part notable des sciences sociales.

Le programme 150 de la Lolf

Une dizaine de programmes de la Lolf (codés Pnnn) 7 visent la recherche. Certains concernent la recherche finalisée, pouvant avoir un caractère spécialisé suivant les secteurs (énergie, spatial, risques et pollution…). La recherche académique est plus particulièrement régie par le P150, qui comporte quelques indicateurs touchant les publications, regroupés sous les objectifs n° 7 et 8. Deux autres objectifs recoupent des préoccupations d’ordre documentaire : les n° 9 et 11 (voir encadré ci-dessous).

Le programme 150 de la Lolf

La Lolf pour la recherche

L’objectif n° 7 s’intitule : Produire des connaissances scientifiques au meilleur niveau international.

– Indicateur 7.1 : production scientifique des opérateurs du programme.

Part des publications de référence internationale des opérateurs du programme dans la production scientifique de l’Union européenne et du monde.

– Indicateur 7.2 : reconnaissance scientifique des opérateurs du programme.

Indice de citation à deux ans des publications des opérateurs du programme.

L’objectif n° 8 s’intitule : Développer le dynamisme et la réactivité de la recherche universitaire

Indicateur 8.1 : part des publications de référence internationale des opérateurs du programme dans les domaines scientifiques définis comme prioritaires en référence européenne (UE25) et dans le monde.

La Lolf pour la documentation

L’objectif n° 9 s’intitule : Contribuer à l’amélioration de la compétitivité de l’économie nationale par le transfert et la valorisation des résultats de la recherche. Il s’agit, à certains égards, d’un autre type de littérature scientifique : les brevets (indicateur 9.1), dont le dépôt est jugé comme un élément capital dans la valorisation d’une unité de recherche.

L’objectif n° 11 vise à Consolider l’Europe de la recherche, par le biais des PCRD (programmes cadres de recherche et développement de l’Union européenne). L’indicateur 11.3 (part des articles copubliés avec un pays membre de l’Union européenne dans les articles des opérateurs du programme) rejoint les préoccupations de l’évaluation documentaire. Cette ouverture sur l’extérieur recoupe les visées de l’objectif n° 10 relatif à la présence d’étrangers dans les équipes de recherche * et, partant, à l’attractivité de celles-ci.

Associer étroitement les objectifs 9 et 11 à ceux qui visent directement les publications (7 et 8) a pour conséquence quasi incontournable une mise en avant du secteur STM. On retrouvera une orientation sous-jacente identique dans les analyses proposées par l’OST.

- (retour)↑ Proportion d’étrangers parmi les chercheurs, enseignants chercheurs, postdoctorants et ingénieurs de recherche rémunérés par l’État à partir du programme, ou par les opérateurs du programme. Francine Courtial, « Sélectionner des revues pour les chercheurs : l’exemple de l’IGR [Institut Gustave Roussy] », Documentaliste – Sciences de l’information, n° 4, novembre 2009, p. 42-43.

Institute for Scientific Information (ISI) et Shanghai

La source affichée par le programme en matière de documentation s’intitule : « ISI-OST ».

On sait que l’ISI (voir encadré ci-dessous) est présent dans le troisième critère du classement de Shanghai : présence de membres en exercice de l’entité dans le fichier Highly Cited 8 (20 % du cumul des critères). Dans le quatrième critère également : présence notable dans le Web of Science (aussi 20 %). Quant à l’obligation faite de publier dans Nature ou Science (cinquième critère à raison de 20 % également) 9, elle concerne deux revues « généralistes d’excellence », mises en avant du fait de leur très fort facteur d’impact au sens de l’ISI. Il n’est donc pas déplacé de considérer que ce classement repose à 50 % environ sur la grille de l’ISI.

L’influence de l’Institute for Scientific Information (ISI)

Dès 1960, l’Institute for Scientific Information (ISI) de Philadelphie, sous l’impulsion d’Eugen Garfield, a mis en œuvre le Science Citation Index (SCI) utilisé aujourd’hui pour l’évaluation des auteurs, suivi en 1975 par le Journal Citation Reports (JCR) pour celle des revues.

On connaît la très forte influence exercée par l’ISI sur la communauté scientifique internationale. Le modèle statistique qu’il a mis en œuvre conditionne l’avancement des chercheurs dans un nombre croissant de pays. Les administrations qui en ont la tutelle utilisent fréquemment la combinaison Citations + Impact Factor pour « noter » ces chercheurs. Le facteur d’impact, qui s’apparente à une cotation annuelle des revues, est issu du JCR. Son calcul s’applique aux citations couvrant les années n – 1 et n – 2 par rapport à l’année de référence.

À l’origine, le SCI et le JCR servaient essentiellement à guider les bibliothécaires responsables d’acquisitions à orienter leur choix pour les abonnements, dans un contexte où ceux-ci sont particulièrement onéreux. Moins fréquente actuellement, cette option présente toujours un intérêt certain, comme en témoigne par exemple l’usage à l’Institut Gustave Roussy, spécialisé en cancérologie *.

L’ISI fut acquis en 1992 par le canadien Thomson Scientific & Healthcare, qui a absorbé l’agence britannique Reuters en 2008.

Les bases de l’ISI

Web of Science

Producteur : Institute for Scientific Information (ISI, Philadelphie).

Adresse : http://isiknowledge.com

Mode d’accès : sur abonnement.

Description : bibliographie depuis 1900 (environ 45 millions de références, dont 25 millions antérieures à 1996, éléments statistiques associés à l’étendue chronologique et donc financière de l’abonnement), liens vers les citations, analyse statistique sur les auteurs (dont facteur H) et leurs articles.

Contenu : il comprend trois bases. Science Citation Index (SCI) : 6 650 titres en sciences, technologie et médecine ; Social Science Citation Index (SSCI) : 2 000 titres en sciences sociales ; Arts & Humanities Citation Index (AHCI) : 1 150 titres en sciences humaines.

Journal Citation Reports (JCR)

Producteur : Institute for Scientific Information (ISI, Philadelphie).

Adresse : http://isiknowledge.com

Mode d’accès : sur abonnement.

Description : le JCR est calqué sur le Web of Science. Analyse depuis 1975 les facteurs d’impact des revues agréées par l’ISI. L’abonnement donne accès aux quatre dernières années.

Contenu : il comprend deux sections disciplinaires. 6 598 titres en sciences exactes et appliquées (2008) ; 1 980 titres en sciences sociales (2008).

- (retour)↑ Proportion d’étrangers parmi les chercheurs, enseignants chercheurs, postdoctorants et ingénieurs de recherche rémunérés par l’État à partir du programme, ou par les opérateurs du programme. Francine Courtial, « Sélectionner des revues pour les chercheurs : l’exemple de l’IGR [Institut Gustave Roussy] », Documentaliste – Sciences de l’information, n° 4, novembre 2009, p. 42-43.

Les indicateurs de l’Observatoire des sciences et techniques et l’ISI

L’OST (Observatoire des sciences et techniques), groupement d’intérêt public à vocation interministérielle, est géré par quinze acteurs du système français de recherche depuis 1990. Il développe des analyses de type SWOT 10 et fournit depuis 2006 des indicateurs à destination des entités de recherche. À côté du volet documentaire, on retrouve des rubriques relatives aux brevets et aux programmes cadres de R & D de l’Union européenne. Les indicateurs de l’OST sont reflétés par ceux du P150. On en dénombre huit principaux :

- part de publications scientifiques ;

- indice de spécialisation scientifique ;

- part de citations ;

- indice d’impact relatif ;

- indice d’impact espéré ;

- ratio de citations relatif (RCR) ;

- indice d’activité par classe de citations ;

- part d’articles en copublication.

Le facteur d’impact 11 de l’ISI est polyvalent ; il intervient dans les quatrième, cinquième et sixième indicateurs notamment. L’indice d’impact espéré est assez singulier : il « tient spécifiquement compte de l’impact des journaux dans lesquels l’acteur publie. Il est égal à l’indice d’impact relatif qu’obtiendrait l’acteur si, dans chaque journal où il publie, ses publications recevaient la moyenne des citations reçues par l’ensemble des publications du journal 12 ». Il est particulièrement incitatif et reflète des exigences claires au niveau normatif du classement (inter) national.

Les périodes d’analyse concernées par ces indicateurs sont généralement de deux ans, à l’image du facteur d’impact de l’ISI. La recherche appliquée est donc nettement favorisée, car on est en droit d’attendre un maximum de citations à bref délai. En outre, deux disciplines sont particulièrement privilégiées : les sciences de la matière et les sciences de la nature et de la vie, notamment du fait de leur excellente couverture par le Web of Science auquel se réfère l’Iperu 13 de l’OST : « La base de données source est le Web of Science de Thomson Reuters qui fait référence pour la bibliométrie dans les domaines des sciences de la matière et de la vie 14. » Il importe d’observer que les brevets générés par la recherche appliquée sont assez directement liés à l’industrie des matériaux dans le premier cas et à l’industrie pharmaceutique dans le second.

Il ne paraît pas déplacé de citer ici Yves Gingras, bibliomètre expert et réputé, directeur scientifique de l’OST de l’université du Québec à Montréal : « L’existence du “facteur d’impact” des revues, publié par la firme Thomson Reuters, ne constitue pas à proprement parler un classement officiel. Localement, il peut être utilisé par un comité qui en a décidé ainsi, croyant alors se faciliter la tâche. Il n’a aucun effet global sur la discipline ou même sur le pays 15. »

Se focaliser sur le facteur d’impact d’une revue tend à faire oublier qu’existe aussi le « Facteur d’impact agrégé » (Aggregate Impact Factor) des catégories de sujets. Au nombre de 173 16 dans la version STM du JCR (Journal Citation Reports) et de 56 en sciences sociales 17, ces Subject Categories se chevauchent plus ou moins, du fait qu’une revue n’est pas forcément circonscrite sur le plan disciplinaire avec une rigueur parfaitement « étanche », transversalité oblige. Si l’on aligne un certain nombre de catégories de sujets présentant des affinités en tant que disciplines connexes, visées dans le champ d’exercice d’une équipe de recherche, on peut analyser les facteurs d’impact agrégés des ensembles de revues recouvertes par chaque catégorie en utilisant cette agrégation comme une référence de cotation. Si, au fil des ans, telle ou telle catégorie de sujet voit sa cote baisser, on peut imaginer qu’une agence de moyens privilégie le financement de tel ou tel axe de recherche au détriment d’un autre.

Les bases complémentaires

S’il est relativement clair que les instances administratives françaises semblent privilégier les bases de l’ISI, certaines institutions doivent compléter les opérations de caractérisation de leurs unités avec Scopus 18 d’Elsevier. En 2008, des analyses « montrent que 7 434 revues sont indexées par les deux bases et que 6 256 titres de Scopus ne sont pas indexés par WoS alors que 1 467 revues indexées par WoS ne le sont pas par Scopus. Ainsi, 54 % seulement des revues traitées par Scopus se trouvent aussi dans WoS et 84 % des revues de WoS sont dans Scopus 19 ».

Deux sous-domaines STM, notamment, recourent à d’autres sources en vue de comptabiliser les publications. L’informatique, d’une part, comme en témoigne un rapport de l’Inria (Institut national de recherche en informatique et en automatique) devenu classique 20 sur la comparaison Web of Science/Google Scholar/Scopus/DBLP 21, et la recherche en milieu hospitalier, d’autre part, avec PubMed, relayé localement par l’outil d’évaluation de la recherche médicale des établissements hospitaliers universitaires, Sigaps 22.

La problématique des sciences humaines

L’enquête du CNRS de 2004

Le problème des sciences humaines réside dans l’incompatibilité relative de ses éléments d’appréciation avec les modalités d’évaluation du domaine STM.

En 2004, le département sciences humaines du CNRS a entrepris de réévaluer la qualité des revues qu’il subventionnait. Il a inscrit sa démarche en aval du projet de l’European Science Foundation 23 visant à la constitution de l’« European Citation Index in Humanities ». Dans un article 24 exposant les prémices de ce projet, l’ESF ne remet pas fondamentalement en cause l’autorité de l’ISI dans le secteur des sciences exactes et appliquées. Il conteste cet institut essentiellement vis-à-vis de la prééminence anglo-saxonne qu’il suppose, à l’instar de la réaction européenne qui a pu suivre l’annonce du projet Google Print 25.

C’est l’AHCI (Arts and Humanities Citation Index) publié par le même ISI qui fait l’objet d’un « contre-modèle ». Le département sciences humaines et sociales (SHS) du CNRS reprend les standards de l’European Science Foundation en sciences humaines bien sûr, mais également en sciences sociales :

- Le nombre d’années de référence passe de deux à dix, ce qui peut sembler naturel dans les disciplines SHS.

- Les sources de citations sont générées par un noyau de « revues cœur » à l’intérieur de 18 champs disciplinaires. On compte en moyenne six « revues cœur » par discipline – pour moitié anglophones et pour moitié francophones – jugées prééminentes dans le domaine au niveau international.

- Les 18 groupes sont divisés en quartiles dont l’étendue varie en fonction du nombre des titres constituant le corpus. Les trois premières strates correspondent aux trois « rangs » en vigueur au CNRS : A = revues internationales de très haut niveau ; B = revues internationales de haut niveau ; C = revues d’audience nationale. La quatrième strate se situe « hors classement ». Le rang C (et la remarque n’est pas superflue) accorde une importance non négligeable aux revues d’intérêt national.

Le département SHS a dépouillé 125 revues sur la décennie 1992-2001. À travers elles, 38 973 bibliographies terminales d’articles ont permis le recensement de 584 398 citations 26.

Les critères précédemment énoncés contribuent positivement à viser une certaine équité dans l’évaluation. Néanmoins, deux observations s’imposent :

- Ces champs disciplinaires font état de très nombreuses citations de monographie, alors que l’article de périodique est quasiment généralisé en sciences exactes et appliquées. On n’est donc plus dans le même environnement documentaire et la comparaison s’en trouve faussée.

- La méthode ayant présidé au choix des 125 revues est essentiellement fondée sur la libre appréciation de chercheurs CNRS, délégués par le département SHS dans les 18 champs disciplinaires pour proposer des listes de revues paraissant prééminentes dans le domaine, tant au niveau national qu’international. C’est du moins ce qui résulte d’un sondage effectué par nos soins auprès de certains responsables. Ceci posé, même si la méthode peut sembler souffrir de l’empirisme, on ne peut contester à tel ou tel titre le fait qu’il soit effectivement considéré comme une référence dans la discipline.

Configuration actuelle en sciences humaines et sociales

En dépit d’inévitables oublis ou erreurs, et de l’objectif affiché d’une réévaluation des revues dans la perspective d’une restructuration de l’aide du CNRS, on a voulu corriger un certain nombre d’anomalies propres au modèle de l’ISI et, ne serait-ce que vis-à-vis de cette méthode, il convient d’en prendre acte favorablement.

Néanmoins, Yves Gingras porte un jugement critique sur l’évaluation française dans ce domaine : « Lorsque l’AERES ou l’European Science Foundation créent littéralement un classement des revues en sciences humaines, elles officialisent et figent un état de la structure des relations entre revues, qui est toujours dynamique et changeant. Elles génèrent ainsi des effets en retour qui désavantagent les revues plus jeunes et mouvantes ou plus spécialisées. Sans compter que la procédure de classement est opaque et arbitraire 27. »

Face à cette situation, il convenait de réunir un maximum d’éléments propres à répertorier les revues SHS. Ainsi, dans le cadre des actions entreprises avec le soutien financier du Très grand Equipement Adonis, Michèle Dassa et Christine Kosmopoulos ont-elles élaboré JournalBase 28, fichier qui comprend plus de 21 000 entrées et près de 10 000 titres de revues différents. Il agglomère :

- l’Arts & Humanities Citation Index (ISI) ;

- le Social Science Citation Index (ISI) ;

- l’European Reference Index for the Humanities (ERIH) 29 ;

- la liste de l’AERES 30 ;

- Scopus.

L’ERIH résulte de la coopération de l’ESF susnommée et de l’HERA (Humanities in European Research Area) 31, consortium d’agences de financement de la recherche en sciences humaines : il répertoriait 5 000 titres en 2008.

En juillet de la même année, l’AERES en recensait 6 000.

JournalBase recouvre 27 catégories disciplinaires qui doivent composer avec des périmètres très différents en fonction des bases et des pays.

Perspectives : coopérer, analyser, restructurer

Les alternatives aux principes que nous venons d’énoncer sont nombreuses, comme nous le rappelions au début de cette réflexion synthétique, mais sont rarement agréées aujourd’hui par les instances administratives d’évaluation, du moins en France.

Ainsi que nous le suggérions en introduction, il appartient à la communauté scientifique de réfléchir sur les modalités d’une restructuration des principes d’évaluation et de caractérisation des unités de recherche au plan documentaire. La constitution de groupes de travail associant des enseignants-chercheurs et des professionnels de la documentation permettrait de fédérer les énergies et de mutualiser les expériences. Dans l’absolu, y adjoindre des membres d’agences d’évaluation serait évidemment bienvenu. Enfin, la synergie STM/SHS est clairement indispensable.

Vaste projet sans doute, mais d’une brûlante actualité…

Avril 2010