Les principes de la translittération, la translittération de l'arabe et la nouvelle norme de l'ISO

La translittération aes écritures non latines en lettres latines, la transcription en écriture latine de mots de langues non écrites sont une nécessité, particulièrement dans le domaine des bibliothèques et des cartes géographiques, même si on aboutit ainsi à des prononciations fausses. Une systématisation de ces procédés est indispensable quoiqu'il soit difficile d'éviter ou l'incohérence ou l'hermétisme. Depuis Volney, la marche vers la systématisation a abouti à de nombreux projets pouvant se ramener à deux types. L'ISO a, depuis 1948, pris la question en main. Après le cyrillique, la discussion des projets pour l'arabe et l'hébreu a mis en lumière des difficultés particulières à l'une de ces deux langues ou communes aux langues sémitiques. La recommandation ISO/R 233 sur la translittération de l'arabe adoptée en I96I représente un grand progrès. On peut en espérer la diffusion et l'extension

Introduction au problème. Avantages et inconvénients d'une écriture commune

La barrière de la diversité des langues, l'incommunicabilité qu'elle instaure entre tant de peuples, toutes les embûches et les traîtrises que symbolise et que veut expliquer le vieux mythe de Babel sont des données qui ne sont pas près de s'abolir malgré la diffusion du polyglottisme, malgré le prosélytisme ardent des diffuseurs de langues universelles.

Cette barrière s'abaisse un peu dans le cas de langues qui s'écrivent en une même écriture. Quand il s'agit d'écritures idéographiques, comme le chinois classique 1, on aboutit même à une situation où l'incommunicabilité s'abolit totalement sur le plan du graphisme. Le même caractère se lit de façon toute différente à Pékin, à Canton, à Shanghaï. Mais le texte lu garde le même sens. Ainsi nos signaux de circulation automobile ou plus simplement encore nos chiffres. Nous « lisons » « sens interdit » cette barre horizontale blanche sur le fond d'un cercle rouge que les Anglais lisent « No entry ». Le comportement attendu - sous peine de sanction - des automobilistes en face de ce signe est pourtant le même à Londres et à Paris. Les deux signes graphiques « 99 » se lisent en turc « doksan dokuz » et même en français de Belgique « nonante-neuf » ce qui n'empêche nullement un chauffeur de taxi vous montrant ce chiffre à Istanbul, Bruxelles ou Paris de vous réclamer le même nombre d'unités monétaires. D'ailleurs, certains graphismes, même dans des écritures qui se lisent normalement en accordant une valeur phonétique à chaque signe, peuvent à l'occasion se lire ainsi idéographiquement. Les lettres « e. g. » qui correspondent au latin « exempli gratia » se lisent en anglais « for example » ce qui n'a aucun rapport avec la valeur normale des lettres écrites, comme chez nous «,W.C. » se lit souvent tout autrement que « water closet ». Ainsi, en pehlevi, langue iranienne, on écrivait les lettres correspondant aux sons mlkâ (en araméen « roi ») et on lisait shâh, c'est-à-dire « roi » en iranien.

Ces cas paraissent extrêmes et le sont en un sens. Mais on oublie habituellement que la communauté d'écriture, jointe à la diversité des langues ou dialectes, engendre toujours une idéographie partielle, au minimum pour les noms propres. Peu de gens qui ne sont pas Hongrois savent que la capitale de la Hongrie s'appelle en hongrois d'un nom qui se transcrirait en français à peu près Boudapecht. On écrit partout, comme en Hongrie, Budapest et on prononce de façon très variée suivant les pays en se fiant à la valeur phonétique de ces huit lettres dans la langue de chacun, donc de façon assez différente. Cela n'empêche pas que cet ensemble de lettres latines désigne pour chacun le même objet, la capitale de la Hongrie. Nul Espagnol lisant Byron ne méconnaîtra qu'il s'agit d'un héros évoquant pour le moins son compatriote don Juan Tenorio lorsque le poète anglais décrit les aventures d'un don Juan dont il fait rimer le nom avec « drew on » et « a new one » alors que, s'il écoute réciter le poème, il aura bien du mal à s'en convaincre. Ainsi Victor Hugo écrivait sans sourciller :

Quel est donc ce perfide

Confident de Cromwell et du chancelier Hyde?

Bien peu d'Anglais comprendraient à l'audition de qui parlait le poète. Pourtant, c'est bien le même homme d'État dont le nom était, sous sa forme phonétique, bien différent.

La tendance à préférer l'idéographie, c'est-à-dire la reproduction pure et simple de l'orthographe originale, quitte à provoquer des erreurs de prononciation, à la transcription phonétique visant à suggérer une prononciation proche de l'originale n'a fait que progresser depuis le Moyen âge. Elle s'est accélérée avec la diffusion dans des couches étendues des populations européennes de la connaissance de l'écriture et même d'éléments des langues étrangères. Il s'agit plus de reconnaître le nom écrit que le nom prononcé. Le bon Froissart pouvait parler d'un « vaillant chevalier qui s'appeloit messire Jan Haccoude », c'est-à-dire Hawkwood, et de « messire Jacques de Lindesée » c'est-à-dire Lindsay. Ce ne sont pas des transcriptions si mauvaises. Mais nous écrivons Churchill et non, comme on l'eût fait sans doute au Moyen âge, quelque chose comme Tchartchill, en laissant les ignorants prononcer Churchile au début comme « chute » et à la fin comme « chilien ». Dans les noms communs, il en est de même. Au XVIIe siècle, on a fait normalement de « packet boat » paquebot alors qu'on se gausse de Queneau qui écrit piqueupe ou kékouok (cake walk). D'où des incompréhensions, des sourires de mépris ou des accusations d'affectation quand on entend des gens de diverses catégories sociales prononcer le mot yacht.

Cette idéographie possible entre langues dotées de la même écriture a, on le voit, des avantages et des inconvénients. J'ai souligné jusqu'ici surtout les inconvénients dont on a peu conscience en général. Mais les avantages n'en sont pas moins certains. L'identification sûre d'un nom sous sa forme écrite, son affectation à une personne, à un lieu, à un objet donnés par la masse des populations qui appartiennent à une vaste aire culturelle sont des avantages sérieux, même si chaque nation ou chaque couche de population prononce le vocable à sa façon.

En particulier, cela est d'une très grande utilité en deux domaines dont il sera beaucoup question ici : celui des cartes géographiques et celui des catalogues de bibliothèques. Du moment qu'on a affaire à une même écriture, on peut écrire les noms de villes, de pays, de rivières, etc., de nombreuses langues différentes, les reconnaître, les indexer 2. Pour les bibliothèques, on peut transcrire les titres, fût-ce sans les comprendre, les classer comme les noms d'auteurs par ordre alphabétique, fût-ce en les prononçant mal. Et c'est là le travail essentiel qu'on attend du bibliothécaire.

Nécessité de la translittération

La chose devient malheureusement tout à fait impossible quand il s'agit de noms en usage chez des peuples qui ne connaissent pas l'écriture, cas plutôt rare maintenant. Il n'est de ressource en ce cas que d'essayer de rendre la prononciation originale telle qu'on peut la connaître. Le danger évident est que chacun entend souvent à sa manière un vocable d'une langue inconnue et le rend de façon encore diversifiée par la diversité des orthographes. Du moins, quand il s'agit de noms appartenant à des langues dotées d'une écriture non latine, on a un repère objectif qui est la forme graphique adoptée par le peuple qui parle et écrit une de ces langues. Mais, pour la plupart des utilisateurs, cette forme graphique est énigmatique. Ce ne sont pas seulement le géographe ou le bibliothécaire qui sont confrontés à ce problème. Un journaliste ou un écrivain qui doit citer des noms comme Mao Tse-toung, Venizelos, Ben Gourion, Nehru, Nasser, demandera en vain : « Comment cela s'écrit ? », question éternelle, et dans ce cas naïve 3, de l'inexpert en matière linguistique, c'est-à-dire de l'immense majorité. La seule réponse exacte sera quelques traits qui lui paraîtront (sauf, espérons-le, dans le cas du grec) un gribouillage indéchiffrable, « de l'hébreu pour lui » selon l'expression consacrée. Chacun s'essaye dès lors (et l'intéressé lui-même) à restituer en lettres latines la forme vocale du nom comme le fait le bibliothécaire priant quelqu'un de lui lire une page de titre en caractères inconnus ou le géographe demandant à un « indigène » de lui prononcer un nom de localité. Le but cherché est essentiellement de pouvoir parler entre soi du personnage ou du lieu considérés, les citer, en discuter et beaucoup moins celui de restituer la prononciation du nom souvent d'ailleurs imprononçable exactement par des gosiers étrangers. Il s'agit surtout de réduire le complexe énigmatique de traits graphiques à une graphie familière de façon que la lecture de celle-ci, muette ou à haute voix, évoque bien le personnage ou le lieu considéré tout comme s'il s'agissait de gens et lieux dont le nom s'exprime habituellement en lettres latines.

Il est clair cependant que, si chacun se fie à ce qu'il croit entendre, si chacun rend à son idée des sons d'une autre langue, on aboutira à l'anarchie des transcriptions et des translittérations 4 et à l'incompréhension mutuelle. Dans les bibliothèques par exemple, et le cas est fréquent, l'utilisateur cherchera un auteur ou un titre à l'orthographe latine qu'il estimera lui-même normale et n'aura pas l'idée de chercher la forme que le bibliothécaire aura choisie. Une certaine entente est évidemment nécessaire.

Dilemme de la systématisation

La systématisation est inéluctable. Mais elle aboutit normalement à un dilemme non moins inévitable où prennent leur source la plupart des objections que l'on fait aux divers systèmes proposés. Toute systématisation s'efforce de fuir l'équivoque. Or, si l'on veut éviter l'équivoque, on aboutit fatalement à la règle : un seul signe pour un seul phonème (transcription) ou un seul signe pour un seul signe (translittération). En effet, prenons l'exemple de l'orthographe anglaise normale où un groupe de deux signes th rend deux phonèmes différents, l'interdentale sourde dans thunder et l'interdentale sonore dans that ou the. Première équivoque pénible pour un étranger, mais sur laquelle je n'insiste pas ici. Mais, il existe des mots comme priesthood où th n'indique pas le phonème unique interdental qu'il soit sourd ou sonore. Il indique la suite des deux phonèmes indiqués respectivement par t et par h. De même, en français les deux lettres gn notent normalement la consonne unique dite n mouillé comme l'espagnol ñ (par exemple dans ignare), mais dans stagnant ce groupe représente le g normal de gare suivi du n normal de nul. Si l'on prend sh pour translittérer la consonne appelée shîn en arabe, c'est-à-dire celle qui note le son transcrit normalement ch en français (dans chat), on aura souvent affaire à des groupes s + h, comme dans Ishâk (= Isaac) où on doit prononcer Iss-hâk et rien ne l'indiquera.

Mais le principe « un seul signe pour un seul phonème ou pour une seule lettre " aboutit à une conséquence grave. En effet, l'alphabet latin ne possède que vingt-six lettres. Rares sont les langues qui possèdent si peu de phonèmes, rares les écritures qui possèdent si peu de signes. Dès lors, il n'est qu'une solution : augmenter ce nombre de vingt-six par des artifices qui peuvent se ramener à deux espèces : ajouter des signes adventices sur, sous ou dans les lettres (comme a fait le français lui-même en mettant des « accents » sur l'e, l'a, l'u) ou les déformer (comme ont fait les écritures latines médiévales en créant le j à partir du i). Tout cela est très faisable théoriquement, mais aboutit à une graphie encombrée de signes étranges pour l'usager courant, avec des caractères qu'on ne trouve pas dans les casses des imprimeurs normaux, ni sur le clavier des machines à écrire. Difficiles à reproduire, leur aspect inhabituel peut rebuter le lecteur. Au surplus, leur interprétation suppose la connaissance d'un tableau de correspondance que le lecteur moyen ne connaît pas.

De là la plupart des objections qui s'opposent aux divers projets de systématisation. Il est vain d'espérer faire adopter un système cohérent, donc avec signes diacritiques ou lettres déformées, par les journaux, les ouvrages de grande vulgarisation, les oeuvres d'imagination, les reportages, etc. Les auteurs de ces écrits préféreront toujours (sans doute avec raison) employer des transcriptions non systématiques qui, à leur avis, donneront au lecteur une idée de l'impression auditive produite par le mot original. Peu importent inexactitudes et équivoques. D'ailleurs, pratiquement, il est bien vrai que le lecteur moyen risquera ainsi d'avoir une impression plus exacte que d'après les signes d'un tableau dont il ne connaît pas la clef. Au contraire, les linguistes professionnels, eux, connaissant bien un ou plusieurs systèmes de transcription ou translittération, ont aisément tendance à employer des règles très complexes qui leur paraissent rendre plus précisément les nuances nombreuses d'une prononciation, à user de signes complexes pour aboutir à plus de cohérence scientifique du système. Ils ont toujours tendance à infléchir aussi les règles d'une translittération stricte vers une transcription de la prononciation normale de la langue considérée notant lesdites nuances.

Les projets de systématisation dont il sera question ici ont donc peu de chances d'être adoptés par les auteurs d'écrits courants qui sacrifieront d'habitude la cohérence du système au désir de ne pas rebuter le lecteur. Ceux sur lesquels on attirera surtout l'attention s'efforcent pourtant d'être discrets dans les modifications qu'ils apportent à l'aphabet latin. Ils risqueront alors de ne pas satisfaire les linguistes. A qui donc peuvent-ils servir ?

En premier lieu, on l'a déjà dit, aux usagers des bibliothèques et des cartes géographiques, aux bibliothécaires et aux géographes. Mais aussi, je pense, à une large gamme de textes. Ce sont surtout les spécialistes qui veulent pouvoir retrouver la forme exacte d'un nom ou d'un mot dans une langue non écrite ou écrite dans une écriture non latine. Mais ces spécialistes écrivent aussi des ouvrages qui peuvent être consultés par des spécialistes d'un autre domaine ou par des non-spécialistes. Prenons l'exemple d'un livre ou d'un article sur l'histoire musulmane. Il intéresse les spécialistes de ce domaine et ceux-ci doivent pouvoir retrouver la forme exacte en écriture arabe des noms et mots arabes, persans, turcs, etc. que l'auteur est amené à citer. Mais il peut également intéresser par exemple des historiens du Moyen âge occidental et des lecteurs cultivés tout simplement. C'est le cas de livres de bonne et grande vulgarisation, assez nombreux au total, lisibles par le spécialiste et le lecteur moyen. Citons des ouvrages comme l'Histoire de l'Espagne musulmane d'E. Levi-Provençal, l'Histoire de la littérature arabe de R. Blachère, la traduction du Coran par le même auteur qui doit pouvoir évidemment être consultée aisément par l'historien des religions non spécialisé dans l'Islam. Citons même un répertoire comme la Geschichte der arabischen Literatur de C. Brockelmann qui doit pouvoir être utilisé par des bibliothécaires sans trop de difficultés. Dans tous ces cas, la systématisation de la translittération ou de la transcription est très souhaitable et d'autre part il vaut mieux éviter l'accumulation de signes bizarres qui rebuteront le lecteur non-spécialiste, le feront douter de la forme de tous les noms et finalement le feront renoncer à utiliser l'ouvrage. On n'échappera dans une certaine mesure au dilemme de la cohérence et de l'hermétisme que par une voie moyenne pour des usages moyens 5.

Vers la systématisation

Naturellement le problème est ancien. On peut même considérer que toute création d'écriture nouvelle est une transcription, que tout changement d'écriture est une transcription doublée souvent de translittération partielle de même que toute application d'une écriture à une nouvelle langue. Mais on ne s'occupera ici que de la notation en écriture latine de mots isolés d'une langue non écrite ou écrite en une autre écriture. Sur ce point l'anarchie la plus complète a régné jusqu'au XIXe siècle. En gros, on peut dire seulement que la transcription l'emportait sur la translittération. Autrement dit, chacun notait à sa manière ce qu'il entendait sans se préoccuper d'une correspondance avec l'écriture indigène. Il n'en allait autrement que sporadiquement dans le cas de langues dont il était important de transmettre la forme graphique. C'est à une translittération stricte ne correspondant à aucune prononciation effective que nous devons le monstrueux et traditionnel Jéhovah qui rend l'orthographe hébraïque du nom du dieu d'Israël. Mais aucune systématisation n'intervint avant le XIXe siècle.

Ce fut un homme remarquable qui s'attacha, le premier semble-t-il, à la question, C. F. Volney (1757-1820), un « idéologue » continuateur jusqu'à la Restauration de l'esprit des encyclopédistes, penseur pénétrant et sagace. Il publia en 1795 un ouvrage intitulé Simplification des langues orientales où il proposait un alphabet systématique de transcription des langues du Proche-Orient qu'il s'efforça de généraliser en 1818. Ce système fut adopté en 1803 pour la carte d'Égypte de la Description de l'Égypte, ce splendide et monumental ouvrage qui consigne les résultats scientifiques de l'expédition d'Égypte 6.

On ne fera pas ici l'histoire des essais de systématisation de la transcription et de la translittération. Il suffira d'indiquer quelques repères auxquels il sera fait allusion ensuite. L'effort le plus systématique après Volney, bénéficiant des progrès considérables faits par la linguistique pendant plus d'un demi-siècle, est dû à l'égyptologue allemand Karl Richard Lepsius (1810-1884) qui fut (depuis 1873) directeur de la Bibliothèque Royale à Berlin. Son Standard alphabet 7 qui systématisait des solutions en partie antérieures est la base du mode de transcription-translittération adopté généralement par la suite par les linguistes. Il consacre le principe, défendu déjà par Volney contre les orientalistes de son temps, qui consiste à exprimer chaque son simple par un seul signe, l'emploi de groupes de lettres s'avérant toujours gros d'ambiguïtés virtuelles. Le nombre des lettres de l'alphabet latin étant insuffisant à rendre tous les sons d'autres langues, on l'augmente par l'addition aux lettres de signes diacritiques. Un principe implicite, considéré comme évident, mais dont il vaut mieux prendre conscience, est que la valeur phonétique habituelle des lettres latines (diacritées ou non) employées doit avoir quelque rapport avec le son qu'elles sont appelées à représenter. Autre principe : un même signe diacritique correspond à une classe donnée de phonèmes. Lepsius employait aussi le cas échéant des lettres grecques que les systèmes postérieurs ont, en général, abandonnées, sauf pour certains domaines de la linguistique indo-européenne.

En face de ce système, il faut en signaler essentiellement un autre dont les principes de base sont les mêmes, mais qui utilise, au lieu de lettres latines modifiées par des signes adventices, les mêmes lettres modifiées dans leur forme par allongement de hampes, renversement et autres distortions. C'est le système de l'Association phonétique internationale adopté surtout dans les pays anglo-saxons. La plupart de nous en ont eu connaissance à travers les manuels d'anglais qui l'emploient couramment 8. Les linguistes ont, en général, préféré le système de Lepsius. Cela est dû, surtout, à des considérations pratiques. On peut toujours par exemple ajouter des points ou d'autres signes aux lettres obtenues à l'aide d'une machine à écrire ordinaire. Il est bien plus difficile de se procurer une machine à caractères « phonétiques ». Ou bien il faut renoncer à la machine et écrire à la main son texte.

Parmi les tentatives ultérieures sur la voie de la systématisation, il faut surtout citer la Conférence tenue à Copenhague en 1924 par des linguistes éminents. Elle a surtout abouti à poser des principes clairs. En particulier elle a insisté sur la différence essentielle entre translittération et transcription dont on n'avait pas suffisamment conscience auparavant et à laquelle il a déjà été fait allusion ci-dessus.

La transcription 9 note des sons, mots ou phrases parlées dans une langue ou un dialecte en se basant uniquement sur leur prononciation « sans s'inquiéter de la façon dont ces langues ou dialectes ont pu être écrits jusqu'ici ». La translittération au contraire consiste à écrire en autres caractères (pratiquement les caractères latins) des mots, lettres ou phrases écrits dans d'autres écritures « sans s'inquiéter de la façon dont les mots de ces langues sont actuellement [c'est-à-dire en réalité] prononcés 10 ». La première établit donc une correspondance stricte entre son élémentaire (phonème pour employer un terme scientifique précis) et lettre, la seconde entre signe d'une écriture A et signe d'une écriture B. On ne s'occupera ici que du cas où cette écriture B est l'écriture latine plus ou moins modifiée 11.

La question est entrée dans une nouvelle ère avec la prise en main du problème par un organisme international doté de puissants moyens pour diffuser les normes qu'il adopte, l'ISO ( « International organization for standardization ») 12. L'ISO a été amené à étudier en premier lieu la translittération en écriture latine des diverses variantes de l'écriture cyrillique employée pour noter les langues russe, bulgare, serbe, ukrainienne et russe blanche (ou biélo-russe) 13. On est passé ensuite à la mise en chantier de systèmes de translittération pour le grec, puis l'arabe et l'hébreu 14. L'ISO a pris pour guide un texte important, reproduit depuis au début de chacune des normes de translittération et dû, sous sa forme initiale, à Jean Meyriat. Il est sans doute utile, pour la clarté de l'exposé qui suit, de citer ces quatre paragraphes dont la rigueur va plus loin que tous les textes précédents sur la question :

« La translittération est l'action de représenter les signes d'un alphabet par les signes d'un autre alphabet. Dans ce qui suit, on ne considèrera que la translittération, dans l'alphabet latin, des autres alphabets. En vue des travaux de documentation, l'exigence principale est de permettre la reproduction de textes écrits en alphabets non latins au moyen de machines ou autres outils ne comportant que les caractères de l'alphabet latin et quelques signes supplémentaires (diacritiques, etc...).

« Il s'agit de représenter des caractères et des signes et non des sons; c'est ce qui distingue la translittération de la transcription. Il s'agit de représenter les signes tels qu'ils sont écrits, plutôt que selon leur valeur phonétique ou étymologique. En général, la translittération peut et doit être automatique, afin d'être exécutable par toute personne capable d'identifier la langue dans laquelle le texte original est écrit. Le texte translittéré doit pouvoir être rétabli dans ses caractères originaux par toute personne ayant une connaissance suffisante de la langue dans laquelle il est écrit.

« Elle ne devrait comporter aucune ambiguïté : le même caractère ou signe doit être rendu toujours de la même façon et en principe un signe d'un alphabet ne doit correspondre qu'à un seul signe de l'autre. L'emploi de deux lettres pour rendre un seul signe n'est admis que lorsque l'alphabet latin n'offre pas de possibilité raisonnable de faire autrement (par exemple, dans l'aphabet cyrillique III, dans l'aphabet grec Psi), et en employant alors un groupe de deux lettres qui ne permette aucune équivoque.

« Des signes diacritiques seront ajoutés lorsque ce sera nécessaire; mais on veillera à utiliser le moins possible les signes ne se trouvant pas, par exemple, sur le clavier des machines à écrire comportant des caractères latins » 15.

Néanmoins ce texte omet de mettre en lumière certains principes implicites qui ont guidé les rédacteurs de normes, qui paraissent évidents, mais qu'il y a intérêt, je crois, à exprimer nettement. L'expérience a prouvé en effet qu'il fallait recourir à eux pour trancher certains points discutés à propos de la translittération d'autres langues que celles qui s'expriment en cyrillique. Ces principes sont les suivants :

I° les signes diacritiques, nécessairement employés, seront les mêmes pour une même catégorie de phonèmes (par exemple, le chevron sur la lettre v marquera une prépalatalisation, un point sous la lettre les emphatiques sémitiques, etc.);

2° la possibilité et l'exactitude de la reconstitution éventuelle de l'orthographe originale à partir de la translittération (buts primordiaux) étant assurés, il est bon que la translittération suggère au lecteur non spécialiste une prononciation aussi peu éloignée que possible de la prononciation originale;

3° les mêmes buts primordiaux étant assurés, il serait bon que les lettres latines employées aient la valeur la plus internationale qu'il est possible, ce qui concourt à la réalisation du principe précédent. Autant que possible il vaudrait donc mieux éviter les lettres latines qui ont une valeur très différente suivant les langues comme par exemple le j et le c. Il vaut mieux, si l'on peut, ne pas employer le j pour représenter le son noté y (dans « yeux ») en français comme l'ont fait les Allemands ou le son noté ch dans l'allemand « hoch » comme l'ont fait les Espagnols. C'est ce qui n'a pas été fait (sans doute avec de bonnes raisons) dans la norme ISO sur les écritures cyrilliques. En effet ja, ju y ont été employés pour rendre les sons notés ya, you en français;

4° les signes diacritiques ou modifications de lettres doivent être employés avec autant de discrétion qu'il est possible (formule plus précise que celle du texte cité ci-dessus).

Problèmes particuliers aux écritures sémitiques

Les principales écritures qui servent à écrire les langues sémitiques (avec l'exception notable de l'écriture éthiopienne) posent un problème fondamental non prévu dans les considérations générales exposées ci-dessus. L'arabe, l'hébreu, le syriaque n'écrivent normalement que les consonnes (y compris ce qu'on appelle couramment les semi-voyelles : le w de « watt » et le y de « yeux ») et les voyelles longues. Les voyelles brèves ne sont pas écrites dans la forme la plus ancienne et dans la forme courante de la graphie, par exemple dans les livres ordinaires, les journaux, etc. La structure particulière aux langues sémitiques fait que cette omission, tout en n'étant pas sans inconvénients, n'a pas néanmoins le caractère de vice rédhibitoire qu'elle aurait pour une langue indo-européenne. Néanmoins ces inconvénients ont été sentis anciennement et des signes adventices ont été créés pour indiquer les voyelles brèves (et aussi le cas échéant, pour indiquer la reduplication de la consonne, l'accent, etc.). Ils se placent au-dessus ou au-dessous des lettres, parfois à l'intérieur en hébreu. Ils ne sont employés qu'exceptionnellement dans les textes où tout contresens ou toute prononciation défectueuse doivent être évités (livres sacrés, poésie) ou encore dans un but pédagogique (ouvrages philologiques, livres d'enfants et scolaires, etc.). La règle ci-dessus exprimée, d'après laquelle la translittération part du texte écrit dans l'écriture originale et doit pouvoir aboutir à sa reconstitution exacte, doit donc être interprétée. C'est pourquoi l'ISO a adopté, sur proposition des rédacteurs des normes arabe et hébraïque, l'addition suivante à la « note introductive sur les principes généraux de la translittération » citée ci-dessus : « Pour l'arabe (ou l'hébreu) qui s'écrit habituellement d'une façon incomplète (sans voyelles), la translittération ne peut être automatique, à moins qu'elle ne se fasse à partir d'un texte complété par les voyelles et autres signes habituellement omis. Il en résulte que l'opération de translittération exige une bonne connaissance de l'arabe (ou de l'hébreu), avec recours, s'il y a lieu, aux dictionnaires pour les indications de vocalisation. »

Problèmes particuliers à l'écriture arabe

L'écriture arabe (comme sans doute toute écriture) pose encore quelques problèmes qu'il est difficile de résoudre par simple recours automatique aux règles générales. En voici un que je vais m'efforcer d'exposer d'une façon accessible aux non-arabisants. L'article défini est en arabe al- qui se place devant le nom (par exemple al-kitâb « le livre »). Mais, devant certaines consonnes, le l final de l'article s'assimile à la consonne suivante, par exemple ad-dalîl, « le signe ». Mais la graphie normale, sans voyelles brèves ni signes adventices assimilés, écrit sans noter cette assimilation al-dlîl. La graphie complète ne place aucun signe sur le l ce qui indique qu'il ne doit pas se prononcer. Par contre, elle place un signe de reduplication sur le d. A strictement parler, cette graphie complète note donc al-ddalîl pour indiquer la prononciation ad-dalîl. Une translittération stricte noterait donc al-ddalîl. Mais c'est là aller contre les intentions de la graphie et suggérer une prononciation irréelle et d'ailleurs impossible. Certains systèmes ont cru être fidèles au principe de la translittération en écrivant al-dalîl qui correspond mieux à la graphie incomplète. Mais, en réalité, ils ne notent pas la reduplication du d marquée par la graphie complète et commettent donc tout autant une infraction à ce principe que ceux qui écrivent ad-dalîl. Le choix n'est donc pas primordialement entre al-dalîl et ad-dalîl, mais entre al-ddalîl et une translittération lacunaire sur un point ou sur l'autre. D'autre part, les notions les plus élémentaires de la grammaire arabe enseignent à restituer al- dans l'écriture quand on entend ou quand on voit transcrit ad-dalîl. Si donc on renonce à la translittération stricte (que presque aucun système n'a proposée et qu'aucun système effectivement usité n'a employée), si on veut aussi se référer à la graphie complète comme le recommande le texte cité plus haut, si on veut enfin être fidèle au principe explicité ci-dessus qui pose qu'il est désirable de suggérer la prononciation réelle, la balance paraît pencher en faveur d'ad-dalîl qui correspond à la prononciation réelle et aux intentions de la graphie et qui permet à toute personne ayant des connaissances élémentaires en arabe de restituer la graphie originale 16. Après longue discussion, on a donc adopté dans la norme de l'ISO les translittérations du type ad-dalîl.

Situation des systèmes de notation de l'arabe

Les sytèmes proposés pour transcrire et translittérer l'arabe sont nombreux et remontent loin. Ce n'est pas le lieu ici d'en faire l'historique. Il suffira d'indiquer quelques grandes lignes et quelques points de repère 17.

Des deux types de systèmes de notation indiqués ci-dessus, celui qui procède par modification des lettres latines et celui qui se contente d'ajouter à celles-ci des signes adventices, c'est le second qui a prévalu dans l'usage des arabisants. Seuls certains Britanniques orientés vers la phonétique, quelques linguistes des précédentes générations aussi ont employé le système de l'Association phonétique internationale plus ou moins modifié. Quelques arabisants ont maintenu l'usage d'une ou deux lettres latines modifiées au milieu de lettres se conformant au second type pour bien signifier le caractère unique, spécifiquement arabe du phonème qu'on voulait noter.

Parmi les variantes du second type, il était souhaitable qu'un choix soit fait à l'échelle internationale. L'Académie internationale d'histoire des sciences avait confié une tâche d'unification semblable en 1929 à une « Commission pour la transcription des noms propres des langues n'usant pas de l'alphabet latin ». Le rapporteur, J. Ruska prit pour base le système de la « Deutsche Morgenlândische Gesellschaft » quelque peu modifié. Un rapport de Fr. Taeschner, déjà présenté au 18e Congrès international des orientalistes à Leyde en 193I, puis à l'Académie internationale d'histoire des sciences à Paris en 1932, fut également à la base des travaux de la commission, composée d'éminents orientalistes, désignée en 1934 par la « Deutsche Morgenlândische Gesellschaft » 18. Les'propositions de cette commission furent soumises au 19e Congrès international des orientalistes qui se tint à Rome en 1935. Une commission fut nommée, qui adopta l'ensemble du projet de la D. M. G. avec deux modifications concernant l'arabe dont l'une nettement malheureuse. Le Congrès recommanda l'adoption du projet ainsi modifié.

Mais, d'une part, cette recommandation n'a pas été suivie d'une manière effective. La plupart des orientalistes ont conservé leur façon personnelle de translittérer. Une grande entreprise collective telle que l'Encyclopédie de l'Islam, commençant une seconde édition, ne réforme en aucune manière la translittération adoptée pour la première édition et qui s'écarte fortement du projet de la D. M. G. A la séance du Comité de préparation à Paris, des propositions pour se rapprocher sur un ou deux points au moins des principes adoptés à Rome se sont heurtés à la résistance obstinée de certains orientalistes éminents qui formaient la majorité et le noyau du comité. Les bibliothèques, par exemple, ne se sont pas non plus ralliées unanimement à ces principes. C. Brockelmann lui-même, un des auteurs du projet de la D. M. G., et celui qui a sans doute le plus fait par la suite pour en répandre l'adoption en ce qui concerne la langue arabe (le projet traite aussi du persan, du turc, de l'ourdou et du malais), après une déclaration préliminaire dans laquelle il déclare vouloir suivre les règles posées dans ce projet, les applique avec certaines inconséquences dans la 2e édition et le Supplement de sa Geschichte der arabischen Literatur.

D'autre part - et c'est là, avec la force de la routine, une des raisons de la non-généralisation de l'adoption des règles de la D. M. G. - on a l'impression que l'examen de ce projet au Congrès de Rome ne s'est pas fait avec toute l'ampleur qui eût été convenable pour une mesure de cette importance. Cet examen s'est fait dans le cadre d'une commission très restreinte dont certains membres ne s'intéressaient pas au problème. Quelques lignes seulement lui sont consacrées dans le volume des Actes du Congrès et les propositions de la D. M. G. n'y sont même pas reproduites. Le résultat en est que certains points de ces propositions qui sont contestables et quelquefois liés à des habitudes allemandes n'ont pas été relevés et corrigés comme c'eût été probablement le cas si elles avaient été soumises à une large discussion devant le Congrès. Si cette discussion avait eu lieu, il est probable aussi que l'ensemble des orientalistes se serait senti plus lié par les décisions prises.

Enfin, depuis quelques années, des projets tout nouveaux ont été élaborés qui s'écartent fortement des lignes suivies par la D. M. G. Il en sera parlé ci-dessous.

C'est dans le cadre de cette situation qu'une organisation internationale d'un tout autre type que les sociétés orientalistes, l'ISO, s'intéressa à la question. Ses préoccupations l'amenèrent, on l'a vu 19, à inscrire à son programme la question de la translittération des écritures non latines. En octobre 1952, la question de la translittération des caractères arabes en caractères latins fut abordée sur proposition française et l'AFNOR, membre français de l'ISO, fut chargée par le Comité technique ISO/TC 46 Documentation de préparer un avant-projet qui puisse servir de base de discussion.

La recommandations ISO

C'est que, depuis quelque temps déjà, un système de translittération était à l'étude en France pour les bibliothèques. L'auteur de ces lignes, alors bibliothécaire à la Bibliothèque nationale où il était chargé des imprimés en langues du Proche-Orient, établit un rapport qui fut présenté d'abord à une Commission composée de bibliothécaires. Celle-ci se réunit plusieurs fois à la Bibliothèque nationale au cours du premier semestre 1952. Le rapport fut ensuite présenté à une commission d'orientalistes qui se réunit le 2 juillet 1952 au même endroit. On consulta ensuite par écrit vingt-cinq orientalistes de langue française en France, Algérie, Maroc, Tunisie, Égypte et Liban. A partir des éléments ainsi rassemblés, une commission de l'AFNOR, ayant pour président Mr R. Blachère, professeur à la Faculté des Lettres de l'Université de Paris, et pour rapporteur Mr M. Rodinson, établit un projet de fascicule de documentation portant le sigle DZ n° 46-002 qui fut multigraphié et diffusé largement en décembre 1955. Il comportait, outre les règles de translittération générales, des règles spéciales aux noms propres intéressant surtout les bibliothécaires, d'assez abondants commentaires (en partie repris ci-dessus) et des notes destinées à justifier les solutions adoptées.

Ce document considéré comme avant-projet fut remis au secrétariat du Comité ISO/TC 46 le 4 février 1956. Celui-ci le diffusa parmi les « membres participants » du Comité et reçut des réponses critiques des membres danois, allemand et hongrois, puis autrichien, belge, portugais et néerlandais au cours des années 1957 et 1958. Mais un effort sérieux fut surtout fourni par un groupe de travail britannique qui examina de près l'avant-projet et les critiques qu'il avait suscitées. En gros, il se déclarait d'accord avec les solutions proposées par le premier, mais en trouvait la présentation trop complexe. Il proposait lui-même un texte sous forme de tableau avec des notes réduites au minimum. Cette présentation convenait mieux en effet à une norme de l'ISO. Aussi la réunion plénière du comité ISO/ TC 46 réunie à La Haye en septembre 1958 décida-t-elle de choisir le projet britannique comme second avant-projet et demanda à nouveau leurs observations aux comités-membres. Des réponses substantielles furent reçues de Belgique, d'Israël, de Norvège, de Pologne, de Suède, des États-Unis. Un groupe de travail se réunit alors à Paris les 21 et 22 avril 1959 20. Composé de P. J. M. Geelan de la « Royal geographical society » et du « Permanent committee on geographical names » représentant les Britanniques et de M. Rodinson représentant les Français, il examina l'avant-projet à la lumière des critiques et commentaires qu'il avait suscités. Le texte auquel aboutit le groupe de travail fut adopté par le comité technique ISO/TC 46 et devint le projet de recommandation ISO n° 353. Il fut diffusé, ainsi que le rapport qui l'accompagnait (rédigé par P. J. M. Geelan) et qui expliquait les raisons des décisions prises, et soumis à tous les comités membres de l'ISO. Ceux-ci avaient désormais à voter sur ce projet de recommandation. Vingt membres l'approuvèrent (Allemagne, Autriche, Chili, Espagne, France, Grande-Bretagne, Hongrie, Inde, Israël, Italie, Japon, Norvège, Nouvelle Zélande, Pays-Bas, Pologne, Roumanie, Suède, Suisse, Tchécoslovaquie, Yougoslavie), trois votèrent contre (Belgique, Danemark, États-Unis). Plus de 60 % des votants ayant accepté le projet (en fait près de 87 %), suivant les statuts de l'ISO, celui-ci devint une « recommandation ISO » approuvée par le Conseil en décembre 196I sous le sigle ISO/R 233. Une première édition en fut faite le même mois en anglais, en français et en russe.

Autres systèmes récents

Le long processus qui aboutit, avec les précautions minutieuses que l'on a vues, à l'adoption de la recommandation ISO ne coupa pas court évidemment à la multiplication des systèmes proposés. On se contentera ici d'en citer quelques-uns parvenus à notre connaissance.

Peu après la rédaction du premier avant-projet, G. M. Wickens proposait un système de translittération qui avait l'avantage de n'utiliser que des signes se trouvant sur les machines à écrire ordinaires. Du point de vue théorique, il suivait de façon très stricte les règles de la translittération. Mais ce système montre bien qu'on ne peut négliger le principe posé ci-dessus d'une correspondance minima, entre le phonème rendu par la lettre translittérée et une prononciation assez courante du signe choisi pour translittérer. A titre d'exemple, le système de Wickens écrit le nom du Prophète de l'Islam Muh:em2eduu (dans la recommandation de l'ISO Muhammad), le nom de Dieu 'all2oh (Allah), celui du premier calife omayyade Muxeawyec (pour nous Mu'awiyat, dans le Petit Larousse Moawiya), celui du célèbre calife des Mille et une nuits hearuwnu-alr2eshiyd (ISO : Harun ar-rašid Larousse, Haroun er-rachid), etc. Il est clair qu'un tel système ne peut convenir (à la rigueur) qu'à la communication entre spécialistes dans un cercle très restreint. Il ne pourrait être utilisé dans des ouvrages ou articles consultables par des spécialistes d'autres domaines ou un public plus large tel que celui qui a été défini ci-dessus. Il est d'ailleurs caractéristique qu'un des rédacteurs de la revue Bibliotheca Orientalis, où J. Koopmans avait repris et modifié le projet, fait suivre l'article de celui-ci d'une note où il en montre les inconvénients et propose une méthode simple pour rendre au moyen de la machine à écrire ordinaire... la translittération usuelle du type de celle adoptée par l'ISO 21.

En 1955, Mr Yahya Boutémène de Tlemcen envoyait à l'AFNOR un projet qui consistait plutôt en une réforme de l'écriture arabe, projet qu'il avait fait breveter en 1954. Ce projet, original et intéressant, consistait en fait à transformer les lettres arabes à l'image des lettres latines, les séparant les unes des autres et donnant à chacune une forme constante en toute position. Cela réduisait de façon considérable le nombre des signes typographiques nécessaires pour imprimer l'arabe. D'autre part, il donnait à chaque lettre une forme qui, tout en dérivant des formes arabes usuelles, suivait un canon de proportions analogue à celui des lettres latines. On voit qu'il ne s'agissait pas en vérité de translittération puisque le nouvel alphabet, avec tous les avantages qu'il pouvait présenter sur l'ancien, devait, comme celui-ci, être translittéré en écriture latine. La question qui se posait pour lui était celle de son adoption dans les pays musulmans, ce qui semblait très aléatoire pour des raisons sociales et culturelles. Il ne semble pas d'ailleurs qu'aucun progrès ait été fait en ce sens depuis huit ans 22.

Après l'adoption de la recommandation ISO, un projet turc fut tardivement communiqué au secrétariat de cet organisme. Tout en se rapprochant beaucoup sur de nombreux points du projet adopté, il en divergeait fortement par ailleurs. La base essentielle de ces divergences était dans l'adoption de lettres latines (avec signes diacritiques) correspondant à la prononciation turque des mots arabes pour rendre certains phonèmes arabes. Cela est évidemment à écarter pour des raisons de principe signalées ci-dessus. Pour certaines lettres (surtout les voyelles), on laisse le choix entre deux signes de translittération possibles, ce qui ouvre la voie à des équivoques. Pour rendre d'autres signes arabes, on adopte la lettre latine choisie par les créateurs du nouvel alphabet turc latin afin de rendre le son correspondant (ainsi c représente le son écrit dj en français). Rien ne s'opposerait à ce choix sinon le principe posé ci-dessus (mais de validité intentionnellement restreinte) du caractère international maximum des lettres choisies. Mais l'usage habituel des orientalistes européens a fait triompher auparavant d'autres choix. Il faut signaler surtout que le projet en question semble viser en réalité essentiellement à translittérer le turc tel qu'il était écrit sous l'Empire Ottoman, graphiquement sous la forme de l'alphabet arabe, linguistiquement encombré de môts et même de formes empruntés aux langues arabe et persane et prononcé suivant les lois de la phonétique turque. Pour cet emploi, le projet turc est à prendre en considération. Mais ce n'était pas l'objet du projet ISO qui visait essentiellement l'écriture arabe comme servant à écrire la langue arabe dans les pays arabes.

Récemment le cardinal Eugène Tisserant, orientaliste renommé, a proposé un système de translittération qui a l'avantage de pouvoir être employé sur toutes les machines à écrire ayant des touches indépendantes pour les accents aigu et grave 23. On sait d'ailleurs que ce n'est pas le cas sur les claviers français. Son système est en gros le même que celui adopté par l'ISO avec moins de détails prévus et les points ou autres signes placés sous les lettres remplacés par des accents aigus et graves placés au-dessus, ce qui est, paraît-il, supérieur du point de vue de la lisibilité. En outre, la lettre arabe 'ayn (consonne spéciale à l'arabe), rendue dans la recommandation ISO par l'esprit rude grec, c'est-à-dire une sorte d'apostrophe tournée vers la droite, se voit remplacée par l'apostrophe française telle qu'on l'écrit habituellement et qu'on l'imprime suivie du petit trait qui sert d'apostrophe en général sur les machines à écrire. Tout cela est assez pratique en principe. Mais la seule supériorité sur le système de l'ISO est la facilité de reproduction par dactylographie, inexistante pourtant sur les machines françaises et peut-être sur 'quelques autres. La lisibilité supérieure est discutable d'autant plus que la distinction entre accent grave et accent aigu sur un d par exemple, exige une certaine attention. La cohérence dans l'emploi des signes adventices est moindre que dans la recommandation ISO. Le tableau donné ne prévoit pas tous les détails que prévoit celle-ci. On pourrait admettre le système Tisserant comme une variante du système ISO, commode quand on dispose d'un certain type de machine à écrire.

Le système adopté et son extension éventuelle

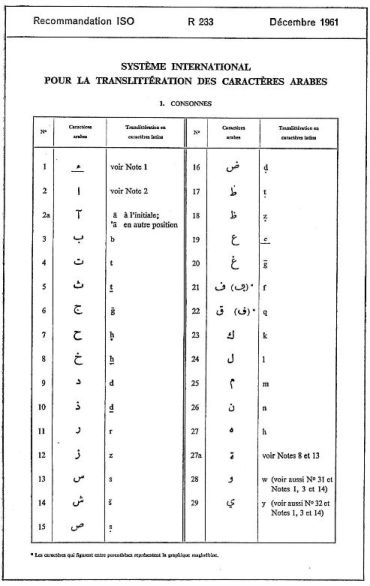

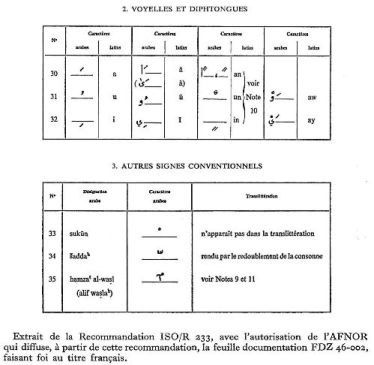

On trouvera en fin d'article la reproduction partielle (sans les notes) de la recommandation ISO 24. Un commentaire détaillé, une réponse aux objections soulevées au cours de l'enquête et ailleurs seraient inaccessibles aux non-arabisants et donc déplacés dans cette revue. J'espère les publier dans une revue spécialisée.

Quelques mots d'explication sont pourtant possibles et nécessaires. La Recommandation contient deux sections de notes sur la translittération avec ou sans i'rab. Ce terme mystérieux indique en arabe les voyelles désinentielles de déclinaison, à la fin des noms, qui sont souvent omises dans la lecture. C'est le cas particulièrement dans les noms propres de sorte que cette omission facilite les notations des bibliothécaires et des géographes. Par exemple des noms courants ou connus comme Muhammad, Ibn Haldun seraient, avec i'rab, Muhammadun, Ibnu Halduna. Des traits d'union ont été employés pour séparer des particules qui, graphiquement, sont liées au mot; c'est une infraction à la translittération stricte puisque rien ne correspond dans la graphie arabe à ce signe. Mais il a l'avantage de décomposer des complexes verbaux que la grammaire arabe décompose elle aussi et qui, tels quels, peuvent masquer aux yeux du profane un mot connu (par exemple titre de livre) ou un nom propre. On s'est résigné aussi à l'usage très critiqué de lettres écrites en exposant au-dessus de la ligne. Cela a paru la manière encore la plus pratique d'obvier à des équivoques qu'admettent la plupart des sytèmes en usage. On n'a rien proposé qui paraisse remplacer le procédé de manière convaincante.

La principale qualité du système adopté par l'ISO est sa cohérence et le nombre de détails qu'il prévoit. Il faut bien voir que le reste est accessoire, par exemple les signes diacritiques employés. On pourrait très bien prévoir des adaptations où une série de signes diacritiques seraient remplacés par d'autres signes ou d'autres moyens, par exemple les points au-dessous de la lettre par une impression de celle-ci en caractères italiques comme cela a été fait parfois 25. Cette transposition ne porterait nullement atteinte à l'esprit du système. Il suffirait comme toujours, d'avertir l'usager et de renvoyer à une table de correspondance.

La question de l'extension éventuelle de l'usage de ce système peut aussi être traitée ici. On a vu ci-dessus à quel type d'usage il pouvait être employé en dehors même des bibliothèques et des cartes géographiques. Certains auteurs de systèmes, en dernier lieu le cardinal Tisserant, ont été plus ambitieux. Leur but avoué est, au moins dans une perspective lointaine, de remplacer l'écriture arabe, dans les pays arabes même, par l'écriture latine telle qu'ils l'ont aménagée pour l'adapter à la langue arabe. Le cardinal Tisserant cite l'exemple de la Turquie kémaliste et de la Chine populaire qui ont remplacé leurs vieilles écritures (le dernier pays cité encore partiellement) par un alphabet latin. Naturellement, rien ne s'oppose techniquement, quoi qu'on en ait dit, à une telle transformation. Les avantages en seraient grands du point de vue de la facilité de l'apprentissage de la langue arabe. Des heures d'étude précieuses pourraient être économisées au bénéfice des enfants. Dans une perspective d'unification mondiale des écritures, qui aurait, elle aussi, bien des avantages, l'alphabet latin est sans doute, à privilégier, nullement à cause de ses qualités intrinsèques 26, mais à cause de la prédominance actuelle à l'échelle mondiale des formes de culture développées dans l'Occident d'écriture latine. On a objecté que, dans les langues sémitiques, la structure de la racine apparaît moins clairement avec l'alphabet latin et la notation des voyelles brèves. C'est oublier que, dans l'écriture arabe elle-même, elle est souvent obscurcie par l'accumulation des voyelles longues, par les affixes et les accidents phonétiques. Les débutants le savent bien qui ont souvent beaucoup de mal à retrouver la racine d'un mot. Mais les difficultés viennent plutôt des conditions sociales et culturelles. En pays musulman, pour le moment, toute réforme de ce genre se heurterait (le fait s'est d'ailleurs produit déjà à plusieurs reprises) à une levée de boucliers basée sur des arguments religieux et nationalistes 27. L'obstacle est infranchissable dans l'état actuel des choses, non seulement pour l'adoption d'un alphabet latin, mais même pour une réforme trop radicale de l'alphabet arabe comme celle de Mr Yahya Boutémène. On sait d'ailleurs combien, en ces matières, en l'absence même d'arguments religieux ou nationalistes, la force du conservatisme culturel est puissant. Il suffit d'évoquer comme exemples l'impossibilité, en France et en Angleterre, d'aboutir à la réforme d'orthographes absolument désastreuses et injustifiables. Tout cela fait que la recommandation ISO doit se borner à des usages limités, mais importants, sans prétendre à bouleverser les habitudes culturelles du monde arabe.

Il faut tenir compte aussi du fait que l'écriture arabe est employée pour transcrire des langues non arabes. L'écriture, en règle générale, va avec la religion et l'écriture du Coran est devenue celle de tous les pays musulmans. Il a fallu une offensive laïque (en Turquie) ou antireligieuse (dans les républiques soviétiques à population musulmane) pour imposer à la place l'écriture latine ou cyrillique respectivement. L'écriture arabe sert donc à écrire le persan, l'ourdou, l'afghan, etc. Elle a subi pour cela quelques adaptations, certaines lettres recevant des points diacritiques ou autres signes adventices supplémentaires. En général pourtant, la non-notation des voyelles brèves a plus d'inconvénients pour ces langues que pour l'arabe et les langues sémitiques. D'où des inconséquences et aussi des difficultés dans la translittération. Il faudrait adapter la recommandation ISO pour qu'elle puisse servir à translittérer aussi ces langues, la difficulté principale étant d'avoir une translittération stricte tout en restant suffisamment proche de la prononciation. On pourrait peut-être mettre en chantier de tels projets en prenant pour base les règles qu'avait autrefois adoptées la D. M. G. en même temps que ses règles arabes.

Il y a aussi le problème difficile de la notation des dialectes arabes. En général, ceux-ci ne sont pas écrits 28, la langue classique étant seule jugée digne d'être confiée à l'écriture. Si on veut noter des mots ou phrases entendus, il faut donc recourir non à la translittération, mais à la transcription et employer un des systèmes de transcription courants. Si pourtant on veut rendre des textes qui, exceptionnellement, ont été écrits en écriture arabe et permettre la reconstitution de cette transcription arabe, il faut là aussi élaborer (à partir de la recommandation ISO de préférence) un système qui soit cohérent du point de vue de la graphie tout en restant aussi proche que possible de la prononciation réelle.

On voit les problèmes qui restent à résoudre. Mais dès maintenant il faut se féliciter de voir un système cohérent et soigneusement étudié adopté à l'échelle internationale par un organisme qui a les moyens de diffusion de l'ISO. Il faut souhaiter que ce système soit de plus en plus adopté par les personnes et les institutions auxquelles se pose le problème.