Le choix des périodiques scientifiques dans le cadre d'une politique documentaire

François Lapèlerie

Une collection de périodiques scientifiques doit s'adapter aux besoins de la recherche, par des suppressions et des adjonctions annuelles. Plusieurs méthodes ont été proposées : l'interview des chercheurs, les études d'usage, les statistiques du prêt entre bibliothèques, lourdes à mettre en uvre et dont les résultats, partiels, ne sont pas toujours satisfaisants. La méthode de l'indice de citation ne produit pas des résultats aussi évidents que ses promoteurs l'affirment, en raison de l'ambiguïté de la notion du concept d'indice de citation. L'étude des citations elles-mêmes semble donner une meilleure base à un travail d'adaptation des collections.

A collection of scholarly journals must adapt to the needs of research through annual suppressions and additions. Several methods have been proposed : interviewing researchers, usage studies and interlibrary loan statistics, which are difficult to put to work and whose results are partial and not always satisfactory. More recently, the use of the « impact factor » indicating the frequency of citation does not produce results as clear as its advocates affirm. This proves the ambiguity inherent in the notion of the « impact factor ». The study of citations themselves, outside of the impact factor, seems to give a better basis for the work of adapting collections.

Eine wissenschaftliche Zeitschriftensammlung muss sich dem Bedarf der Forschung mittels jährlicher Stornierungen und Neuanschaffungen anpassen. Verschiedene Methoden stehen zur Wahl : jede hat Vorteile und Grenzen in der Anwendung. Am Üblichsten sind Interviews mit den Wissenschaftlern, Nutzungsstudien oder die Untersuchung von Statistiken des Bibliotheksleihverkehrs ; all dies ist schwer zu organisieren und erbringt oft nur unvollständige oder unbefriedigende Ergebnisse. Die neuere Methode des Zitierungsindex (impact factor) schliesslich zeitigt nicht immer die von den Promotoren zugesicherten klaren Resultate. Grund dafür ist die begriffliche Zweideutigkeit des Konzepts eines Zitierungsindex. Die Studie der Zitierungen selbst, ausserhalb des Zitierungsindex, scheint eine vielversprechendere Grundlage für eine Anpassung der Sammlungen an die Bedürfnisse der Forscher zu sein.

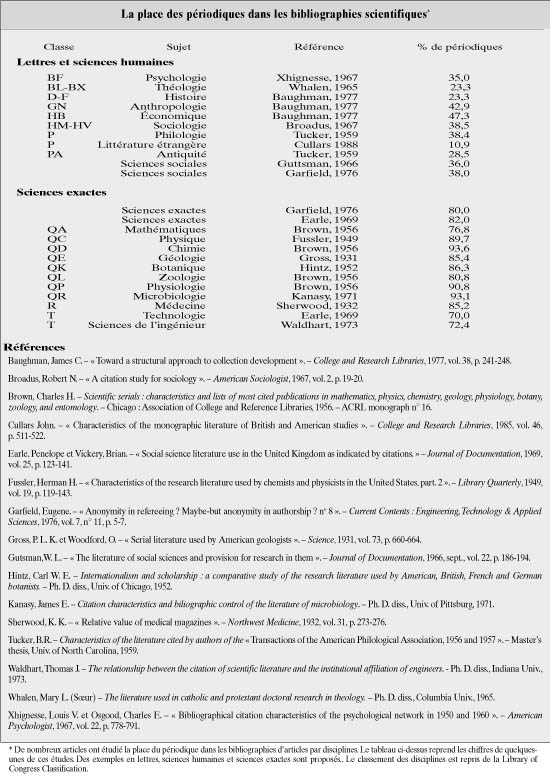

Dans les sciences exactes, l’essentiel de l’information provient des périodiques. De nombreuses études statistiques ont confirmé et précisé cette constatation que peut faire tout bibliothécaire responsable des acquisitions de recherche dans un établissement scientifique. Ces études ont simplement fait le compte des types de documents auxquels les chercheurs font référence dans leur bibliographies, selon les disciplines ; chiffres qui ont ensuite été traduits en pourcentage.

On y constate qu’en sciences exactes le périodique est le vecteur essentiel de la communication, que l’on se contente d’un pourcentage global ou que l’on descende au niveau de chaque discipline, et cela à un niveau peu soupçonné. La plupart de ces études sont d’origine américaine : les disciplines y sont donc étudiées selon la classification de la Bibliothèque du Congrès. On arrive ainsi aux deux extrêmes : un taux minimal d’utilisation du périodique de 10,9 % en littérature (classe P) et un taux maximal de 93,6 % en chimie (classe QD). Le tableau ci-contre (cf. tabl. 1) donne un aperçu des différentes disciplines 1.

Ces études peuvent avoir plusieurs utilisations. Elles peuvent servir de base à un système d’allocation des crédits, entre périodiques et livres selon les disciplines. Elles démontrent aussi qu’en sciences exactes l’essentiel d’une politique de développement des collections consiste à sélectionner des périodiques, puisqu’ils constituent de 80 à 90 % des documents effectivement utilisés par les chercheurs.

Suppressions et ajouts

Le bibliothécaire est donc dans l’obligation d’ajuster, d’adapter les collections de périodiques aux besoins des chercheurs et aux circonstances. Cette adaptation se traduit par des suppressions et des adjonctions quasi annuelles. Ajouter a toujours été une tâche supposée agréable pour un bibliothécaire, alors que supprimer a souvent été ressenti sinon comme une trahison, du moins comme une tâche peut-être nécessaire mais regrettable. Il semblait à une certaine époque que l’on préférait continuer une collection, décorative sans doute, plutôt que de supprimer un titre devenu inutile pour en ajouter un nouveau qui soit utile.

Les suppressions ne sont cependant pas systématiquement une tâche désagréable due à un manque d’argent : les ressources forcément limitées – à un niveau plus ou moins haut – d’une bibliothèque contraignent le bibliothécaire à adapter ses fonds aux besoins de la recherche, donc à supprimer et à ajouter des titres. Les suppressions sont un processus normal de gestion d’une collection de périodiques, à condition qu’elles soient compensées, toutes choses égales, par des acquisitions mieux ciblées. Cependant, au moins dans les bibliothèques scientifiques françaises aujourd’hui, ce sont les suppressions pures et simples qui sont à l’ordre du jour pour trois raisons évidentes : les augmentations de tarif des abonnements, les variations récentes, vers le haut, du taux de change du dollar et de la livre sterling 2, et, est-il besoin de l’ajouter, la stagnation, voire la diminution dans certains cas, des subventions ministérielles.

Un bibliothécaire préférera toujours ajouter plutôt que supprimer un abonnement parce qu'intellectuellement, ajouter lui semblera plus simple que supprimer. Supprimer ou ajouter sont cependant deux facettes, l’une négative, l’autre positive d’un même processus. Il s’agit dans un cas de trouver les périodiques qui sont les moins utiles aux chercheurs, dans l’autre cas les périodiques qui seraient les plus utiles auxdits chercheurs. Le critère essentiel de choix semble l’utilité. Conclusion théorique évidente sur laquelle tout le monde sera d’accord, y compris les chercheurs, mais qui n’avance pas beaucoup dans la voie de la solution concrète, sur laquelle plus personne ne sera d’accord, y compris et au premier rang, les chercheurs. La notion d’utilité, sans y impliquer un utilitarisme philosophique, est très subjective et s’accommode mal de critères strictement objectifs : chacun voit son utilité et on peut se demander si la somme des utilités individuelles est forcément la représentation de l’utilité collective.

Avant d’aller plus avant, il faut faire état d’une évidence. Le critère financier est très important, puisque souvent les suppressions se font en période de pénurie financière (c’est ce que j’ai appelé « adaptation aux circonstances »). Combien coûte tel titre et quel est son ratio d’utilité en fonction de son coût sont des questions que le bibliothécaire se pose bien évidemment, et souvent avant toute autre. Cependant cette problématique ne sera pas étudiée ici : seules les manifestations de l’utilité intellectuelle des périodiques seront étudiées, hors de toute considération matérielle.

Seconde remarque tout aussi importante. Que l’on crée une bibliothèque nouvelle, que l’on ajoute des titres à une collection existante ou que l’on en supprime et quel que soit le moyen utilisé pour déterminer l’utilité relative des périodiques, sont visés par définition les périodiques dont l’utilité marginale est faible ou très faible et non pas les périodiques fondamentaux sur lesquels la majorité des utilisateurs sera en général toujours d’accord. Il est donc naturel que, plus on s’éloigne du noyau dur d’une collection, plus les conclusions divergent dans une très forte proportion.

Comment choisir ? Quels critères traduiront cette notion d’utilité ? Il semble que la solution miracle ou au moins idéale n’existe pas. Ce qui explique que la littérature professionnelle abonde sur le sujet.

Plusieurs types de solutions ont été proposés. Tout d’abord, la solution qui semble la plus simple : interroger les chercheurs eux-mêmes pour avoir leur avis. Ensuite les études d’usage : comptabiliser sur une certaine période de temps les périodiques réellement utilisés par les chercheurs. Enfin, les études de citations : utiliser des publications comme les Science Citation Index (SCI) et les Journal Citation Reports (JCR).

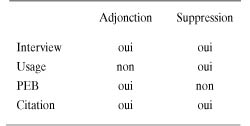

Ce sont là les trois principales méthodes les plus fréquemment citées sinon utilisées. Certains auteurs en ont proposé d’autres, tout aussi valables mais moins utilisées parce que longtemps difficiles à mettre en œuvre sans l’aide de l’informatique. Parmi ces méthodes, on relève par exemple l’utilisation des statistiques du prêt entre bibliothèques. Chacune de ces méthodes a sa spécificité, ses avantages et ses inconvénients (cf encadré « Adjonction - Suppression »).

Toutes ne peuvent servir aux deux opérations envisagées, la sélection et la désélection 3. Seule l’interview et la citation le permettent.

L’interview

L’interview est une méthode simple et peu coûteuse, sinon en temps. De nombreux articles et études l’ont décrite. S’il s’agit de supprimer des abonnements, on peut simplement soumettre aux chercheurs concernés la liste des abonnements souscrits et leur demander leur avis.

On peut le leur demander oralement, au cours d’une véritable interview, ce qui est préférable : au moins aura- t-on une réponse, alors que le taux de retour à un questionnaire envoyé par courrier est très faible sur ce sujet. On peut aussi leur demander d’attribuer des étoiles aux périodiques, en fonction de leur utilité, comme le font les guides gastronomiques pour les restaurants.

Une fois collationnés, ces résultats devraient donner un moyen de juger de l’(in)utilité des périodiques. Cependant, il apparaît évident qu’utilité et qualité ne sont pas synonymes : un périodique pourra être cité par ce genre d’enquête ou par tel(s) chercheur(s) et n’être pas d’une qualité scientifique exceptionnelle et, par conséquent, ne pas apparaître dans les autres types d’enquête. Ils ne seront par exemple jamais cités dans les bibliographies alors qu’ils sont très utilisés. C’est le cas de périodiques généraux, de périodiques de vulgarisation, de périodiques techniques ou professionnels, pourtant très utiles et très utilisés 4.

Autre éventualité : le chercheur ne citera pas ces périodiques à l’enquêteur pour qu’on ne pense pas qu’il les utilise (on sait qu’en général, lors d’une interview, une forte proportion des personnes interrogées ne répond pas sincèrement : la réponse est souvent soit celle que l’interviewé s’imagine que l’interviewer attend de lui, soit une réponse que l’interviewé juge valorisante). Un autre inconvénient provient aussi et essentiellement du conservatisme des chercheurs qui préfèrent toujours avoir la possibilité de lire une revue le cas échéant, même s’ils ne la lisent effectivement jamais, plutôt que de la voir disparaître de leur bibliothèque. Le réflexe habituel du chercheur devant un périodique dont l’utilité est (très) marginale est toujours un réflexe de conservatisme, qui rejoint ici le conservatisme du bibliothécaire, amateur de belles collections, sans lacunes (si possible reliées). Cette conjonction produit rarement de bons résultats.

Toujours dans le cadre de l’interview, s’il s’agit d’ajouter des abonnements nouveaux, on peut procéder de deux manières. Soit simplement en demandant aux chercheurs quels périodiques leur seraient utiles ; soit en leur soumettant une liste de titres susceptibles de leur être utiles et, dans les deux cas, en classant ces périodiques par ordre de priorité.

La première méthode a l’inconvénient d’aboutir souvent à des listes-fleuves de périodiques peut-être encore plus marginaux les uns que les autres. La seconde méthode a l’avantage de limiter les propositions d’achat et parfois d’informer certains chercheurs sur des nouveautés éditoriales qu’ils peuvent ignorer. Cependant, ce sera toujours un choix très subjectif de la part des chercheurs, parce que d’une part le choix doit porter sur des périodiques, en principe marginaux (on peut en effet imaginer que les périodiques fondamentaux sont déjà souscrits), et que, d’autre part, il arrive qu’on leur demande leur avis sur des périodiques qu’ils connaissent peu (simplement par la lecture d’un article obtenu par le prêt entre bibliothèques, par exemple) ou pas du tout.

L’interview n’a donc qu’une utilité somme toute très limitée parce que sa méthodologie ne repose sur aucun critère objectif. Dans ces conditions, ses résultats peuvent être qualifiés au mieux d’indicatifs et au pire de peu fiables. Son intérêt est d’autant plus limité qu’il implique un temps de traitement des informations qui est directement proportionnel au nombre des abonnements à supprimer ou à ajouter et au nombre des chercheurs à consulter : ce temps peut donc être très long, pour un résultat très décevant.

L’enquête d’usage

La seconde méthode consiste à étudier l’utilisation effective des périodiques par les chercheurs, pour déterminer quels sont les périodiques les plus utilisés et, par voie de conséquence, quels sont les moins utilisés. Il ne s’agit plus de se fier à une appréciation subjective du chercheur, mais de constater les périodiques effectivement, matériellement, utilisés. Le principe en est très simple, même s’il est fastidieux à mettre en pratique.

Deux cas se présentent. Ou bien la bibliothèque ne pratique pas l’accès libre – ce qui est désormais rare – et dans ce cas il suffit de faire le bilan, grâce aux fiches de prêt, des titres demandés, du nombre de fois où ils ont été consultés et si possible des années consultées. De nombreuses bibliothèques le faisaient, et cette tâche peut être éventuellement rendue plus facile grâce à l’informatique. Ou bien, dans le cas des bibliothèques qui pratiquent l’accès libre – les plus nombreuses – on demande aux chercheurs de ne pas reclasser5 eux-mêmes les périodiques qu’ils ont utilisés : le personnel les reclasse, tout en cochant sur des listings prévus à cet effet les titres et éventuellement les années utilisés.

Cette méthode donne des résultats plus satisfaisants que la première pour le choix des suppressions, mais on ne peut l’utiliser pour les adjonctions. Elle repose sur un critère objectif : l’utilisation effective d’un périodique, dûment constatée. Elle permet également de relever les années utilisées, indice important d’utilité. L’intérêt d’un périodique en effet peut varier dans le temps : soit le contenu ou la qualité du périodique change, et il intéresse moins les lecteurs ; soit les thèmes de recherche d’une institution changent et les chercheurs n’ont plus besoin d’un périodique. Ce renseignement est rarement fourni par les chercheurs dans le cadre de l’interview, toujours en raison du conservatisme latent de la corporation.

Cette méthode permet aussi de vérifier l’utilisation éventuelle de certains titres qui ne sont pas cités par la suite dans les bibliographies pour différentes raisons, dont on a vu certaines plus haut. Pour obtenir le résultat le plus probant possible, il est nécessaire de faire cette enquête sur une période de temps suffisamment longue. En effet, la consultation des périodiques n’est pas, en général, une activité quotidienne des chercheurs et il faut laisser le temps à tous les chercheurs d’une faculté, dans toutes les disciplines, de consulter suffisamment de périodiques avant de tirer des conclusions. Un mois au moins est souvent nécessaire pour que l’enquête livre des résultats directement utilisables. L’inconvénient essentiel est, outre la durée de l’enquête, le caractère assez fastidieux de la méthode.

Cette méthode donne cependant un meilleur résultat que la première, dans le cas de projets de suppression seulement, puisqu’on ne peut évidemment pas l’utiliser pour des adjonctions.

Le prêt entre bibliothèques

On peut dans ce cas précis utiliser les statistiques du prêt entre bibliothèques, qui, elles aussi, sont plus objectives. Le principe est très simple. Il s’agit d’exploiter les statistiques des demandes de photocopies d’articles, titre par titre, et si possible en tenant compte des années demandées. Ce travail est grandement facilité par les systèmes informatisés de prêt entre bibliothèques actuellement utilisés, qui permettent d’éditer la liste des titres demandés, le nombre de fois où ils sont demandés et éventuellement les années demandées.

Cette statistique, reflet exact des demandes, permet de savoir de façon fiable quels seraient les périodiques les plus utiles. Il ne faut cependant pas oublier l’attitude malthusienne des chercheurs qui, par économie6, hésitent souvent à demander une photocopie payante, alors qu’il liraient ou feuilletteraient certainement un article s’il l’avaient sous la main « gratuitement » dans la bibliothèque.

Si cette méthode est plus conforme à la réalité, on fait cependant en général une constatation similaire à celle que l’on peut faire à la lecture des titres demandés aux chercheurs par interview : en dehors de certains titres qui sont demandés fréquemment ou assez fréquemment en prêt entre bibliothèques, et qui peuvent être de bons candidats à l’abonnement, on constate toute une série de titres peu ou très peu demandés (1 ou 2 fois dans l’année). Ce qui amène à la même conclusion que précédemment : en dehors d’un noyau dur, la dispersion est très grande et les titres marginaux sont très nombreux.

La méthode des citations

Enfin existe la méthode des citations. Certaines bibliographies et certains services vendus – fort cher – par l’Institute for Scientific Information de Philadelphia (PA) permettent une approche supposée plus scientifique du problème. Ces bibliographies sont les différents index de citations : Science Citation Index (SCI), Social Science Citation Index (SSCI), Art and Humanities Index (AHI), Journal Citation Report (JCR). Parmi les services, on peut relever le Local Journal Utilization Report (LJUR) (2).

La méthode la plus traditionnelle pour qui utilise ces outils bibliographiques consiste à avoir recours aux indices de citation 5 des revues indexées. Ainsi l’édition scientifique du JCR, qui existe sous forme de cédérom, donne-t-elle tous les ans un relevé complet des indices de citation de toutes les revues analysées par le SCI, pour les sciences exactes. A partir de ce fichier, on peut éditer des listes de périodiques, soit générales, soit spécialisées dans une des disciplines scientifiques définies par le Science Citation Index. Ces listes peuvent être sorties soit par ordre alphabétique de titres, soit par ordre décroissant d’indice de citation. Ainsi, le bibliothécaire est censé pouvoir faire une évaluation des collections de sa bibliothèque, en comparant les abonnements de son établissement aux listes « évaluées » extraites du JCR. On peut ainsi, dans les deux cas qui nous intéressent, sélection et désélection, repérer les titres qui sont supposés être les plus fondamentaux ou les plus marginaux.

Cette façon de procéder est-elle, sous son apparente simplicité, aussi efficace qu’elle en a l’air ?

On peut faire deux critiques fondamentales à cette méthode, qu’on peut brièvement résumer. Tout d’abord quelle est la valeur de l’indice de citation ? L’indice de citation est source de malentendu entre chercheur et bibliothécaire, car, pour le premier, il est et il a valeur d’indice de qualité d’une publication périodique, alors que le bibliothécaire cherche un indice d’usage de cette publication. Ce qui nous conduit à la seconde critique : c’est l’assimilation de l’indice de citation à un indice d’usage. En effet, implicitement, indice de citation devient synonyme d’indice d’usage, ce qui n’est pas évident. Une controverse entre Broadus et Line (3, 7) a mis à jour cet abus de langage, qui devient un abus de méthode, souligné également dans de nombreux autres articles (8, 12).

Quant aux résultats, on peut faire les constatations suivantes. Tout d’abord, on peut remarquer que la connaissance des revues fondamentales ne nécessite pas le recours au JCR : tout scientifique, chimiste, physicien, etc., pourra dire instantanément et sans risque d’erreur quelles sont les revues vraiment essentielles dans sa discipline. Le JCR n’est alors qu’une confirmation (coûteuse, faut-il ajouter).

Deuxièmement, si l’on veut avoir recours à cette méthode, il ne faut pas utiliser la liste globale des périodiques, toutes disciplines confondues, mais n’utiliser que les listes par discipline. En effet, les pratiques de citation diffèrent grandement selon les disciplines : certaines disciplines citent beaucoup, d’autres moins, d’autres encore peu. Mélanger toutes les disciplines aurait pour conclusion l’élimination de disciplines entières (écologie, océanographie, mathématiques, etc.) au profit des disciplines citant beaucoup comme la biologie (13, 14).

Troisièmement, si on a recours aux listes toutes faites des différentes disciplines scientifiques élaborées par l’ISI, et que l’on s’abonne systématiquement à ces revues (dans la limite de ses moyens), on ne manquera pas d’avoir quelques problèmes avec les chercheurs. Ces listes par discipline sont toutes théoriques et ne sont pas, en général, le reflet de l’usage qu’un établissement pourra avoir des périodiques. Encore une fois, le rang, bon ou moins bon, d’un périodique ne signifie pas automatiquement une corrélation avec un éventuel usage plus ou moins fréquent.

Tel titre classé en 1er (ou en excellent rang) pourra très bien ne jamais – ou peu souvent – être utilisé : ainsi le Journal of Stereochemistry, à l’indice très élevé, se trouve en tête de la liste des périodiques de chimie organique, alors qu’il est très rarement (ou jamais) utilisé par des organiciens ou des spécialistes de synthèse organique.

Ces listes sont toutes théoriques et doivent être manipulées avec précaution. Une enquête d’usage est nécessaire avant de supprimer un périodique à l’indice faible ou même un périodique non indexé au JCR 6. De même, pour sélectionner de nouveaux abonnements, il vaut mieux ne pas se contenter de choisir des titres sur la liste des candidats pourvus d’un haut indice de citation : une enquête sur l’utilité future de ce périodique est nécessaire. Comme il a déjà été dit, le malentendu sur la valeur de l’indice de citation conduit le bibliothécaire et le chercheur à des conclusions différentes sur tous ces choix, ce qui justifie une étude d’utilité (15).

Le Local Journal Utilization Report

Quoi qu’il en soit, l’utilisation des différents indices produits par l’ISI ne dispense pas d’une étude d’usage. Or ces études d’usage sont, comme on l’a vu, fastidieuses à réaliser manuellement et incomplètes.

On a donc pensé faire des études d’usage à partir des citations effectuées par les auteurs dans leurs bibliographies : répertorier par exemple les revues citées en bibliographie donnerait une vision plus exacte des revues utilisées. Quelques auteurs ont réalisé manuellement ce genre d’étude. Mais l’ampleur du travail a limité ces études à des échantillonnages pas toujours assez nombreux (16, 19).

Depuis peu de temps, l’ISI propose un nouveau service qui permet d’obtenir, sans peine, cette étude d’usage par citation, très complète. En effet le Local Journal Utilization Report (LJUR), que l’ISI peut réaliser à la demande pour tout établissement, offre des résultats très complets sur l’utilisation des périodiques et autres documents, jamais proposés jusque-là.

Le LJUR est un produit informatisé (payant) qui analyse l’utilisation des différents documents (donc des périodiques) faite par les chercheurs d’une institution (université, faculté, laboratoire, etc.). Deux types de résultats sont présentés : les revues dans lesquelles les chercheurs publient, et les revues qu’ils citent, cela sur la période 1981 à 1998.

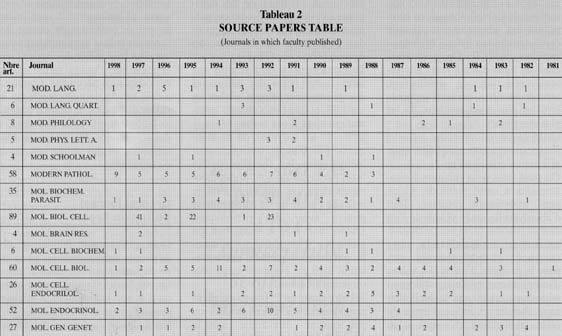

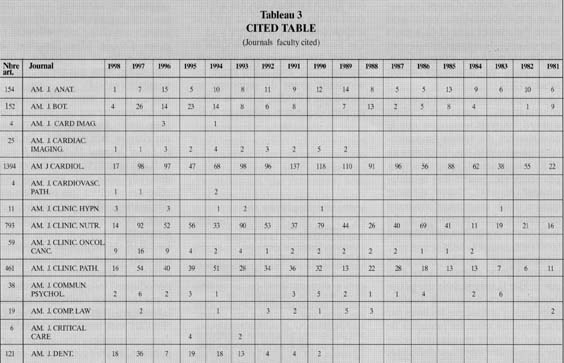

Des bases de données de l’ISI sont extraits tout d’abord tous les articles publiés par les chercheurs de l’institution choisie, de 1981 à la dernière année indexée, soit 1998. De la base ainsi créée, sont ensuite extraites, année par année, deux listes différentes.

D’abord la liste complète des revues dans lesquelles les chercheurs ont publié, détaillées année par année, avec, pour chaque année, le nombre d’articles publiés. Ensuite la liste complète de toutes les publications que les chercheurs ont citées dans leurs bibliographies.

La première liste, intitulée Source Journal (ou Source Papers) ne peut inclure que les revues indexées par l’ISI (cf. tabl. 2 ci-contre). La seconde, intitulée Cited Journals, inclut toutes les revues citées par les auteurs dans leurs articles (cf. tabl. 3 ci-contre). Donc, non seulement des revues indexées par l’ISI, mais aussi tous les documents cités (revues, livres, thèses, congrès, rapports, etc.) non indexés par l’ISI 7.

Pour ces deux listes, les données sont présentées globalement pour la période 1981-1998 et aussi détaillées année par année. Cela permet d’analyser les tendances dans le temps et de mettre à jour des variations d’utilisation des périodiques.

La liste des Source Journals permet d’analyser dans le temps et sur une longue période les revues dans lesquelles les chercheurs publient. On constate une dispersion extrême des revues cconcernées : nombre de titres ne sont cités qu’une fois ou deux. On peut cependant détecter les éventuelles tendances et évolutions dans le choix des revues où les chercheurs décident de publier et ainsi anticiper des choix concernant la sélection ou la désélection des abonnements.

La liste des Cited Journals permet d’analyser, là aussi, les revues et documents que les chercheurs utilisent puisqu’ils les citent, qu’il soient ou non indexés dans le SCI : cela peut donc permettre une vue plus réaliste sur des demandes d’abonnement nouveaux qui ne seraient pas justifiées par un taux d’utilisation réel et important par exemple 8.

Le LJUR est donc le système le plus approprié à la mise en œuvre d’une politique de développement de collection dans une bibliothèque scientifique.

Utilisant d’une manière judicieuse et non contestable – au contraire du facteur d’impact – les bases de citation, il permet d’avoir un reflet exact de l’usage réel des périodiques utilisés à la fois pour publication et pour citation par les chercheurs.

Ces tableaux sont livrés par l’ISI sous forme de disquettes en format Access ou DBase : cela permet de retravailler les données pour en avoir toutes les présentations possibles. Le seul inconvénient du LJUR est son coût : 6 000 $ aujourd’hui 9.

A défaut de pouvoir payer une telle étude, un bibliothécaire, qui aurait le temps, peut utiliser un programme informatique élaboré par un collègue américain (20). Ce programme permet d’obtenir quelques résultats intéressants, et cela sans frais. Le seul préalable est d’avoir accès au SCI-CDE (ou SCI, Compact Disc Edition).

Le programme de William Loughner 10 traite les données année par année (pour des raisons de capacité du cédérom, le SCI-CDE est présenté année par année ; mais on peut regrouper des années). S’il ne produit pas l’équivalent du Source Journal, il procure l’équivalent approché du Cited Journal. Il faut seulement avoir le temps et la patience de le faire 11. Sa particularité est de donner la possibilité d’ajouter le coût de chaque abonnement, ce qui permettra à toute personne intéressée de faire des calculs de prix de revient, en fonction de l’indice de citation et du nombre de publications.

Seul ce genre d’enquête permet de rapprocher et de concilier étude de citation et étude d’usage. Les résultats permettent de faire une évaluation la plus proche des pratiques réelles des chercheurs, hors de toute influence d’une enquête souvent partielle et d’un enquêteur peut-être partial, ou d’un facteur d’impact dont la signification n’est sans doute pas toujours la même pour un chercheur et pour un bibliothécaire, puisqu’ils ont, en la matière, des objectifs différents (évaluation de qualité pour le chercheur, éva-luation d’utilisation pour le bibliothécaire).

Les résultats de cette enquête permettent ensuite de comparer ces données aux réalités des collections de la bibliothèque ; puis d’ajuster les collections à ces pratiques, en tenant compte, évidemment, des ressources de la bibliothèque concernée, ce qui est un autre problème.

Janvier 1999