Schéma directeur de l'information bibliographique : test sur les bases bibliographiques

Rapport du bureau Marcel van Dijk

L'étude qui suit présente les résultats du test quantitatif et qualitatif de 5 bases bibliographiques disponibles en France :

- BN-OPALE (BN), - ELECTRE (Cercle de la librairie/SBD),

- SIBIL (BU de Montpellier),

- OCLC (BU de Nice),

- et la base du réseau coopératif de la DLL (CNCBP).

Ce test était réalisé dans le cadre du schéma directeur de l'information bibliographique. Le groupe de projet avait proposé d'organiser à la fin de l'étape de bilan du Schéma directeur un test sur les bases bibliographiques existantes. Le comité directeur, réuni le 27 octobre 1988, avait approuvé le principe de ce test. L'objectif du test était de permettre, à partir d'un échantillon de commandes de bibliothèques françaises, d'évaluer :

- le degré d'exhaustivité des bases et leur taux de recoupement par rapport aux différents fonds (livres pour enfants, romans, documentaires) des deux grands types de bibliothèques (lecture publique et BU) et aux différentes origines (livres français et livres étrangers). L'exhaustivité a été appréciée en constatant la présence ou l'absence de la notice à la commande de l'ouvrage. Pour des raisons matérielles, il n'a pas été possible de doubler les tests en recherchant les notices une fois le livre arrivé à la bibliothèque, comme l'avait envisagé un moment le groupe de travail du Schéma directeur.

- le degré de « fraîcheur » des notices. Les commandes faites par les bibliothèques de lecture publique portaient pour une large part sur des ouvrages très récents. Mais cela n'a pas été le cas pour les BU : pour le deuxième test la plupart des ouvrages étaient publiés depuis deux ou trois ans.

- la qualité des notices quant à la forme et au contenu des informations fournies.

Les échantillons de notices de commandes ont été constitués par un groupe composé de :

- un représentant de la DLL,

- un représentant de la DBMIST,

- le consultant du Bureau van Dijk.

Leur constitution s'est faite à partir de notices de 8 bibliothèques (bibliothèques municipales de Bordeaux, Caen, Cergy, Toulouse, Tours, Valence et BCP de l'Essonne et de Saône-et-Loire) et de 2 BU (Paris-Sorbonne et Dijon).

Le déroulement du test

Le test s'est déroulé en trois étapes successives :

- le premier test (17 et 18 janvier 1989) auquel ont participé BN-OPALE, SIBIL, ELECTRE et le Réseau coopératif de la DLL a porté uniquement sur des commandes issues de bibliothèques de lecture publique, car la DBMIST n'avait pas encore donné son accord pour y participer ;

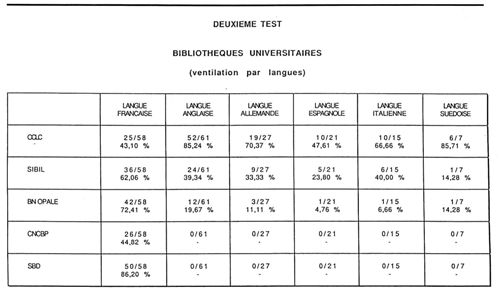

- le deuxième test (14 et 15 février 1989) auquel les 5 bases ont participé a porté sur les commandes des bibliothèques de lecture publique (178 titres français) et de BU (189 titres en français et en langues étrangères). A partir des réponses à ce test, il a été demandé aux 5 bases de fournir les notices complètes en format de 32 titres. Ces notices ont constitué l'échantillon pour l'analyse qualitative ;

- la troisième vague de tests (18 et 19 avril) à laquelle ont participé le Réseau coopératif de la DLL, SIBIL, BN-OPALE et ELECTRE a également porté sur des commandes issues de bibliothèques de lecture publique (160 titres) et de BU. SIBIL et le CNCBP ont, pour l'un et l'autre test, décalé leur participation, généralement pour des raisons de charge de travail.

La participation en pointillé d'OCLC s'explique pour les raisons suivantes :

- lors du premier test, la participation de la DBMIST au Schéma directeur de l'information bibliographique n'était pas effective. La participation de SIBIL a pu être acquise mais celle d'OCLC, soumise à l'agence OCLC anglaise pour des raisons juridiques, n'a été possible que pour le deuxième test ;

- la bibliothèque de Nice, choisie pour tester la base OCLC, était réservée sur le principe même du test car elle n'avait pas été informée de son contenu et de ses objectifs ;

- pour le trosième test, à la suite d'un problème de transmission de l'information (à un moment où la DBMIST était en pleine réorganisation), la bibliothèque de Nice a fourni ses notices de commande, pensant qu'un autre site assurerait le test pour OCLC ;

- il faut noter que seuls la Bibliothèque nationale et le SBD du Cercle de la librairie ont participé aux trois tests sans en remettre en cause les conditions.

Analyse quantitative des résultats du test

Résultats

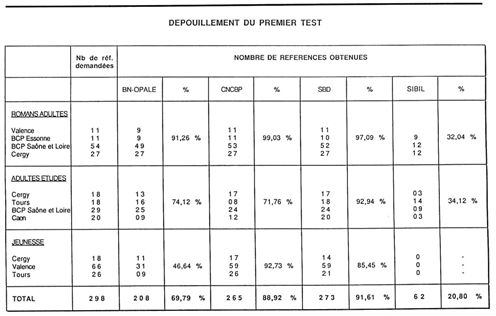

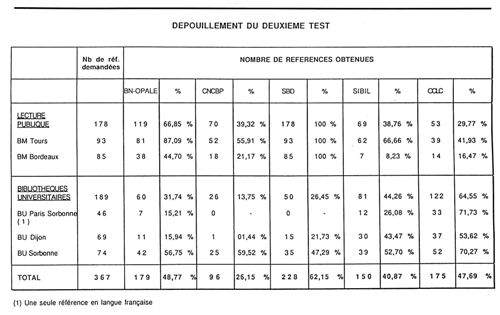

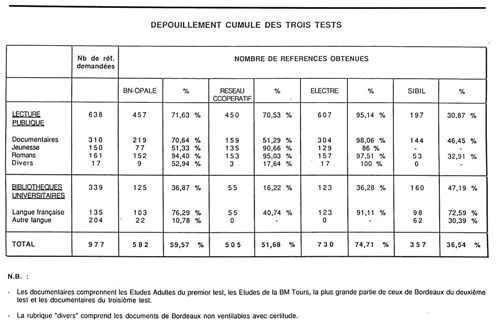

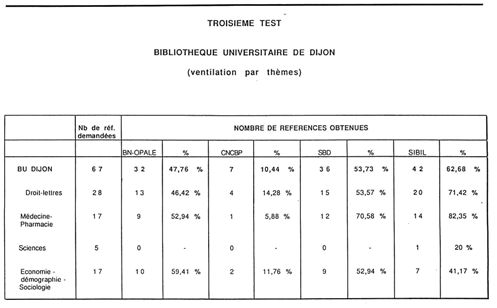

Les tableaux qui suivent présentent les résultats :

- des trois tests successifs (trois premiers tableaux),

- du cumul des trois tests,

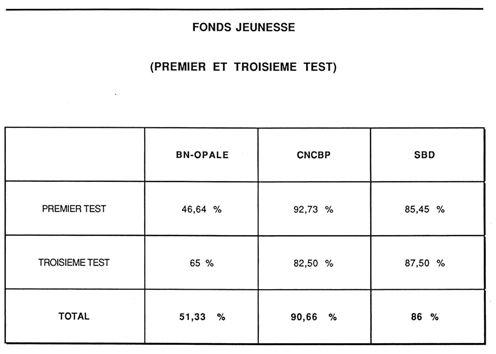

- des approches spécifiques (fonds jeunesse).

Commentaires

Fonds lecture publique

Pour cette catégorie, c'est ELECTRE, base du Cercle de la librairie, qui, globalement, a les meilleurs résultats. Ceci s'explique par le fait que :

- le Cercle de la librairie couvre la production courante française à raison de 20 000 notices par an environ,

- les commandes des bibliothèques de lecture publique se font largement à partir de Livres Hebdo.

Les résultats de la base du Réseau coopératif (particulièrement ceux du premier test, très orienté « grand public ») indiquent que cette base correspond bien aux fonds des BM et BCP, cette base assure notamment la meilleure couverture pour le fonds Jeunesse.

Les résultats globalement moyens de BN-OPALE résultent de son faible score sur les livres pour la jeunesse (51,33 % pour la moyenne des tests), alors qu'elle atteint 94,40 % pour les romans (moyenne du premier et du troisième test). La BN explique ces résultats par les effets de la montée en charge lors du premier et deuxième test, le mode de traitement des réimpressions et notamment des bandes dessinées et de lacunes dans le Dépôt légal.

La médiocrité des résultats de SIBIL ne doit pas surprendre dans la mesure où cette base est alimentée par des bibliothèques universitaires et ne prend pas en compte les livres pour enfants.

Enfin, les résultats d'OCLC ne sont guère significatifs puisque le deuxième test, seule étape de l'évaluation à laquelle OCLC ait participé, ne portait que sur des commandes issues des sections Etudes de grandes bibliothèques municipales.

Fonds bibliothèques universitaires

Il convient de distinguer les commandes d'ouvrages en langue française et les commandes d'ouvrages étrangers.

Pour ce qui concerne les ouvrages français, ELECTRE a le meilleur taux de couverture; OCLC (deuxième test) le moins bon.

BN-OPALE et SIBIL ont un taux de recouvrement proche de 75 % (76,29 % pour BN-OPALE et 72,59 % pour SIBIL). La base du Réseau coopératif est, elle, nettement moins adaptée.

Seules trois bases couvrent les ouvrages étrangers : BN-OPALE, SIBIL et OCLC. OCLC domine manifestement pour toutes les langues testées. SIBIL suit avec un taux moyen de 30,39 %.

Le taux de recouvrement de BN-OPALE est, lui, de 10,78 %.

La BN explique ces résultats par :

- les délais de catalogage en particulier sur le. troisième test où 27 notices portaient sur des ouvrages à paraître,

- la politique d'acquisition et la complémentarité avec les BU pour la couverture documentaire nationale.

Le test pose donc, pour les BU, le problème de l'approvisionnement en notices d'ouvrages étrangers à partir d'une base bibliographique française.

Analyse qualitative du test

Conditions du test

Echantillonnage

Le test qualitatif a porté sur les 32 notices communes aux 5 bases du deuxième jeu de test. La présence dans la base a donc été le seul critère de choix pour le test qualitatif.

Il a été demandé de sortir les notices selon le format interne de la base (un exemple de notice pour chacune des cinq bases est présenté en annexe).

Groupe de test

Compte tenu des problèmes administratifs, des délais et de la difficulté d'organisation de ce type de réunion, le groupe de test a réuni :

Mme Nicole Simon, directrice du Département des Entrées étrangères à la BN, Mme Colette Marion, chef de service de la Bibliographie de la France à la BN, M. Claude Jolly, directeur de la Bibliothèque de la Sorbonne, Mlle Michèle Lenart, consultant du Bureau van Dijk.

L'analyse du test a ensuite été envoyée aux représentants des 5 bases pour information.

Mode d'analyse

Trois types d'information ont été recherchés :

- présence/absence des données utiles,

- respect des règles de catalogage selon les normes appliquées en France,

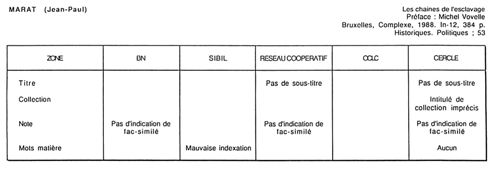

- et quand cela était possible, qualité de l'information (précision des notes par exemple). Le contenu des données d'indexation matière n'a bien sûr pu être réellement apprécié faute d'une grille d'évaluation intégrant les règles d'indexation et les besoins en indexation matière des clients potentiels. Seuls ont donc été relevés les cas où l'indexation était trop générale pour être réellement intéressante ainsi qu'un contresens (Base SIBIL pour l'ouvrage de Marat) .

Résultats de l'analyse

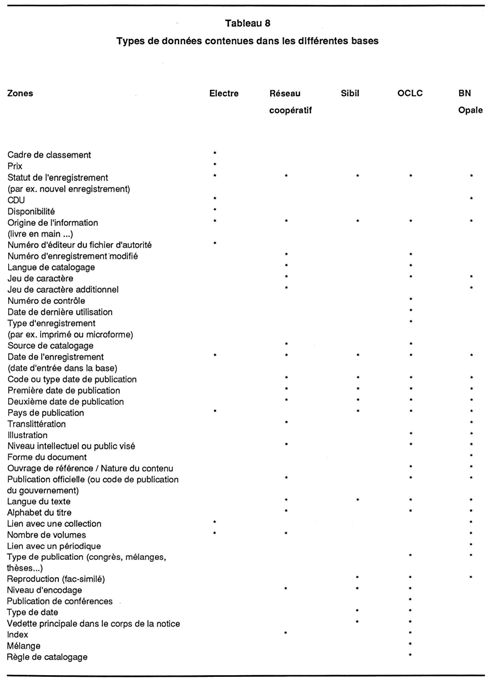

Zones fixes

Le tableau qui suit présente les différents types de données contenues dans les zones fixes de chacune des bases.

Des regroupements entre zones ayant, dans les bases analysées, des intitulés différents mais des contenus semblables ont été faits (exemple : le champ OCLC « Date 1 - Date 2 » et les deux champs « Première date de publication » et « Deuxième date de publication » pour les autres bases).

Une étude plus approfondie devrait permettre d'affiner ces regroupements (par exemple sur les notions de « Ouvrage de référence », « Type de publication », « Nature de contenu », « Mélange » ,...).

Il faut par ailleurs noter que les zones fixes ne sont pas toutes obligatoires et ne sont pas systématiquement renseignées. Par ailleurs, la répartition des informations entre les zones fixes et les autres zones n'est pas la même d'une base à l'autre : les indications d'indice CDU et de type d'enregistrement sont, par exemple, ailleurs que dans les zones fixes pour SIBIL.

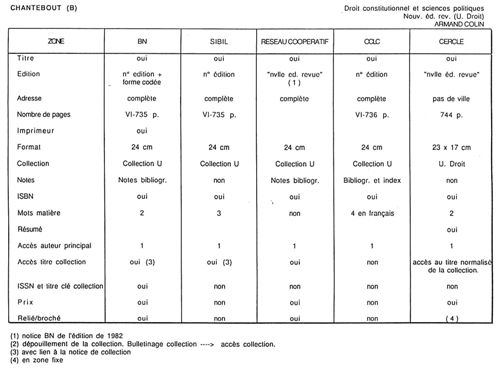

Autres zones

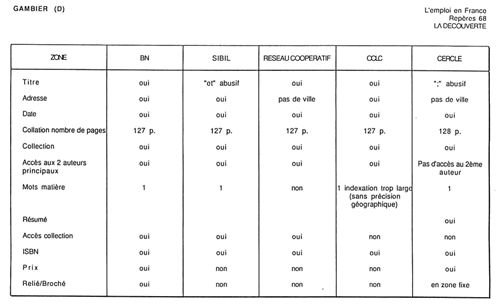

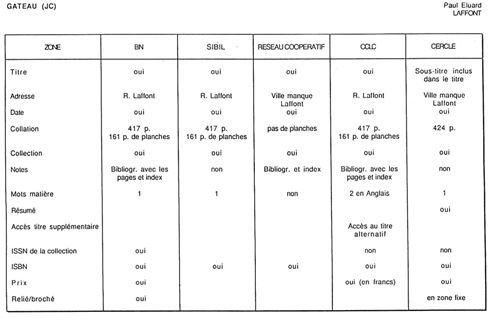

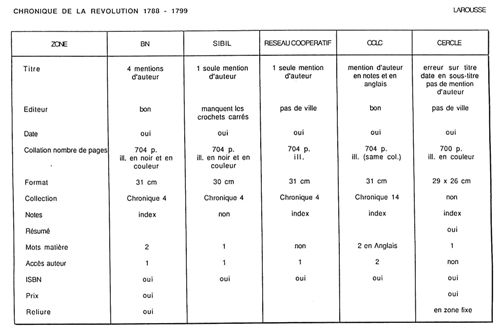

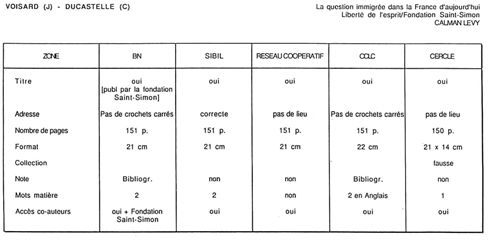

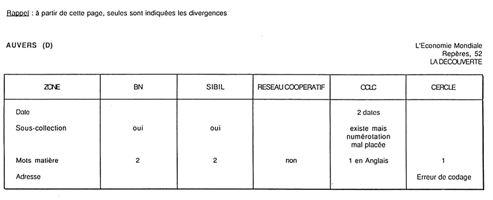

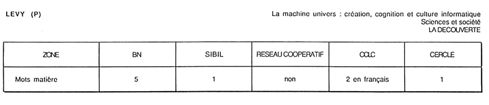

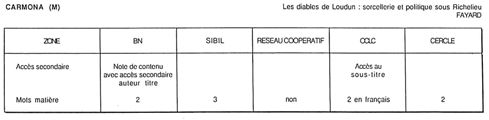

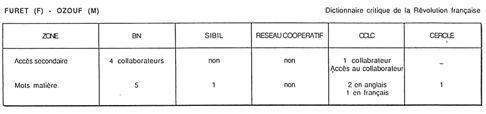

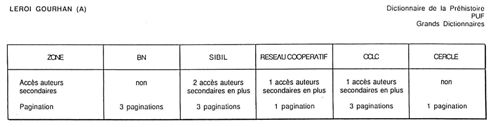

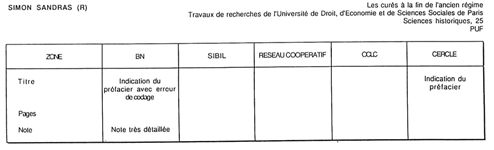

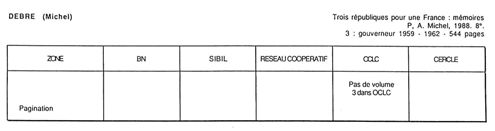

Les tableaux qui suivent présentent la comparaison notice par notice des 5 bases. Rappelons que les tests ont été faits sur des listes d'ouvrages en commande. Les premières notices ont été analysées de manière exhaustive et les tableaux comparatifs présentent toutes les zones et leur contenu pour chacune des 5 bases. Pour les notices suivantes, seules ont été retenues, afin de ne pas alourdir inutilement le compte rendu, les zones présentant des divergences. De même, les éléments répétitifs comme indication de l'imprimeur, du prix, de la reliure dans certaines bases ne sont plus repris.

Chaque tableau est précédé de la référence telle qu'elle était présentée dans la commande passée par la bibliothèque au libraire.

Commentaires

Quelques remarques générales se dégagent de cette analyse comparative :

- Mentions d'auteur : ELECTRE ne sort les auteurs secondaires que dans certains cas ;

- Adresse : le Réseau coopératif de la DLL, en général, et ELECTRE ne donnent pas le lieu d'édition et ce, en application de la norme Z 44-073 (description bibliographique moyenne des monographies) que ces deux bases ont adoptée. BN-OPALE indique le nom de l'imprimeur.

- Collation : ELECTRE donne un format en hauteur et en largeur. Le nombre de pages indiqué par ELECTRE diverge dans la majorité des cas de celle de BN-OPALE, OCLC et SIBIL. Il est en général supérieur (sans doute, va-t-il jusqu'à l'achevé d'imprimer).

- Notes : ELECTRE et SIBIL donnent rarement les indications de bibliographie et d'index. - Prix : donné par BN-OPALE, ELECTRE et OCLC.

- Résumé : fourni uniquement par ELECTRE

- Indexation :

Indexation Dewey pour le Réseau coopératif de la DLL.

Mots matières souvent en anglais pour OCLC. 1 mot matière en général pour ELECTRE (sauf dans deux cas).

Mots matières RAMEAU dans BN-OPALE, SIBIL, et en partie OCLC.

- ISSN et titre-clé des collections : fourni uniquement par la BN.

En conclusion, ce test qualitatif confirme les images qu'on a habituellement des différentes bases bibliographiques :

- un catalogage dit « scientifique » pour les bases à vocation internationale et/ou universitaire comme BN-OPALE, SIBIL et OCLC avec un strict respect (sauf erreurs des catalogueurs) des normes internationales de catalogage ;

- une description bibliographique plus légère pour ELECTRE avec des erreurs que l'on peut attribuer au fait que le catalogage est réalisé en pré-publication. ELECTRE est, par contre, la seule base à fournir un résumé, ce qui peut constituer un « plus » pour certaines bibliothèques ;

- On observe que le catalogage du Réseau coopératif reproduit fréquemment des erreurs de catalogage (nombre de pages erroné,... d'ELECTRE/Livres Hebdo. Les indications de prix, d'index et de type de documents n'y figurent pas systématiquement. C'est la seule base qui fournisse un indice Dewey correspondant à une classification très utilisée dans les bibliothèques de lecture publique. Cependant cette indexation n'est pas contrôlée.

- une indexation matière OCLC, qui paraît déconcertante (tantôt en français, tantôt en anglais, tantôt bilingue) et qui devrait rendre plus complexe la récupération de l'indexation matière pour les bibliothèques qui en font l'acquisition. En fait, l'autorisation de faire apparaître les mots matières RAMEAU en français a été obtenue par les bibliothèques françaises en septembre 1989. Depuis cette date, ces bibliothèques indexent en français et les mots matières viennent s'ajouter, le cas échéant, à une indexation déjà faite en anglais.

Conclusions

Les résultats du test ne constitueront pas une surprise pour les bibliothécaires. Ils mettent en évidence les points forts et les points faibles de chaque base :

- BN-OPALE

Elle constitue une référence en matière de qualité du catalogage. Elle présente, pour ce qui est du recouvrement, des faiblesses, notamment pour le livre pour enfant et pour les livres étrangers.

- ELECTRE

Elle offre le meilleur taux global de recouvrement pour les ouvrages en langue française. Elle ne couvre absolument pas la littérature étrangère. La qualité du catalogage est moyenne.

- OCLC

C'est la meilleure base pour les ouvrages étrangers et la plus faible pour les ouvrages en langue française, mais la participation d'OCLC à un seul test rend hasardeuse la comparaison avec les autres bases.

- LE RÉSEAU COOPÉRATIF

C'est la meilleure base pour les fonds Jeunesse. La qualité du catalogage est moyenne.

- SIBIL

C'est la meilleure base française pour les ouvrages étrangers. Il semble que sa valeur soit inégale selon les thèmes, mais il faudrait un test plus approfondi pour la quantifier d'une manière fiable.

Juillet 1989