LibQUAL+

Petit état des lieux, grandes perspectives

Cet article présente les principes d’organisation de LibQUAL+ et l’environnement qui accompagne les enquêtes. Il fait le point sur les établissements ayant déjà procédé à des enquêtes LibQUAL+ et rappelle les inconvénients de ces enquêtes (longueur de la passation du questionnaire, difficultés à obtenir un nombre significatif de réponses) et leurs atouts (outil de benchmarking, aide au pilotage).

The article focuses on the way LibQUAL+ is organised and the background to the surveys. It looks at those libraries that have already carried out LibQUAL+ surveys, detailing the system’s pros (the way it acts as a benchmarking and steering tool) and cons (the long-drawn-out process and the difficulty in obtaining sufficient responses).

Dieser Artikel stellt die Organisationsgrundsätze von LibQUAL+ und das Umfeld, das diese Umfragen begleitet, dar. Er zieht Bilanz über die Einrichtungen, die bereits LibQUAL+ -Umfragen durchgeführt haben und erinnert an die Nachteile dieser Umfragen (Länge der Verteilung des Fragebogens, Schwierigkeiten, eine bedeutende Anzahl von Antworten zu erhalten) und ihre Vorteile (Benchmarkinginstrument, Steuerungshilfsmittel).

Este artículo presenta los principios de organización de LibQUAL+ y el entorno que acompaña a las encuestas. Hace el balance sobre los establecimientos habiendo ya procedido a encuestas LibQUAL+ y recuerda los inconvenientes de estas encuestas (duración de la entrega del cuestionario, dificultades de obtener un número significativo de respuestas) y sus bazas (herramienta de benchmarking, ayuda al pilotaje).

LibQUAL+, dispositif d’enquête en ligne déployé depuis 2000 par l’Association of Research Libraries (ARL) aux États-Unis, s’est progressivement étendu aux bibliothèques universitaires du monde entier. L’enquête est aujourd’hui administrée par plus de 2 000 bibliothèques dans une vingtaine de pays et traduite dans dix-sept langues.

Introduit en France en 2004, LibQUAL+ est venu progressivement combler « l’absence anormale d’enquêtes nationales de satisfaction » en bibliothèque universitaire pointée en 2005 par le rapport annuel de la Cour des comptes 1. Née de la transposition de l’outil SERVQUAL utilisé dans le secteur commercial, l’originalité principale du dispositif réside dans une interrogation sur trois niveaux : l’usager doit noter pour chaque question la perception qu’il a de la qualité du service, mais aussi ses attentes par rapport à ce service, comprises entre un minimum acceptable et un idéal . Les résultats permettent ainsi de mesurer l’écart entre les attentes du public et sa perception des services et de hiérarchiser les demandes. Ils constituent, pour les responsables de bibliothèque qui aspirent à se rapprocher du niveau idéal souhaité par les usagers, un véritable outil d’aide à la décision et à l’action.

L’adoption de LibQUAL+ en France a d’abord été freinée par des inquiétudes liées à son origine nord-américaine et des réticences à l’égard de sa nature d’enquête marketing. La réelle lourdeur du questionnaire et sa longueur ont été également incriminées. Après cinq ans d’utilisation effective de l’enquête, quel état des lieux peut-on dresser de sa diffusion et de son acceptation ? Ses qualités avérées parviennent-elles à pallier ses inconvénients plus ou moins imaginaires ? Quels sont les enjeux et les limites de son utilisation généralisée ?

La « communauté » LibQUAL

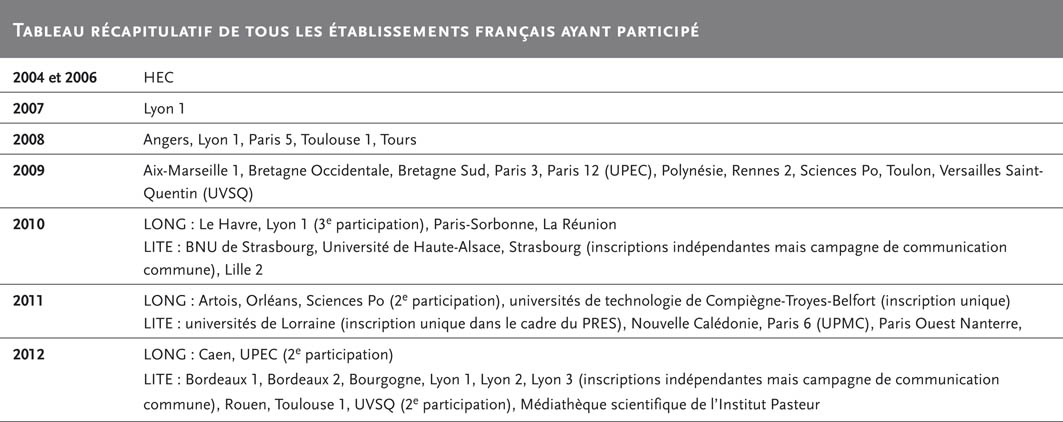

Les données dont nous disposons actuellement pour mesurer la diffusion de l’enquête dans les établissements d’enseignement supérieur français sont disponibles sur le site même de libqual.org, dans la partie d’administration (management center) du site, où sont entreposées les données (repository 3). Tous les établissements ayant administré l’enquête y ont accès et y sont répertoriés, année par année, depuis 2000. On décompte aujourd’hui 37 établissements français différents dans le management center (voir le tableau ci-dessous).

Tous les types de bibliothèques universitaires selon la terminologie ministérielle sont représentés : des grandes pluridisciplinaires (Angers, Rouen), des petites et moyennes pluridisciplinaires (Bretagne Sud, La Réunion), des universités à dominante Sciences, Techniques, Santé (Bordeaux 1), à dominante Lettres et sciences humaines (Lyon 2) et à dominante Droit, Sciences éco (Toulouse 1). On trouve également de grands établissements comme Sciences Po ou l’Institut Pasteur. Quelques bibliothèques ont fait le choix stratégique et/ou politique de mener l’enquête à plusieurs (universités alsaciennes, PRES lorrain, universités technologiques de Belfort, Troyes et Compiègne, les trois universités lyonnaises). Au total, entre le tiers et la moitié des universités françaises 4 ont déjà utilisé LibQUAL+, soit, si l’on compare avec les projets d’une telle envergure, une belle réussite, surtout en l’absence d’obligation officielle 5.

C’est la bibliothèque d’HEC qui, en France, s’est inscrite la première dans la démarche, en 2004 dans le cadre d’un consortium : « European business schools librarians group 6 ». La logique marketing, certainement plus facilement acceptable pour des écoles de commerce, a sans doute facilité cette adoption pionnière, de même que l’inscription dans un consortium. Dès 2007, sous l’impulsion décisive de Liber et du bureau de l’ADBU, Lyon 1 a travaillé à l’adaptation du questionnaire au contexte francophone européen 7. Des établissements dynamiques et souvent à l’avant-garde des innovations en bibliothèque (Angers, Paris 5) se sont lancés à leur tour et le besoin est né de créer des outils communs afin de mener au mieux cette expérience et de la partager.

C’est ainsi que le groupe LibQUAL-fr a été constitué, interlocuteur privilégié de l’ARL, matérialisé par un wiki 8 et une liste de diffusion 9, administrés alors par Nicolas Alarcon. Ces deux outils se sont avérés très utiles dans les premières années de déploiement de l’enquête en France afin de créer une sorte de communauté des usagers de LibQUAL+ 10. Le wiki servait de boîte à outils pour le chef de projet et la liste permettait des échanges simples et rapides sur les questions pratiques que se posent tous les collègues confrontés pour la première fois à la mise en œuvre de l’enquête. Ils répondaient à un besoin d’échanges et donnaient lieu à une émulation collective et à une réelle collaboration. Parfois celle-ci pouvait céder le pas à l’empathie… car l’enquête peut se révéler une épreuve, tant il est difficile d’atteindre le seuil minimal de questionnaires exploitables.

Inconvénients mineurs…

LibQUAL+ n’est en effet pas une enquête facile à « vendre », ni intuitive ni simple à appréhender notamment pour un étudiant de licence ou un étudiant étranger. La complexité du système de notation, les maladresses de traduction peuvent désarçonner le public comme le personnel et freiner leur adhésion ou leur participation. Pourtant, il est indispensable de recueillir le plus de questionnaires possibles pour permettre une exploitation riche des résultats et une analyse à différents niveaux de granularité 11 (les étudiants de master de droit, les étudiants de telle bibliothèque, les enseignants de maths, etc.).

Le premier inconvénient de LibQUAL+ pointé par tous les participants dès l’origine était la longueur de passation : de 15 à 20 minutes en moyenne pour répondre à toutes les questions. L’ARL a développé à partir de 2009 un processus Lite afin de pallier cette difficulté. LibQUAL+ Lite, introduit en France en 2010, a connu un développement rapide et tend désormais à se substituer à la version longue. Le temps de passation est en effet divisé par deux ou trois et les questionnaires validés sont mécaniquement beaucoup plus nombreux. Ainsi, les établissements arrivent plus facilement au seuil indispensable à atteindre pour que les résultats soient interprétables.

Autre limite, le questionnaire standardisé et fixe, sur lequel l’établissement ne peut agir qu’à la marge, constitue un défaut supplémentaire pour de nombreux établissements qui souhaiteraient adapter le questionnaire à leurs problématiques locales. Or, ce défaut s’avère être également l’atout principal de LibQUAL+ : fournir des données comparables dans le temps pour un même établissement, et avec d’autres établissements similaires. Par ailleurs, depuis 2007, l’ARL a tout de même accepté un certain nombre de propositions d’amélioration dans l’adaptation du questionnaire au contexte français (et francophone) que ce soit dans la nomenclature des disciplines ou dans la traduction des questions. Aujourd’hui, la version francophone est stabilisée même si la formulation de certaines questions n’est toujours pas idéale 12. Une nouvelle traduction souhaitée par le groupe LibQUAL-fr et financée par l’ADBU vient d’être réalisée par un professionnel. Si l’ARL l’accepte, elle devrait être utilisée dès 2013.

Cinq questions optionnelles – choisies dans une liste fermée –peuvent également être ajoutées afin d’aborder des points qui ne figurent pas dans le questionnaire de base (par exemple les horaires d’ouverture). L’ordre des questions est immuable, ainsi que la liste des disciplines LibQUAL+ auxquelles se rattacher. En revanche, la bibliothèque a la possibilité de « customiser » les disciplines au moment du paramétrage de l’enquête afin que chaque usager puisse se reconnaître dans les intitulés proposés. Bref, un soupçon d’adaptabilité et de personnalisation pour compenser une forte dose de rigidité et de stabilité.

Dernier inconvénient, l’enquête est payante et son coût (3 200 dollars pour une participation annuelle) est souvent invoqué comme frein à son utilisation. Mais si plusieurs bibliothèques souhaitent s’inscrire ensemble, un seul notebook sera réalisé, et le coût sera donc partagé 13. Cependant, ce coût est finalement modeste au regard des services rendus et en comparaison par exemple d’une étude confiée à une agence privée, ou d’une enquête sociologique. Car choisir LibQUAL+ c’est choisir un protocole fiable, ayant fait ses preuves, et soutenu matériellement par une organisation professionnelle forte. Les aspects logistiques et techniques sont grandement facilités par la gestion centralisée : l’infrastructure et les outils développés par l’ARL sont à disposition tant pendant la passation de l’enquête que par la suite. Les données brutes et le rapport réalisé par l’ARL sont disponibles à tout moment sur le site libqual.org. L’accès au management center est sécurisé par identifiant et mot de passe personnels qui garantissent la confidentialité, et l’utilisation des données – les siennes et celles des autres établissements –seulement à des fins de comparaison vertueuse 14. Le véritable investissement est donc essentiellement humain et en temps de travail. De cet investissement dépend en grande partie la réussite de l’enquête.

… et forces majeures : pilotage et benchmarking

Un outil de communication et de pilotage

Si la préparation est réalisée efficacement en amont, si tous les acteurs de l’université sont sensibilisés et informés, si le personnel est correctement impliqué et si le soutien de la tutelle est réel, nul doute que l’enquête soit un succès et qu’elle révèle tout son potentiel d’outil de communication et surtout de pilotage. En effet, une enquête « classique » de satisfaction pose un constat mais ne mesure pas les écarts et les marges de progression. L’enjeu de l’utilisation de LibQUAL+ dans sa bibliothèque n’est pas de découvrir ce qui va et ce qui ne va pas car les résultats sont rarement des surprises mais viennent surtout confirmer des intuitions et donner des chiffres et des représentations graphiques pour élaborer une stratégie d’actions.

C’est pourquoi les établissements peuvent utiliser les résultats de l’enquête LibQUAL+ pour la construction des objectifs du contrat quinquennal de développement, notamment pour les actions correctrices lourdes nécessitant un budget important. Processus par essence itératif, une enquête LibQUAL+ appelle la suivante pour mesurer d’une campagne à l’autre les effets des actions mises en place et les progrès réalisés. À chaque bibliothèque son rythme : tous les deux, trois ou quatre ans, en fonction des réalisations concrètes à évaluer (rien ne sert de recommencer l’enquête si l’on n’a pas eu les moyens de mettre en place ce que l’on a projeté), en fonction des forces vives disponibles, en fonction des projets et du contexte local. Or, « trop souvent, une fois la fameuse enquête annuelle réalisée, il reste bien peu d’énergie pour en tirer tout l’arsenal qu’elle contient, et l’exploiter, stratégiquement, au mieux. Trouver malgré tout la disponibilité nécessaire, c’est, me semble-t-il, perdre du temps pour en gagner, et piloter vraiment 15. » Dans cette phase essentielle d’analyse des résultats et de projection des actions correctrices, l’établissement se replie généralement sur sa problématique locale pour interpréter au mieux les données brutes qui lui sont livrées et surtout répondre aux attentes des usagers de la façon la plus adéquate possible 16. Or les bibliothèques auraient tout à gagner à travailler ensemble entre établissements similaires sur la recherche et le partage de solutions d’amélioration.

Le contenu des journées initiées par le groupe LibQUAL-France pour aider à la mise en œuvre de l’enquête, puis à son dépouillement, est significatif de l’évolution de l’appropriation de l’enquête. La première en 2009 17 et la deuxième en 2010 18 étaient essentiellement consacrées à des retours d’expérience sur la mise en œuvre de l’enquête dans différents établissements, dans différentes conditions. Ces journées permettaient des échanges fructueux entre collègues ayant déjà administré l’enquête et collègues se préparant à l’administrer. En revanche, les 25 et 26 juin derniers 19, même si des retours d’expérience étaient à nouveau présentés, les thématiques de l’analyse et de l’exploitation des résultats étaient également à l’honneur et, surtout, le nombre croissant de participants a pour la première fois permis de financer le déplacement et l’intervention de Selena Killick, représentante de l’ARL en Europe. Cette formation doit permettre aux établissements français d’entrer dans la troisième phase de LibQUAL+, le benchmarking 20.

Une dimension inexploitée

Se comparer fait peur et paraît risqué, pourtant le benchmarking tel que l’envisage l’ARL, comme identification et diffusion des bonnes pratiques pour l’amélioration des bibliothèques 21, ne devrait pas être sujet à caution mais bien plutôt recueillir un large consensus. Il revêt deux formes : la comparaison dans le temps à soi-même et la comparaison aux autres. L’analyse diachronique n’en est en France qu’à ses balbutiements : seuls quelques établissements disposent aujourd’hui de données fiables susceptibles d’être comparées sur deux campagnes. Lyon 1 a réalisé quatre enquêtes mais la première enquête a été faite dans des conditions particulières (pilote) et les chiffres de 2010 sont difficilement exploitables (trop peu de réponses). En revanche, les résultats de 2008 et de 2012 pourraient donner lieu à d’intéressantes comparaisons 22. Angers et Versailles Saint-Quentin-en-Yvelines ont à leur disposition les résultats d’une enquête Long et d’une Lite ; Sciences Po et Paris 12 (UPEC), deux enquêtes longues. Dans chaque cas, une rénovation ou une construction de bâtiment a eu lieu entre les deux enquêtes. Il serait enrichissant pour tous de mesurer quels effets ont été produits sur la perception de la qualité par les usagers. Anita Beldiman-Moore, à Sciences Po, a fait cette comparaison entre les deux enquêtes de 2008 et 2011 et constate ainsi que l’écart de supériorité (la zone bleue sur les radars), équivalant en quelque sorte à la mesure de la satisfaction, a augmenté en moyenne de 24 % entre les deux campagnes 23.

L’autre facette du benchmarking est l’analyse externe et synchronique. Celle-ci a été mise en œuvre également par Sciences Po, mais aussi d’une façon un peu différente par les universités de technologie 24. Les notebooks du consortium LibQUAL-France des différentes éditions fournissent à cet égard une masse de données extrêmement riche mais malheureusement encore inexploitée. Pourtant, il pourrait en sortir une sorte de cadre de référence commun à l’aune duquel chaque bibliothèque pourrait se comparer dans l’objectif d’améliorer ses pratiques sur ses points faibles, ou de faire partager les siennes, sur ses points forts.

Le dispositif LibQUAL+ est aujourd’hui bien implanté dans les bibliothèques françaises de l’enseignement supérieur et de la recherche. LibQUAL+ reste une brique, et une brique seulement, de l’évaluation et n’a pas vocation à remplacer les autres outils disponibles mais bien à les compléter. En revanche, il serait dommage de se priver de cette brique qui apporte une vision panoramique des attentes des publics mesurées de façon fiable et reproductible, et qui fournit des données chiffrées stables et comparables. En effet, seule la comparaison sur plusieurs sessions de données équivalentes peut rendre la pleine mesure des avantages de LibQUAL+ et il reste donc du chemin à parcourir avant que ses profits ne soient épuisés… Espérons que la préconisation de la Cour des comptes de « fixer […] les exigences minimales qui devraient être attendues des bibliothèques universitaires en ce qui concerne leur capacité à satisfaire les besoins des usagers 25 » trouvera en partie une réponse dans l’exploitation systématique des données du consortium LibQUAL-France •

Décembre 2012