L’évaluation des services d’information des bibliothèques publiques

Une approche holistique

L’évaluation des bibliothèques est en général fondée sur une approche quantitative : nombre de documents, de prêts, de lecteurs actifs… Ces chiffres sont d’une utilité incontestable, mais s’y cantonner favorise une analyse réductrice et partielle des services d’une bibliothèque publique, en laissant en particulier dans l’ombre leur dimension sociale. Les auteurs, trois chercheurs écossais, estiment ainsi que la préoccupation première d’une bibliothèque publique ne devrait pas être de savoir quelles ressources ses usagers consultent ou empruntent, mais plutôt comment la consultation ou l’emprunt d’une ressource a contribué au développement personnel et social de l’usager. Pour y arriver, ils proposent une approche holistique de l’évaluation, combinant les méthodes quantitatives et qualitatives.

Library evaluations are generally based on a quantitative approach, looking at the number of items in the collection, loans, active readers, and so on. Such figures are certainly useful, but they provide a simplistic and slanted analysis of public library services, particularly overlooking their role as providers of services for the local community. The authors, based in Scotland, argue that the main priority for public libraries should not be to find out what resources the users consult or borrow, but rather how consulting and borrowing resources has contributed to their personal and social development. They thus propose a holistic approach to evaluation, drawing on both quantitative and qualitative methods.

Die Evaluierung der Bibliotheken basiert im allgemeinen auf einem quantitativen Ansatz: Anzahl der Medien, der Ausleihen, der aktiven Leser... Diese Zahlen sind von unbestreitbarem Nutzen, doch sich darauf zu beschränken, unterstützt eine vereinfachte und lückenhafte Analyse der Dienste einer öffentlichen Bibliothek, die besonders ihre soziale Dimension in den Schatten stellt. Die Autoren, drei schottische Forscher, sind somit der Ansicht, dass das erste Anliegen einer öffentlichen Bibliothek nicht sein sollte, herauszufinden, welche Ressourcen ihre Benutzer befragen oder entleihen, sondern vielmehr, wie die Suchanfrage oder Entleihung einer Ressource zur persönlichen und sozialen Entwicklung des Benutzers beigetragen hat. Um dies zu erreichen, schlagen sie einen ganzheitlichen Ansatz der Evaluierung vor, der die quantitativen und qualitativen Methoden verbindet.

La evaluación de las bibliotecas en general está fundada en un enfoque cuantitativo: número de documentos, de préstamo, de lectores activos... Estas cifras son de una utilidad incontestable, pero limitarse a ello favorece un análisis reductor y parcial de los servicios de una biblioteca pública, dejando en particular en la sombra su dimensión social. Los autores, tres investigadores escoceses, estiman de esta manera que la preocupación primera de una biblioteca pública no debería ser saber qué recursos sus usuarios consultan o se emprestan, sino más bien cómo la consulta o el empréstamo de un recurso ha contribuido al desarrollo personal y social del usuario. Para conseguir eso, ellos proponen un enfoque holístico de la evaluación, combinando los métodos cuantitativos y cualitativos.

Les services d’information proposés par les bibliothèques publiques combinent des éléments matériel et logiciel (« hard » et « soft system »), qui, pour être efficaces, doivent non seulement être techniquement fiables, mais aussi tenir compte de facteurs sociaux, économiques, juridiques, organisationnels et ergonomiques. De la sorte, l’évaluation de ces services ne peut que bénéficier d’une approche holistique, fondée sur des méthodes à la fois quantitatives et qualitatives. Cet article a pour but de décrire les méthodes actuelles d’évaluation des services d’information des bibliothèques publiques, dont les services en ligne qui sont en pleine émergence.

Les approches quantitatives

L’évaluation des bibliothèques publiques s’est fondée, de longue date, sur des méthodes quantitatives, axées sur la mesure de la production. En Écosse, les bibliothèques rendent compte de leur action au gouvernement avant tout par la transmission de données à Audit Scotland, un établissement statutaire veillant à « un usage approprié, efficace et utile des fonds publics » [3]. Les indicateurs de performance associés à cette démarche tiennent essentiellement compte des chiffres de production. Par exemple, les tableaux de classement de 2006-2007 des bibliothèques publiques se basent sur les statistiques suivantes :

- rotation des stocks : pourcentage de renouvellement des stocks de documents empruntables pour adultes par rapport à l’objectif national ;

- rotation des stocks : pourcentage de renouvellement des stocks de documents empruntables pour enfants et adolescents par rapport à l’objectif national ;

- fréquentation des bibliothèques : nombre d’entrées pour mille habitants ;

- fréquentation des bibliothèques : pourcentage de la population résidente ayant emprunté un document ;

- learning centres et learning access points : pourcentage de la population résidente les ayant fréquentés ;

- learning centres et learning access points : nombre d’utilisations des terminaux pour mille habitants [4].

De telles statistiques, quoique précieuses, ne traduisent pas forcément l’impact plus large d’une bibliothèque dans la communauté et l’économie locales [18]. Par exemple, les entrepreneurs locaux, les chercheurs d’emploi, les étudiants, les consommateurs et les touristes utilisent régulièrement les bibliothèques municipales pour obtenir des informations, que ce soit en consultant le dernier numéro d’un magazine ou en épluchant les journaux économiques. Or ces informations, dont on ne mesure pas l’impact, peuvent influencer les choix d’investissements des particuliers, des organisations et des communautés.

Tout employé d’une bibliothèque publique est extrêmement sensible aux statistiques liées à l’usage des livres. Celles-ci sont érigées en indicateurs-clés de performance, permettant de mesurer à quel point la bibliothèque remplit son mandat. Les statistiques totalisant le nombre de lecteurs inscrits sur un territoire donné, en particulier les usagers actifs, permettent sans doute de se faire une idée de la popularité des services proposés par la bibliothèque. Ces statistiques risquent cependant de ne donner qu’une image incomplète de la mission qu’essaie de remplir une bibliothèque. Ainsi que l’ont observé Toyne et Usherwood : « L’évaluation se limite encore au comptage du nombre d’exemplaires, il n’y a quasiment aucune tentative pour mesurer l’impact de ces exemplaires sur des particuliers ou des groupes au sein de la communauté. Autrement dit, le service a toujours tendance à ne mesurer que ce qui peut l’être et passe ainsi à côté de ce qui est vraiment important. » [24]

Il est tentant de réunir des données numériques relativement aisées à interpréter, qui semblent fournir une solution toute trouvée pour dominer les complexités d’un processus d’évaluation. Des statistiques comme le nombre d’exemplaires sont à la portée de tous : des décideurs politiques chargés de l’administration d’une bibliothèque aux cadres supérieurs en charge du contrôle de gestion, des bibliothécaires de la succursale au grand public. Cependant, une interprétation par trop simpliste de ces statistiques ne rend pas compte du service dans son intégralité. Ces chiffres deviennent même dangereux lorsqu’ils sont repris par les médias pour étayer des messages pessimistes.

Par exemple, cette communication de la BBC montre à quel point des données statistiques prises hors de tout contexte peuvent être manipulées de façon négative :

« “Love it or lose it”. Les militants tirent la sonnette d’alarme : les bibliothèques publiques sont menacées d’extinction. Comment les sauver ?Soyez honnêtes : à quand remonte votre dernière visite à la bibliothèque du coin ? Savez-vous seulement où elle est ? Il est possible que vous ne l’appreniez que trop tard et qu’elle soit déjà fermée.

La plupart d’entre nous savent probablement déjà que la fréquentation des bibliothèques est en baisse constante depuis des années. Mais combien se rendent compte que ce service public, pourtant estimé, est arrivé à une étape capitale de son histoire ? Et combien s’en soucient ?

Plus de 100 bibliothèques à travers le Royaume-Uni sont menacées de fermeture, les municipalités cherchant à réduire leurs dépenses pour alléger les déficits budgétaires.

“Les bibliothèques publiques sont en voie d’extinction et des mesures doivent être prises pour stopper leur déclin” prévient le site militant Libri.org. » [12]

Ainsi, malgré leur valeur intrinsèque, les approches quantitatives ne présentent qu’une perspective limitée et étroite des services des bibliothèques publiques lorsqu’elles sont le seul mode d’évaluation utilisé.

Les approches complémentaires

L’évaluation contingente

Le concept d’évaluation contingente a émergé récemment. Cette approche méthodologique visant à évaluer l’impact potentiel des bibliothèques est empruntée au domaine de l’économie de l’environnement. Elle a d’abord été utilisée comme moyen de mesurer la valeur du non-usage dans des projets environnementaux, c’est-à-dire d’étudier la valeur marchande de quelque chose en prenant en compte non seulement son usage, mais aussi son non-usage.

On peut ainsi extrapoler sur ce non-usage en avançant par exemple que la valeur économique d’un terrain dépasse de loin ses coûts d’entretien. On voit tout de suite pourquoi cette méthodologie a intéressé le secteur culturel, étant donné que les bibliothèques et les musées sont par essence des bâtiments publics ouverts à tout le monde, sans que tout le monde les fréquente. La méthodologie de l’évaluation contingente consiste à demander aux non-usagers de ces services d’en estimer la valeur. Ainsi, si le taux d’inscription national aux bibliothèques s’élève à 30 %, mais que 60 % des habitants se déclarent prêts à payer 10 euros par mois pour posséder une carte de bibliothèque alors qu’il suffit de 5 euros par personne pour assurer ce service, on peut soutenir que pour chaque euro investi, la bibliothèque en vaut 2.

Des études sur des bibliothèques s’appuyant sur l’évaluation contingente ont eu lieu ces dernières années aux États-Unis, en Norvège et au Royaume-Uni [1, 5, 7, 14, 16]. Certains chercheurs ont toutefois questionné l’efficacité de l’évaluation contingente, en soulignant que le grand public n’a aucune base sur laquelle s’appuyer pour décider de la valeur de l’entité soumise à enquête [27].

Les audits sociaux

Ainsi que nous l’avons précédemment évoqué, il est de la plus haute importance pour une bibliothèque publique à la fois de mesurer et de faire connaître son impact, aussi bien à une échelle locale que plus étendue. Il est irréaliste de tenter d’y parvenir en se fondant uniquement sur des mesures quantitatives. Une bibliothèque publique n’est pas une librairie, où l’accent est avant tout mis sur la gestion des stocks et le profit. Pour une bibliothèque publique, le souci immédiat n’est pas de savoir ce que les usagers consultent ou empruntent, mais comment ce qui a été emprunté ou consulté participe au développement personnel et social de l’usager. La réponse à cette question, qui dépasse de loin les problématiques d’emprunts de livres, est plutôt à chercher du côté des conditions d’accès du public à l’information, de l’offre d’information, de formation et de soutien dans les domaines de l’informatique et de la recherche documentaire.

Il existe une façon de juger pleinement de l’impact de l’usage d’un service sur une communauté, grâce au recours à l’audit social. Le Social Process Audit (« audit de processus social ») est un concept introduit en 1976 [6], avant d’être repris et développé à la fin des années 1990, pour aboutir au SIA (Social Impact Audit) de Linley et Usherwood [18]. Il a été utilisé pour mesurer l’impact social des services de bibliothèques de Newcastle et Somerset [18, p. 6], puis de nouveau employé au Royaume-Uni en 2002 [8]. Cette étude avait été commanditée par le Southwest Museums & Libraries Archives Council pour évaluer l’impact social des musées, bibliothèques et services d’archives dont il avait la tutelle [8, p. 2].

Le SIA vise à promouvoir la communication entre une bibliothèque publique et toutes ses parties prenantes. Ce type de consultation jauge les résultats d’un service de bibliothèque au moyen de questionnaires, de groupes thématiques et d’entretiens individuels. Il évalue le degré de réussite d’un service à remplir ses objectifs organisationnels, identifie les points à améliorer, encourage les suggestions des parties prenantes, détermine à quel point le service rendu répond aux besoins et aux attentes de tous ses usagers. Le SIA peut « [...] aider les responsables de bibliothèques à guider et contrôler les performances de ses services, améliorer la communication à destination des décideurs politiques en mettant en valeur l’utilité de ces services, permettre aux parties prenantes d’émettre un jugement éclairé sur ces services, et modifier le comportement organisationnel de la structure. En résumé, il peut aider à améliorer la performance sociale d’une bibliothèque publique » [18, p. 86].

« Il représente une opportunité pour les responsables de bibliothèques publiques de mesurer la valeur sociale de leur établissement et de fournir des munitions pour répondre aux opinions controversées qui voient dans les bibliothèques de simples points de gestion de stocks de livres offrant au grand public un accès gratuit à des romans » (The Adam Smith Institute, 1986, in [18], p. 25).

Le SIA a permis de montrer à quel point les bibliothèques publiques remplissent leurs missions traditionnelles, mais aussi de souligner nombre de fonctions complémentaires qui contribuent également à leur impact sur la société. Les résultats soumis aux parties prenantes étaient divisés en cinq grands thèmes reprenant les catégories développées par Comedia en 1997 pour évaluer l’impact social des arts :

1.Développement personnel

2.Cohésion sociale

3.Autonomisation des communautés et autodétermination

4.Image et identité locale

5. Santé et bien-être

(Matarasso, 1997, in [18]).

Les résultats des études menées par le SIA suggèrent que, bien que des bénéfices intangibles comme ceux énumérés précédemment soient plus difficiles à mesurer, ils participent néanmoins du processus de valorisation de l’impact social du service des bibliothèques, en érigeant le capital social et humain au rang de bien précieux [19, p. 1271]. En particulier, les déclarations des usagers consultés sur l’impact positif que le service de bibliothèque a eu sur leur vie et sur la communauté dans son ensemble « mettent de la chair sur le squelette des données statistiques » [18].

Les kits d’auto-évaluation

Les bibliothèques publiques reconnaissent leur besoin d’adopter une approche plus holistique de l’évaluation quantifiée de leurs services et d’en améliorer leur connaissance au-delà des données statistiques réclamées par leur tutelle. En conséquence, de nombreuses bibliothèques ont adopté des outils d’évaluation flexibles, adaptés à leurs services, qui leur permettent de produire des résultats mettant en valeur leurs apports et qui identifient les points d’amélioration. L’auto-évaluation constitue en ce sens une solution intéressante favorisant à la fois une évaluation régulière et la référentiation (le « benchmarking »). Plusieurs options d’auto-évaluation existent, tel le European Foundation for Quality Management (EFQM). Au Royaume-Uni, a été développé un kit [16] permettant aux responsables de bibliothèques publiques de fournir, avec la participation de trois autorités locales, des données valorisant leurs services.

Les auteurs de ce kit se sont fondés sur le Business Excellence Model (BEM), le Quality Framework, et la Democratic Approach de Pfeffer et Coote pour le développer. Les échanges avec des représentants des autorités concernées ont permis aux auteurs de distinguer les cinq valeurs de base qui devaient être prises en compte, ainsi que les éléments qui créaient des obstacles à l’adoption et au déroulement de cette technique d’auto-évaluation :

- une attention portée avant tout à l’usager, un service équitable, un système accessible, une participation du public ;

- un leadership clairement identifié et visionnaire, une politique favorisant le développement des compétences, l’investissement et la satisfaction des employés ;

- une stabilité des objectifs, une continuité des progrès, un management par les faits ;

- une attention particulière aux usagers, l’affirmation de la responsabilité publique, le développement de partenariats ;

- une gestion des processus.

Les auteurs réalisèrent qu’une terminologie compliquée et le suremploi d’un langage jargonnant n’étaient ni attractifs ni appropriés pour évaluer l’impact des bibliothèques publiques [16, p. 132].

Après synthèse de l’ensemble des données glanées durant la période de consultation et des discussions supplémentaires avec des organisations appropriées, comme l’Association of Chief Librarians, la première Public Library Improvement Matrix (PLIM) vit le jour. PLIM est un kit à destination des responsables de bibliothèques qui consiste en un questionnaire d’auto-évaluation, une matrice de management et d’amélioration, et un document pro forma pouvant servir ¬d’appui aux démarches d’amélioration, de communication et de définition des objectifs futurs du service. Cependant, bien qu’il constitue une alternative bienvenue aux outils statiques d’évaluation quantitative, PLIM nécessite une adaptation et une mise à jour constante pour rester en phase avec les évolutions politiques et les demandes des usagers.

En 2007, l’administration écossaise a édité, en partenariat avec le Scottish Library and Information Council (SLIC), son propre kit d’auto-évaluation : le Public Library Quality Improvement Matrix (PLQIM). L’objectif premier de ce kit est de « fournir une méthode efficace pour définir des standards, développer des critères d’évaluation et un outil de planification afin de s’assurer que les services proposés satisfont aux demandes des usagers » (Ferguson, in [21]). Le cadre proposé est fortement influencé par le HM Inspectorate of Education (HMIE), utilisé pour juger les performances des écoles. Sept indicateurs de qualité (« Quality Indicators » ou QI) sont érigés en critères de comparaison pour les bibliothèques publiques en vue de mesurer leur capacité à remplir les objectifs suivants :

- accès à l’information ;

- participation de la communauté et de l’individu ;

- satisfaction aux besoins des lecteurs ;

- soutien aux apprenants ;

- respect de l’éthique et des valeurs ;

- organisation et exploitation des ressources et de l’espace ;

- leadership [21].

Chaque indicateur de qualité est construit sur une série de grands axes, avec une sélection de thématiques et d’exemples visant à guider les responsables d’une bibliothèque dans leur évaluation et à les aider à identifier les meilleures procédures. Les services doivent se noter eux-mêmes (sur une échelle de satisfaction allant de 1 à 6 ; 1 équivaut à “insatisfaisant” et 6 à “excellent”). Les responsables de services sont également encouragés à mener des consultations et des enquêtes auprès des usagers avant de tirer des conclusions définitives.

L’évaluation dans le domaine électronique : ne pas s’arrêter à l’interface publique

À l’ère d’une innovation technologique sans précédent, qui favorise une mutation constante des attentes et des stratégies de recherche des usagers [17, 20], notre société est désormais sans conteste une société en ligne, dont les services virtuels, de plus en plus banals, sont préférés à tout autre [23]. Les bibliothèques publiques, de par le crédit qui leur est accordé en tant que source d’informations, occupent une position privilégiée pour répondre à ces attentes, par le biais de la numérisation et des dispositifs en ligne associés, et plus largement par tous ces types de services aujourd’hui érigés en priorité stratégique. Dès lors, une question se pose : comment évaluer les services en ligne des bibliothèques publiques ? Toute tentative de réponse se heurte à deux écueils : d’abord, le nombre limité d’évaluations déjà existantes des services internet mises à disposition par des bibliothèques publiques et qui pourraient servir de modèle [2] ; ensuite, de façon plus générale, la complexité de l’évaluation des systèmes.

Sur ce dernier point, les approches classiques d’évaluation des systèmes se fondent sur « l’utilisabilité » (usability) et « l’utilité » (usefulness), en tant que propriétés relatives à l’interaction des systèmes [25]. Combinés, ces deux critères déterminent l’utilisation d’un service et le degré de satisfaction de ses usagers. En effet, si une évaluation sur le degré d’utilisabilité d’un système peut contribuer à améliorer son ergonomie, il faut souligner que, sans prise en compte de son utilité, ce système peut s’avérer être efficacement conçu mais sans aucune utilité fonctionnelle [13]. Malheureusement, ces deux notions sont souvent abordées de façon déconnectée [11], et, dans le cas des bibliothèques numériques, les évaluations se concentrent essentiellement sur la notion d’utilisabilité [28].

La difficulté principale reste d’identifier, à la fois respectivement et relativement, ce qu’il convient de mesurer et comment. Problème complexifié par les divergences sur ce que constituent des mesures de l’utilisabilité, et par les demandes qui en découlent de critères plus exhaustifs et plus satisfaisants d’évaluation de systèmes intégrés et globaux.

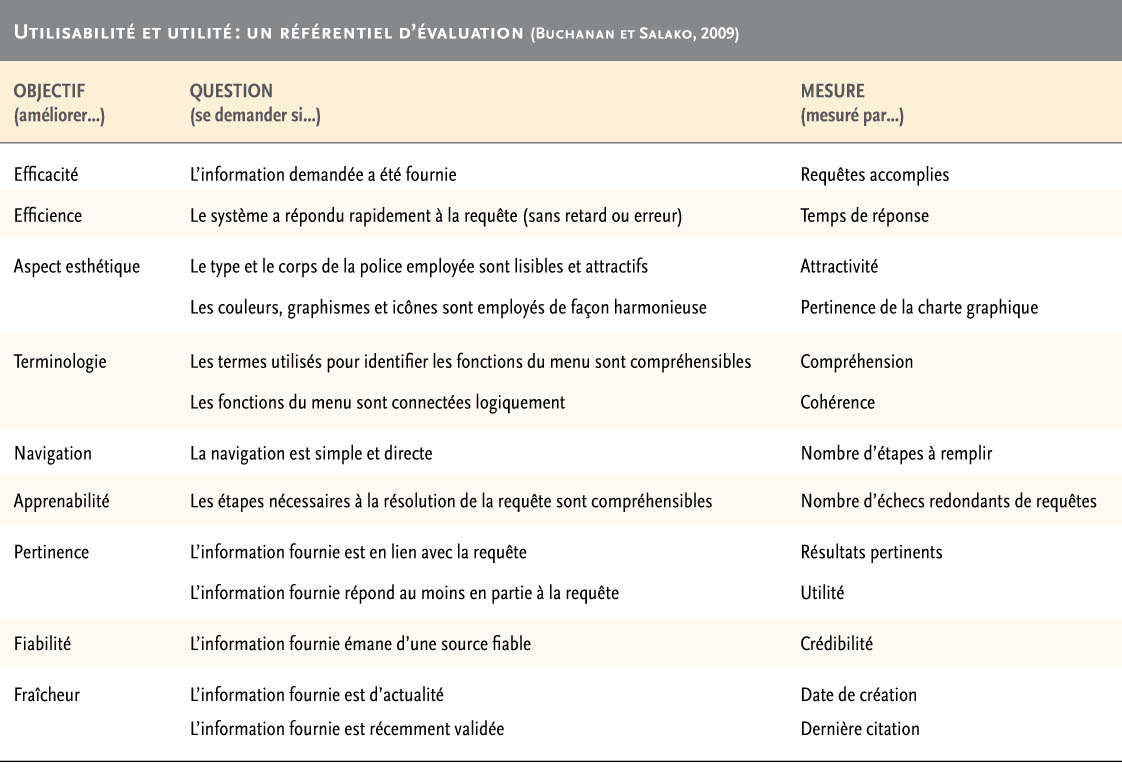

Buchanan et Salako, en 2009 [10], ont développé un schéma intégré de références, fondé sur la définition d’objectifs, des questionnaires et une approche statistique. L’utilisabilité d’un système est définie par son efficacité, son efficience, son aspect esthétique, la terminologie employée, ses conditions de navigation et d’apprentissage. L’utilité d’un système est, quant à elle, définie par la pertinence, la fiabilité et la fraîcheur de l’information procurée. Il est à noter que les valeurs associées à chacun de ces items sont à la fois quantitatives et qualitatives.

Ce référentiel a été testé avec succès pour la bibliothèque numérique du National Health Service, en combinant questionnaires et observations de terrain. Cependant, cette expérimentation a permis de constater que, si les évaluations du service obtenues via les questionnaires étaient globalement positives, les résultats obtenus par ¬l’observation directe l’étaient bien moins, les participants étant autrement plus critiques. Même en admettant que les résultats des questionnaires étaient en partie « gonflés », on constate que le but global du système n’apparaissait pas comme allant de soi aux participants de l’observation de terrain : les usagers s’interrogeaient sur sa finalité et son positionnement par rapport à d’autres services existants de bibliothèques virtuelles, et sur ses capacités d’adaptation à des conditions et des environnements variables.

L’étude concluait que l’utilisabilité et l’utilité pouvaient être aisément combinées en une approche pluri-méthodologique. Le référentiel d’évaluation proposé (cf. tableau) constituait un outil relativement compréhensible et fiable d’identification et de mesure des critères d’utilisabilité et d’utilité. Cette enquête mettait notamment en valeur l’importance des études de terrain pour évaluer l’utilité d’un tel service, en soulignant que les réflexions cognitives et contextuelles ne s’arrêtent pas à l’interface à destination de l’usager. Elle mettait également l’accent sur la nécessité de prendre en compte des scénarios fondés sur la diversité des usagers.

Toutes ces constatations amènent le chercheur à formuler une nouvelle question : comment évaluer les services numériques au-delà de l’interface proposée ? Une étude complémentaire de Buchanan et McMenemy, effectuée en 2009, s’intéresse plus particulièrement à cette question. La modélisation de processus est une méthode récemment appliquée lors d’un audit d’information d’une bibliothèque de droit [9]. Cette méthode est un moyen de mieux développer et évaluer des scénarios prospectifs par la modélisation des activités des usagers. Plusieurs profits sont à tirer d’une telle expérience : elle ouvre la perspective d’une pensée systémique, et facilite l’identification des conditions et contraintes environnementales qui peuvent influencer l’utilité d’un système. De plus, cette étude soulignait l’importance d’une approche globale de l’évaluation, thèse défendue tout au long de cet article.

Le rôle social des bibliothèques

Les évaluations en bibliothèque fondées sur des approches quantitatives sont d’une utilité incontestable, mais s’y cantonner favorise une analyse réductrice et partielle des services d’une bibliothèque publique, en laissant en particulier dans l’ombre leur dimension sociale. Sans conteste, la préoccupation première d’une bibliothèque publique ne devrait pas être de savoir quelles ressources ses usagers consultent ou empruntent, mais plutôt comment la consultation ou l’emprunt d’une ressource a contribué au développement personnel et social de l’usager. La capacité à mesurer un tel rôle sociétal, et à mettre en valeur une telle dimension de ses services, est tributaire d’une approche holistique de l’évaluation, combinant les méthodes quantitatives et qualitatives. De telles approches sont également pertinentes dans le domaine émergent des bibliothèques numériques.

Cet article visait à fournir un panorama des méthodes d’évaluation pouvant être utilisées en bibliothèques, fondées sur une analyse à la fois quantitative et qualitative des services traditionnels, tout en prenant en compte les questions plus récentes liées à l’évaluation des services numériques. Motivé par la volonté de participer au débat sur la pertinence d’une approche holistique de l’évaluation des services de bibliothèques, cette contribution a tenté de décrire les aspects systémiques tant matériel que logiciel (« hard » et « soft ») de la qualité d’un service, indépendamment de sa nature.

Bibliographie

[1] S. Aabo et R. Audunson, « Rational choice and valuation of public libraries : can economic models for evaluating non-market goods be applied to public libraries ? », Journal of Library and Information Science, 2002, 34 (1), p. 5-16.

[2] M.J. Aitta, S. Kaleva et T. Kortelainen, « Heuristic evaluation applied to library web service », New Library World, 2007, 109 (1/2), p. 25-45.

[3] Audit Scotland (2004), Cultural and Community Services : Performance Indicators 2002/2003, Edinburgh : Audit Scotland, p. 1-10.

[4] Audit Scotland (2008), Audit Scotland’s performance indicators – service profiles 2006/2007.

http://www.audit-scotland.gov.uk/performance/service/ (consulté le 15 janvier 2010).

[5] D.D. Barron et al., The economic impact of public libraries in South Carolina. University of South Carolina, School of Library and Information Science, 2005.

http://www.libsci.sc.edu/SCEIS/impact_brochure.pdf

[6] D.H. Blake, W.C. Frederick, M.S. Myers, Social auditing : evaluating the impact of corporate programmes, Praeger, 1976.

[7] Bolton Metropolitan Borough Council and MLA North West (2005), Bolton’s Museum, Library and Archive Services : an economic evaluation, Bolton : Metropolitan Borough Council.

[8] J. Bryson, B. Usherwood et D. Streatfield, Social Impact Audit for the South West Museums Libraries and Archives Council, Centre for the Public Library in the Information Society, Department of Information Studies, The University of Sheffield [SWMLAC Report], 2002, p. 9-11, 56, 41-44.

[9] S. Buchanan et F. Gibb, « The information audit : theory versus practice », The International Journal of Information Management, 2008, 28 (3), p. 150-160.

[10] S. Buchanan et A. Salako, « Evaluating the usability and usefulness of a digital library », Library Review, 2009, 58 (9), p. 638-651.

[11] R.S. Dicks, « Mis-Usability : on the uses and misuses of usability testing » in : Proceedings of the 20th Annual International Conference on Computer Documentation, ACM, Toronto, 2002, 26-30.

[12] Simon Fraser, « Love it or lose it » BBC News, 2006. http://news.bbc.co.uk/1/hi/magazine/5105580.stm

[13] S. Greenberg et B. Buxton, « Usability evaluation considered harmful (some of the time) » in : Proceedings of the twenty-sixth annual SIGCHI conference on human factors in computing systems, ACM, Florence, 2008, p. 111-120.

[14] J.M. Griffiths et al., « Taxpayer return on investment in Florida public libraries : summary report », 2004. http://dlis.dos.state.fl.us/bld/roi/pdfs/ROISummaryReport.pdf

[15] K. Hornbak, « Current practice in measuring usability : challenges to usability studies and research », International Journal of Human-Computer Studies, 2006, 64 (2), p. 79-102.

[16] K. Jones, M. Kinnell et B. Usherwood, « The development of self-assessment tool-kits for the library and information sector », Journal of Documentation, 52 (2), 2002, p. 120-135.

[17] J. Leong, « Academic reference librarians prepare for change : an Australian case study », Library Management, 29 (1-2), 2008, p. 77-86.

[18] R. Linley et B. Usherwood, New Measures for the New Library : A Social Audit of Public Libraries, British Library Research and Innovation report 89, 1998, Sheffield : Department of Information Studies, University of Sheffield.

[19] A. Neely, « The evolution of performance measurement research : developments in the last decade and a research agenda for the next », International Journals of Operations & Production Management, 25 (12), 2005, p. 1264-1277.

[20] J. Parry, « Librarians do fly : strategies for staying aloft », Library Management, 29 (1-2), 2008, p. 41-50.

[21] SLIC, Building on success : a public library quality improvement matrix for Scotland, 2007, Hamilton : Scottish Library and Information Council/Scottish Executive.

[22] St. Louis Public Libraries, Using your library : public library benefits valuation study, St. Louis Public Library, 1999. http://www.slpl.lib.mo.us/using/valuationtoc.htm

[23] Y. Tonta, « Libraries and museums in the flat world : are they becoming virtual destinations ? », Library Collections, Acquisitions & Technical Services, 32 (2008), p. 1-9.

[24] J. Toyne et B. Usherwood, Checking the Books : the value and impact of public library book reading, 2001, Sheffield : Department of Information Studies, University of Sheffield.

[25] G. Tsakonas et C. Papatheodorou, « Analyzing and evaluating usefulness and usability in electronic information services », Journal of Information Science, 2006, 32 (5), p. 400-419.

[26] G. Tsakonas et C. Papatheodorou, « Exploring usefulness and usability in the evaluation of open access digital libraries », Information Processing and Management, 2008, 44 (3), p. 1234-1250.

[27] D.K. Whynes, Z. Philips et E. Frew, « Think of a number… any number ? », Health Economics, 14 (11), 2005, p. 1191-1195.

[28] H. Xie, « Users’evaluation of digital libraries (DLs) : their uses, their criteria, and their assessment », Information Processing and Management, 44 (3), 2008, p. 1346-1373.

*. Article traduit de l’anglais par Emmanuel Jaslier.

Avril 2010