Évaluation et validation de l’information sur internet

Agnès de Saxcé

Le 31 janvier 2007, à Paris, s’est déroulée une Journée d’étude des Urfist (unités régionales de formation à l’information scientifique et technique) sur le thème « Évaluation et validation de l’information sur internet 1 ».

Enjeux et dangers de l’évaluation

En guise d’introduction, Jean-Emile Tosello-Bancal (Sous-direction des bibliothèques et de l’information scientifique) s’attache à préciser la notion de validation comme recherche de valeur et de conformité, et décline différents niveaux de l’évaluation, jugée omniprésente dans l’éducation : évaluation individuelle de l’agent par le biais d’un dialogue avec ses pairs ; évaluation des établissements s’appuyant sur des indicateurs inscrits dans une logique contractuelle ; évaluation nationale avec la mise en place de la Lolf (Loi organique relative aux lois de finances) ; et évaluation concurrentielle induite par des outils tels que le classement de Shanghai ou le Science Citation Index. Or, l’évaluation doit s’inscrire dans un processus et un contexte propre.

Marin Dacos (École des hautes études en sciences sociales) et Manuel Durand-Barthez (université Tou-louse III) dénoncent les incohérences des instruments d’évaluation, qualitatifs ou quantitatifs, et jugent les indicateurs bibliométriques inadaptés. Ainsi, le facteur d’impact de l’Institute for Scientific Information privilégie les revues papier à diffusion payante et les disciplines scientifiques, ignore la recherche en sciences humaines et sociales et les archives ouvertes, exclut les monographies, les publications non anglophones et les disciplines spécialisées. Le facteur temporalité pour les revues nouvellement créées est complètement occulté. Quant au facteur de Hirsch, qui combine le nombre de publications et de citations corrélé au nombre d’années de carrière du chercheur, il conduit au syndrome de Shanghai ! Les comités de lecture impliquent une part importante de subjectivité. L’opacité des algorithmes des moteurs de recherche, essentiellement anglophones (Google Scholar, Scirus, OAIster), rend les résultats contestables. La fiabilité des répertoires de liens (les Signets de la BnF, l’Album des sciences sociales de Revues.org ou le portail Ménestrel 2) est conditionnée à leur mise à jour continuelle. Pourtant, parallèlement au développement des archives ouvertes, de nouveaux outils voient le jour. Citebase 3 et CiteSeer 4 proposent un système d’évaluation centré sur l’article qui prend en compte le nombre de téléchargements, de citations générées et le temps écoulé entre les deux actions.

Vers une évaluation communautaire ?

L’intérêt se porte aujourd’hui sur les évaluations qualitatives coopératives : Faculty of 1000 Biology 5 est un outil mis en place par un groupe d’universités américaines qui permet de repérer les « perles cachées » (« hidden jewels ») en signalant les articles de revues à faible facteur d’impact ! Marin Dacos préconise l’évaluation par une communauté soudée allant de pair avec l’appro-priation d’outils collaboratifs (bookmarking, blogs, clusters) mais nous met en garde sur les dérives obsidionales, la concentration totalitaire et la tentation technocentriste.

Le fonctionnement participatif de l’encyclopédie Wikipédia, 12e site le plus visité du monde, présenté par Laure Endrizzi (Institut national de recherche pédagogique), fait apparaître une modification et une diversification des figures de l’auteur et de l’éditeur. Plusieurs rôles sont identifiables : les experts gestionnaires qui surveillent les modifications (wiki-pompiers qui interviennent en cas d’erreurs, wiki-fourmis ou indexeurs, wiki-gnomes ou correcteurs d’orthographe) ; les experts éditoriaux qui normalisent, structurent et valident les contenus ; les experts politiques qui définissent la philosophie du projet. Fondée sur des règles de savoir-vivre (wikilove, wikiquette), le respect du droit d’auteur, l’écriture collaborative et des espaces auxiliaires communs (pages de discussion, wikiprojet), Wikipédia est emblématique du web 2.0.

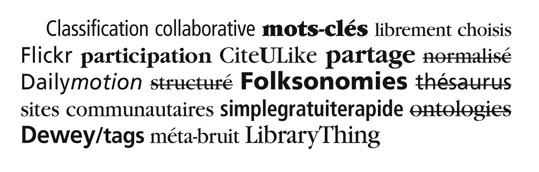

Les folksonomies, ou indexation collaborative, que nous présente Olivier Ertzscheid (IUT La Roche-sur-Yon, université de Nantes) sont une autre fonctionnalité phare du web 2.0. L’usager indexe lui-même les contenus qui l’intéressent en choisissant ses mots-clés, ou « tags », et compose des « nuages » de mots issus du langage clair. Seule la typographie traduit un semblant de structuration. Ainsi, les folksonomies de l’intervention d’Olivier Ertzscheid pourraient se présenter de la façon suivante.

En dépit du bruit généré, les « tags » investissent les catalogues de bibliothèques pour donner naissance à des modèles hybrides où cohabitent indexation contrôlée et folksonomies.

Pour une formation informationnelle

En retraçant l’histoire de la notion d’auteur – de celui qui « varie » sur les textes précédents au Moyen Âge, en passant par la naissance du droit d’auteur au XVIIIe siècle, jusqu’à l’auteur du blog, davantage commentateur ou compilateur – Évelyne Broudoux (IUT de Vélizy – Université de Versailles – Saint-Quentin-en-Yvelines) constate la disparition de l’autorité intellectuelle au profit, peut-être, d’une autorité de support et de réseau social constitué par la blogosphère.

Dans le contexte hétérogène et évolutif d’internet, les intervenants de l’après-midi s’accordent sur la perte des repères pour les étudiants et les enseignants. Claire Panijel (Urfist Paris) et Claire Nacher (université Paris-III) insistent sur la nécessité pour les bibliothécaires et les enseignants de construire en partenariat des formations inscrites dans le cursus universitaire et le contrat d’établissement. Alexandre Serres (Urfist Rennes) stigmatise l’illusion du savoir et le refus d’apprendre et prône une formation plurielle : citoyenne et critique, méthodologique, théorique et technique. À la recherche d’un « support de cours » sur internet, Élisabeth Noël (Formist/Enssib) démontre la complexité de la démarche et l’intérêt de la norme LOMFR (Learning Object Metadata) pour mieux identifier les ressources pédagogiques fiables.

En conclusion, Ghislaine Chartron (Conservatoire national des arts et métiers) se félicite de la diversification des processus d’évaluation qu’accompagne la redistribution des pouvoirs de l’expertise. Mais elle se défie des dangers de l’audimat liés au phénomène des « Top 10 » présents sur de nombreux sites et du possible formatage des lecteurs par le système des rebonds. Enfin, elle réaffirme notre rôle de médiateur en tant que formateurs et acteurs éditoriaux, en particulier dans le cadre des archives ouvertes.