La problématique de l'Europe de l'information

Malgré des efforts importants fournis ces dernières années dans les programmes de recherche et développement, le retard technologique et industriel de l'Europe par rapport aux États-Unis et à l'Extrême-Orient ne cesse de se creuser, notamment au niveau des matériels et des systèmes ou dans le secteur du commerce de l'information. Dénonçant le manque de cohérence des pratiques actuellement en usage au niveau national et communautaire, l'auteur établit un diagnostic sans complaisance des actions disparates en cours ou en préparation. Pour donner à l'Europe un nouveau départ, il propose de définir une politique de l'information en Europe, qui suive les quatre orientations suivantes : stratégie d'intégration, politique de produits, autonomie des partenaires et définition d'actions exemplaires. Un programme européen pourrait servir de cadre aux différentes initiatives nationales.

In spite of the important efforts made last years in research and development programs, Europe is more and more behind the Far-East and the USA, as far as technology and industry are concerned, mainly regarding equipment and systems or commerce of information. The author exposes the lack of consistency in the existing practices at the community level and within each State ; he judges the multiple actions in progress or in preparation severely. In order to give Europe a new start, he suggests to develop a European information policy according to the following trends : integration strategy, products policy, autonomy of each partner and development of models. Any national initiative could take place within a European programme framework.

« ... Ne prendre la tradition que comme un renseignement, et les faits présents que comme une utile étude pour faire autrement et mieux... », Alexis de Tocqueville.

Les réflexions que l'on va lire s'articulent autour de quatre thèmes, fortement imbriqués, à savoir : stratégie d'intégration, politique de produits, autonomie des partenaires, applications exemplaires. Ce schéma définit, en un raccourci rapide, ce que devraient être, selon l'auteur (qui s'exprime à titre personnel), les principales orientations d'une politique de l'information pour l'Europe, résolument tournée vers le XXIe siècle.

Pour en souligner le caractère novateur, on rappellera, en contrepoint, les actions disparates en cours ou en préparation. Ce diagnostic sans complaisance sera étayé de brefs rappels historiques. Cependant, la méthodologie générale qui sera suivie s'apparente à l'approche-systèmes, dont la vertu cardinale réside dans l'obligation de cohérence interne. A contrario, le manquement à cette règle constitue l'aspect le plus critiquable des pratiques actuelles, tant au niveau national qu'au niveau communautaire.

Au début des années 70, le mot « explosion » se retrouvait sous toutes les plumes pour désigner la croissance exponentielle de la science et de ses prolongements : découvertes, innovations, connaissances, informations spécialisées. Force est de constater que, quinze années plus tard, les outils nécessaires - saisie, logiciels, stockage, archivage - laissent toujours à désirer.

A présent, c'est à une autre révolution que les communicateurs, chercheurs, auteurs, éditeurs, sont conviés à prendre part. La micro-édition, issue de la fusion de la micro-informatique, du traitement du texte et de l'imagerie électronique, permet de réduire de moitié les prix de revient et rend ainsi viables des tout petits tirages d'excellente qualité. La concurrence aidant, les maisons d'édition classiques seront amenées à imiter les novateurs et à abaisser leurs propres prix de vente, contribuant à leur tour à l'élargissement du marché.

Dès lors, la multiplication par un facteur X, en l'espace de quelques années, du nombre et du volume des publications imprimées apparaît comme inéluctable. Dans l'état actuel des choses, les bibliothèques, centres de documentation, banques de données et autres agences spécialisées qui recueillent, analysent, inventorient, conditionnent et rediffusent informations, données et images ne sont en mesure de maîtriser ni ce nouveau déluge, ni cette atomisation des sources, ni enfin la diversification des supports.

On sait que les disques compacts et les lecteurs à laser concurrencent de plus en plus le papier et les supports magnétiques. Mais on omet souvent de dire que l'encyclopédie Grolier sur CD-ROM - pour le moment sans illustrations - est vendue au quart du prix des vingt gros volumes sur papier, et des baisses, plus substantielles encore, sont à prévoir. Or, ce sont ces réalités économiques-là qui détermineront l'infrastructure future des centres et des réseaux d'information, effaçant en partie les différences originelles de nature et de vocation.

En toile de fond, il y a l'Europe, qui suit en boitillant le mouvement général. En dépit des efforts consentis ces dernières années, son retard technologique et industriel, au lieu de se résorber, s'accentue inexorablement par rapport aux États-Unis et à l'Extrême-Orient. Ce déclin relatif, on le découvre aisément au niveau des matériels et des systèmes, mais il est tout aussi préoccupant en ce qui concerne le commerce de l'information. Ne serait-ce que pour arrêter la glissade et amorcer le redressement, il faut, de toute évidence, changer radicalement de cap.

Une stratégie d'intégration

Tous les éléments d'appréciation disponibles commandent d'adopter sans tarder une stratégie d'intégration qui embrasse fonctions et activités, jusqu'ici distinctes, d'information, de documentation, d'archivage, les prestations à valeur ajoutée, mais aussi la saisie automatique et la télémétrie, plus une partie de l'ingénierie informatique.

Finalité et objectifs

Cette conception ambitieuse va au-delà de la simple interconnexion des réseaux et vise à : - garantir à tous les usagers l'accès - par voie directe ou grâce à des relais - à la totalité des ressources ;

- assurer la complémentarité entre bibliothèques, banques de données, serveurs, etc., conditions sine qua non d'une indispensable amélioration de leurs ratios coût-efficacité;

- harmoniser la méthodologie du traitement avec l'environnement informatique ambiant, dont les maîtres-mots sont: processeurs parallèles, systèmes ouverts, logiciels portables, réseaux flexibles;

- donner aux Européens, en perte de vitesse, une longueur d'avance dans la mise en œuvre d'une politique de l'information appelée à s'imposer universellement avant l'an 2000.

En définitive, il s'agit de dégager une finalité, dans le sens que Bergson donnait à ce terme, qu'il concevait à la fois comme « principe interne de direction » et « élan vital ».

Deux pièges asymétriques sont à éviter. L'intégration ne saurait être que partielle et modulaire, car tout excès à cet égard entraînerait un surcoût injustifié. Par ailleurs, l'intégration est à l'opposé de l'accumulation en vrac, comme ont pu le constater, a contrario, les visiteurs de l'exposition Mémoires du futur, au Centre Pompidou 1 où était présentée une panoplie de technologies isolées, chaque démonstration se faisant sur des données différentes.

Rupture avec le passé

Les pays européens, la CE comprise, sont-ils, psychologiquement et institutionnellement, préparés à sauter le pas ?

Pour des raisons historiques, les banques de données et les serveurs, les centres de documentation et les bibliothèques - ces dernières pouvant de leur côté être classées différemment suivant leur statut - ne relèvent pas en général d'une même autorité de tutelle, mais de ministères qui poursuivent souvent des politiques divergentes, voire opposées.

A partir de 1974, l'Allemagne fédérale 2 se lança dans la création d'une vingtaine de Fachinformationsysteme destinés à contourner les bibliothèques traditionnelles. Ce projet fit longtemps illusion, mais il se heurta finalement à l'opposition farouche des grandes administrations bureaucratiques, jalouses de leurs compétences. La dissipation des crédits en dépenses de personnel a consommé l'échec.

Impressionnées par l'effort budgétaire de l'Allemagne, la Grande-Bretagne et la France lui emboîtèrent le pas, la première en s'appuyant sur la British library, la seconde en créant une agence interministérielle, le Bureau national de l'information scientifique et technique (BNIST), ayant à la fois un rôle de coordination et une sphère d'activités propre. La différence est frappante. Tandis qu'en Angleterre priorité fut donnée à la modernisation des bibliothèques et des centres de documentation, en France, les subventions servirent à informatiser des fichiers manuels et à les rendre accessibles via quelques serveurs nationaux.

En 1974-75, la Commission des communautés européennes fit adopter par les États membres un premier plan d'action triennal dans le domaine de l'IDST (information, documentation scientifique et technique), comportant trois objectifs : création du réseau Euronet; développement d'outils de traitement et particulièrement d'aides à la traduction automatique ; coopération européenne pour bâtir ensemble des systèmes d'information spécialisée : médecine, agriculture, etc. Le deuxième plan d'action, 1978-80, favorisa davantage la création de banques de données et inaugura quelques projets-pilotes plus techniques.

Ces choix - nationaux et communautaires - pouvaient d'une certaine manière se comprendre dans le contexte des balbutiements européens des années 1970. L'erreur, imputable aux uns et aux autres, fut de s'accrocher pendant trop longtemps à des conceptions périmées et à des priorités devenues caduques.

Besoin général de décloisonnement

Ainsi, pour tirer la Bibliothèque nationale 3 de son état de décomposition, son tout nouveau patron espère qu'une chirurgie esthétique suffira, tandis que le rapport Beck préconise un large usage du bistouri. De même, pour sortir le domaine information-documentation, bibliothèques comprises, de son état de balkanisation avancée, il faudra bien adopter une thérapeutique appropriée et, pour commencer, faire sauter les innombrables cloisons, et même la muraille externe, à l'abri desquelles se perpétuent chapelles et mini-chapelles. Ce décloisonnement et ce désenclavement, c'est d'abord la matière traitée qui les exige.

De nos jours, peut-on encore opposer l'information gratuite et en quelque sorte désintéressée à l'information ayant un caractère utilitaire, donc payante, alors que les usagers ont le plus souvent besoin de l'une et de l'autre ? Qui donc est qualifié pour fixer la ligne de partage entre information-savoir, information-brevet et information-facteur de production, la première étant théoriquement accessible sans frais, la seconde strictement tarifée et la troisième vendue au prix résultant de la concurrence ?

Il faudra bien se résoudre à abattre la bastille de l'information dite scientifique et technique et supprimer certains privilèges - franchises postales, exemptions fiscales, snobisme académique - qui s'y rattachent. En règle générale, les données et informations scientifiques et techniques devraient être fournies avec les compléments et les prolongements indispensables (statistiques, relevés de consommation, renseignements financiers, textes juridiques...) sous une forme élaborée et dans un format approprié suivant la catégorie et le niveau de l'utilisateur, final ou intermédiaire.

D'autres rapprochements sont hautement souhaitables, par exemple entre données macro- et micro-économiques, entre traitement différé et interrogation interactive, entre textes et images, entre sources externes et fichiers internes, entre recherche-développement (ou RD) et pré-recherche.

En Europe, et spécialement en France, 75 % des banques de données sont des créations d'organismes publics ou parapublics tandis qu'aux Etats-Unis c'est l'industrie privée qui est prédominante. Cependant, les unes comme les autres n'hésitent pas à se liguer contre les usagers et, de connivence avec les serveurs, imposent à leurs abonnés des contrats léonins, notamment en ce qui concerne les défaillances techniques, la responsabilité civile, le fardeau de la preuve, etc. Sans doute était-il utile d'acclimater en Europe, il y a quinze ou vingt ans, la notion anglo-saxonne d'information market, ne fût-ce que pour valoriser l'information et, subsidiairement, pour contrer la conception allemande d'une information académique à tout jamais taboue. Comme cette querelle mi-sémantique, mi-idéologique n'est toujours pas réglée, l'on préfère entretenir l'ambiguïté. La Commission européenne elle-même y contribue, en parlant, dans un même document 4, tantôt de marché unique, tantôt de marché intérieur, de marché commun ou encore de marché communautaire, d'une manière plus ou moins interchangeable.

En un mot comme en cent, il est temps que les autorités politiques - gouvernements européens et organes communautaires - s'accordent pour affirmer solennellement, à l'intention de toutes les parties intéressées, l'universalité de l'information, et s'engagent à mettre fin à la guerre des chapelles, aux rivalités entre services et au gaspillage qui en résulte.

Une politique de produits

Il ne suffit pas de fixer l'axe d'une stratégie, encore faut-il en définir les lignes de force, en tenant compte des contraintes. Hélas, les pays européens ne disposent pas à cet égard d'une grande liberté de manœuvre. En anticipant quelque peu, notre conclusion se ramène à deux propositions: prendre la qualité des prestations pour point de mire prioritaire et, quel que soit le domaine d'application, développer la capacité d'offrir des solutions complètes.

Des coûts excessifs

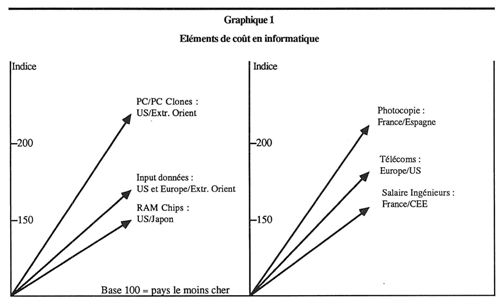

Bien que bénéficiant de commandes publiques privilégiées et d'un protectionnisme avoué, la plupart des sociétés et organisations de souche européenne sont de moins en moins compétitives sur le plan mondial. Comme le montre le graphique n° 1, elles ont à supporter, comparativement à leurs rivales japonaises et américaines, des éléments de coût nettement supérieurs.

Si le prix de revient à l'unité d'une puce de mémoire passive made in Japan est de 100, la même puce fabriquée aux États-Unis reviendra à 150 et elle coûtera 175 ou davantage à sa sortie d'une usine européenne. Les grandes banques de données trouvent désormais avantageux de confier les travaux de saisie 5 à de petites sociétés de Singapour, de Taïwan, de Hong-Kong, ou encore d'Inde ou de Malaisie. Les calculateurs construits en Europe, nos micro-ordinateurs, nos périphériques, nos banques de données et les services de nos serveurs se vendent mal et ils sont particulièrement vulnérables sous l'angle du rapport prix/qualité. En outre, les coûts de production en France tendent à dépasser les prix de revient relevés dans les pays voisins.

Le mirage du « tous azimuts »

Il y a quelque chose de donquichottesque dans l'obstination de nos dirigeants à favoriser une R-D touche-à-tout et à soutenir une production industrielle tous azimuts. On invoque l'impératif de l'indépendance nationale, mais on fait semblant d'ignorer que les Japonais s'en remettent sans complexe aux bases de données américaines à concurrence de 60 % et achètent les brevets d'invention à tire-larigot.

Les modalités d'application renforcent encore cette tendance à vouloir tout faire par soi-même, en même temps et quel qu'en soit le prix. Voici en gros comment les choses se passent. Un organisme national lance un appel aux propositions visant à susciter, moyennant cofinancement sur fonds publics, des projets-pilotes en informatique ou encore l'automatisation de fichiers manuels, sans véritablement imposer de critères de qualité et de rentabilité.

La Commission de Bruxelles a étendu ce schéma, à partir de 1980-81, à l'ensemble des actions de soutien aux technologies nouvelles et à leurs applications, sur base de propositions émanant d'au moins deux postulants de nationalités différentes. Les associations ainsi formées sont souvent de pure forme, leur seul ciment étant l'appât de subsides nationaux et communautaires cumulables.

Ce mécanisme privilégie la quantité au détriment de la qualité, et il aboutit inévitablement à un saupoudrage dispendieux. Plus le nombre de projets « retenus » est élevé, plus l'autosatisfaction générale est grande, et plus la perspective de rallonges budgétaires s'améliore. Pour peu, on en viendrait à oublier que le déficit commercial de l'Europe en électronique, tous produits et services confondus, s'est élevé en 1986 à 14 milliards de dollars et que, selon les prévisions 6, il atteindra près de 30 milliards en 1992.

Une marque : la qualité

La nostalgie, même inavouée, de la grandeur passée des nations européennes est, on le voit, une bien mauvaise conseillère lorsqu'il s'agit de déterminer la marche à suivre à l'avenir en matière de technologies de pointe. Mieux vaudrait, à coup sûr, bâtir la politique européenne de l'information en tirant avantage des quelques cartes maîtresses que l'Europe possède en propre, en s'inspirant d'exemples probants de réussite.

Les traditions ancestrales, faites d'un mélange de raffinement, de bon goût inné, de confort n'ont pas été entièrement étouffées, tant s'en faut, par le modernisme ambiant. Le design (« création industrielle ») italien et danois, anglais et scandinave, qui avait rendu attrayants tant d'objets manufacturés, commence à être appliqué, avec succès, aux matériels informatiques. En général, les produits haut de gamme et les produits sur mesure correspondent davantage aux mentalités et aux capacités des Européens que les produits de grande série.

Contrairement aux Asiatiques, les Européens ont tout intérêt à favoriser industries et productions incorporant une forte dose de « matière grise » : logiciels et langages évolués, génie informatique, ingénierie documentaire, modèles de simulation, certains brevets d'invention, banques de données pointues, compendia de normes, etc.

Les capitaux, y compris les capitaux à risque, sont abondants, comme en témoignent les rachats en cascade de SSII 7 françaises et étrangères. Les Européens ne lésinent pas non plus sur les dépenses de R-D en électronique, soit 15 milliards de dollars contre 10 milliards pour le Japon.

L'esprit d'initiative revient en force. Les Nixdorf, les De Benedetti, les Serge Kampf, les Christopher Sinclair ont fait la démonstration qu'une entreprise de taille moyenne peut se hisser au niveau des meilleures. Derrière ces vedettes, on découvre, en feuilletant le très sérieux Business week, une pléiade de jeunes chefs de file, et par exemple, Rolf Skâr (Norsk data), Alain Nicolaïdas (Matra datavision), Pasquale Pistorio (SGS, Italie), Philip Hughes (Logica), Ernest Uhlmann (FELA, Suisse), suivis d'une dizaine d'autres noms.

Enfin, l'Europe met les bouchées doubles pour rattraper son retard en télécommunications, et l'on prévoit que, dès 1989, les commandes européennes d'équipements dépasseront les investissements américains, ouvrant ainsi la voie à des applications sophistiquées et plus fiables.

Un label : le service complet

Comme tous les laboratoires pharmaceutiques, Glaxo France s'est trouvé confronté au problème d'organisation et de gestion d'une masse sans cesse croissante d'informations et de demandes de recherches de plus en plus complexes. N'ayant pas trouvé sur le marché un système clefs en main et ne voulant pas tomber sous la dépendance d'un seul fournisseur, Glaxo a créé une chaîne de traitement complet du document A 4. Textes et données sont numérisés et stockés sur des disques optiques de grande capacité et accessibles désormais en temps réel. La chaîne documentaire est connectée à un réseau Ethernet qui assure le transfert des images entre bureaux, ateliers et postes de travail dans d'excellentes conditions; cependant, elle constitue aussi l'embryon d'un réseau de communications intra-entreprise.

Le personnel a, dans l'ensemble, bien accueilli la solution retenue qui correspondait à des besoins réels et urgents. Dès le début, le projet a bénéficié de la collaboration active et des informaticiens et des documentalistes. Le nouveau système a permis de réaliser à la fois des gains de productivité appréciables et des améliorations de qualité.

Si nombre de nos bibliothèques et centres de documentation connaissent de graves difficultés : applications incompatibles, rendement insuffisant, prestations inadéquates, tarifs élevés, demande évanescente, dépenses de personnel injustifiées et salaires trop bas, c'est précisément pour avoir tout simplement plaqué un traitement électronique sur des circuits traditionnels, sans repenser le système dans son ensemble 8.

Le deuxième exemple est tout aussi instructif. En octobre dernier, on a appris la constitution d'une filiale commune Bouygues-IBM France, dénommée IB-2, ayant pour objet de réaliser des immeubles de bureau « intelligents ». Deux jours plus tard, ce fut le tour de Spie-Batignolles et de Bull d'annoncer qu'elles s'associaient pour poursuivre, par des voies quelque peu différentes, un objectif identique. En liant l'informatique et le téléphone grâce au pré-câblage, les deux groupements pourront offrir à leurs clients la possibilité d'implanter dans chaque bureau individuel, au moment voulu et pratiquement sans frais d'installations supplémentaires, une kyrielle d'applications existantes et à venir, susceptibles d'opérer soit séparément, soit d'une manière synchronisée. Selon un premier sondage, 2 % des sociétés seraient intéressées en cas de construction neuve, et 7 % envisageraient volontiers l'entrée de l'intelligence dans leurs immeublés existants.

Cette double initiative est exemplaire à plusieurs titres. Les parrains sont des sociétés prestigieuses, aux reins solides; aussi, le financement sur fonds privés est-il assuré. Le moment est bien choisi. L'association entre constructeurs immobiliers et sociétés informatiques peut surprendre au premier abord. Mais c'est précisément ce genre de rapprochement inédit qui est porteur de créneaux nouveaux et de nouveaux courants d'affaires. Enfin, l'émulation entre les deux groupements concurrents est un gage supplémentaire de réussite.

Qu'attend-on pour demander à IB-2 de créer un prototype de bibliothèque (municipalé, universitaire...) pré-câblée et pour charger Spie-Batignolles-Bull de réaliser la maquette d'un immeuble « intelligent » pour les besoins d'une grande maison d'édition mi-traditionnelle et mi-électronique ?

L'autonomie des partenaires

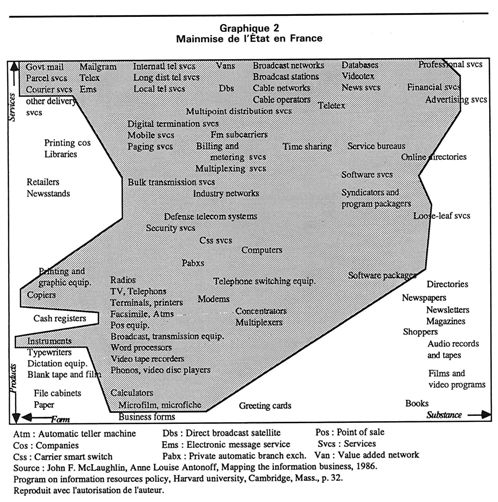

L'université Harvard avait créé en son sein, en 1979, un Center for information policy research original, qui entreprit aussitôt de dresser le « cadastre » des activités d'information. L'édition 1986 comporte 70 illustrations cartographiques mettant en lumière l'évolution de certaines technologies : par exemple la transition vers l'édition électronique; les variations dans les stratégies d'IBM, McGraw Hill, RCA, etc.; l'impact cumulé de la déréglementation des télécommunications sur le commerce des données, etc.

Le graphique n° 2 fournit une vue saisissante de la mainmise de l'État français, en tant que propriétaire et en tant qu'autorité de tutelle, sur les technologies de l'information et les différents secteurs satellites. Nul autre pays au monde ne possède une structure aussi centralisée. Sur un autre graphique (qui n'est pas reproduit ici), en utilisant la même technique, les auteurs ont imaginé de combiner le contrôle de facto qu'exercent à cet égard aux Etats-Unis, IBM et ATT, fréquemment accusées de pratiques monopolistiques : même réunies - hypothèse évidemment absurde - elles n'égaleraient pas l'omnipotence du gouvernement français.

Si les bibliothèques ne figurent pas dans la partie hachurée, c'est parce que la majorité de ces établissements sont des bibliothèques municipales et scolaires autogérées. Par contre, les bibliothèques dites nationales et pratiquement toutes les bibliothèques universitaires se trouvent dans une dépendance totale vis-à-vis de l'État 9. C'est dans ce contexte qu'il convient d'apprécier la pénétration de l'OCLC (Online computer library center) en Europe.

Les charmes (un peu) désuets du réseau

A l'instar de la Grande-Bretagne, de la Hollande, de l'Allemagne et du Danemark, la Direction des bibliothèques, des musées et de l'information scientifique et technique (DBMIST) a signé, en 1986, des accords de coopération avec l'OCLC prévoyant l'adhésion pro-. gressive de toutes les bibliothèques universitaires à ce réseau bibliographique américain, qui est aussi le fournisseur de toute une gamme de services spécialisés à valeur ajoutée. L'objectif à plus long terme, du côté français, est la constitution à moindres frais d'un catalogue collectif national banalisé, sur la base des notices, courantes et rétrospectives, fortement simplifiées, portant le label OCLC, et qu'il suffira, dit-on, de « franciser ». Inversement, grâce à ces accords, les notices relatives aux ouvrages en langue française trouveraient plus facilement le chemin des bibliothèques étrangères.

Les accords DBMIST-OCLC sonnent évidemment le glas de la politique de splendide isolement bibliothéconomique et bibliographique pratiquée depuis près de deux décennies. Tandis que, depuis 1970, la Bibliothèque nationale n'a réussi à faire entrer dans son fichier automatisé que 700 000 ouvrages, la base de données d'OCLC ne comporte pas moins de 16 millions de notices.

A première vue, on devrait se réjouir sans réserve de ce grand virage et se dire que mieux valait tard que jamais. Or, c'est précisément là que le bât blesse. L'idée d'un catalogue collectif national, qui était un article de foi en Amérique encore en 1980, a été depuis lors jetée aux orties et, de même, la conception d'un réseau bibliographique multifonction et universel est totalement passée de mode. Les mots d'ordre qui ont émergé s'appellent: décentralisation et marketing, conséquence inéluctable de la pénétration massive des micro-ordinateurs dans toutes les bibliothèques américaines et d'un effort exceptionnel de commercialisation et d'assistance technique de la part des constructeurs 10.

Ainsi, une fois de plus, existe du côté européen, un sérieux risque de déphasage par rapport aux États-Unis.

Un modèle : le syndicat d'initiative

Face au pragmatisme des Américains et des Anglais, les pays du vieux continent, et singulièrement la France, se trouvent aujourd'hui devant la nécessité, non seulement d'alléger les pesanteurs étatiques, mais aussi d'avoir à inventer des structures décentralisées qui, tout en correspondant à leur génie propre, permettent aux initiatives locales de se manifester et de se conjuguer au gré des besoins changeants de leurs mandants.

Le syndicat d'initiative (SI) tel qu'il existait à ses origines dans le domaine du tourisme et de l'accueil, au niveau de la station ou de la région, peut, en première approximation, servir de modèle. Un publicitaire se chargera bien de proposer un terme plus moderne. Cependant, l'appellation d'origine a l'avantage de contenir les deux idées-forces : initiative et groupement libre, qu'il ne faut surtout pas perdre de vue.

Il reste à esquisser un modus operandi d'ensemble, présenté ci-après sur le mode indicatif.

Ainsi que le montre l'expérience américaine, la décentralisation peut se réaliser sans nuire à l'indispensable effort de normalisation, qu'il s'agisse de normes d'interconnexion de réseaux, de compatibilité entre matériels et logiciels, de conventions bibliographiques ou de standardisation des interfaces.

En moulant leurs prestations sur les desiderata fluctuants de leur clientèle, les SI en information seront naturellement enclins à se situer au confluent d'apports pécuniaires disparates : financement partiel par les collectivités locales, libéralités pouvant provenir d'organismes professionnels, rétributions sur contrats de recherche université/industrie, etc. Un statut juridique souple - de type association d'intérêt public - devra leur permettre de s'affilier à une centrale d'achats, de mettre en commun certaines fonctions (promotion, marketing), de créer liaisons ad hoc ou réseaux permanents et, bien entendu, de former des fédérations.

Quant aux bibliothèques universitaires et aux centres de documentation spécialisés qui auront choisi de conserver leur spécificité, ils deviendront peu à peu, dans leurs domaines respectifs, l'instance de dernier recours. Ils devront eux aussi pouvoir se fédérer et s'entraider. Enfin, sous la pression de leur propre clientèle d'habitués, ils seront, de leur côté, amenés à rechercher certaines formes de collaboration avec les SI en information, dont ils seront, par ailleurs, tributaires au second degré.

L'implantation de ces nouvelles structures ne doit pas servir de prétexte pour remettre en cause la collaboration avec l'OCLC, par exemple en matière de catalogage, mais seulement son caractère d'exclusivité. Les bibliothèques et centres français et européens concernés retrouveront ainsi une certaine liberté, car ils auront le choix entre l'OCLC et plusieurs de ses concurrents directs et ils bénéficieront de prestations à la carte et au meilleur prix. De même, il n'est ni nécessaire, ni souhaitable que toutes les bibliothèques et tous les centres de documentation choisissent la même panoplie d'outils multilingues ou n'utilisent qu'une seule technique de traduction assistée.

Il apparaît ainsi possible de concilier les préférences de ceux qui préconisent les solutions à base de partage des tâches grâce aux avantages du réseau, et la détermination des partisans de l'autonomie et de l'autogestion à tout prix. Cette convergence paraît a priori susceptible de favoriser la division du travail et la rationalisation.

Sur le plan conceptuel, enfin, il convient de se garder de deux anachronismes. Le premier est représenté par ces traditionalistes purs et durs qui refusent en bloc toutes les techniques informatiques. L'autre écueil est plus subtil. Dans leur enthousiasme de néophytes, les avocats de l'automatisation et de la normalisation à outrance ressemblent au génial Henry Ford, pour qui toutes les automobiles devaient être noires et construites sur le modèle T. L'antithèse, c'est l'usine d'assemblage de Fiat à Cassino, partiellement robotisée, qui débite des voitures par milliers dans plus de 5 000 versions et variantes.

Pourquoi le bon public n'aurait-il pas le droit, mutatis mutandis, à une information un peu plus personnalisée, de meilleure qualité et à des prix abordables ?

Des applications exemplaires

Autant on peut déplorer l'abus manifeste de l'interventionnisme en France et, par contagion, en Europe occidentale, autant une aide sélective de l'État et celle de la Communauté économique européenne à la réalisation des « paris sur les structures neuves » (François Perroux) doivent être encouragées, sous réserve de certaines conditions. Tant il est clair en effet que les pays européens seront tôt ou tard obligés de revoir l'armature de leurs industries et d'une partie du secteur tertiaire, en vue de leur rentabilisation à moyen terme, en particulier en créant entre eux des solidarités nouvelles, mais tout en préservant l'héritage culturel de tous et de chacun.

Fonds de solidarité technologique

Le bon sens veut que les programmes et les initiatives qui s'inscrivent clairement dans cette vision de l'avenir bénéficient de la priorité absolue. Aussi, les critères de sélection devront-ils être définis de manière à canaliser fonds publics et aides communautaires vers des projets réellement porteurs, susceptibles d'être mis en oeuvre au moment le plus opportun et d'entraîner d'emblée la participation de la plupart des partenaires potentiels. Il y aura lieu également d'arrêter de nouvelles règles du jeu et de fixer à l'avance les principales modalités, y compris même les procédures de contrôle et les pénalités en cas de non-respect des engagements souscrits.

L'éventail des actions qui seraient particulièrement utiles est illustré par les exemples suivants, qui n'ont évidemment rien d'exhaustif.

Dès lors que certaines bibliothèques universitaires françaises, anglaises, allemandes, hollandaises sont désormais liées - pour le meilleur et pour le pire - par des accords de coopération avec l'OCLC, la logique voudrait que cette construction fût rapidement complétée par des conventions intra-européennes, auxquelles les autres pays de la Communauté trouveraient intérêt à adhérer.

Voici un autre exemple, dans le même ordre d'idées : la prévention médicale est assurément appelée à connaître un grand essor à la faveur des récents progrès de l'imagerie électronique; pourquoi la France, qui a des atouts non négligeables, ne proposerait-elle pas à ses partenaires de constituer une série de banques d'images médicales normalisées, d'organiser l'échange entre ces archives et de relancer ainsi la recherche sur les maladies rares, sur certaines épidémies, sur des maladies à propagation rapide, en s'appuyant, justement, sur de longues séries de données cliniques et d'images scientifiquement contrôlées ?

Encore faut-il trouver un moyen d'amener les pays les moins avancés dans une technologie ou dans un domaine d'application particulier, à se joindre aux autres et donc pratiquement à lever leur veto à tout projet qu'ils jugeraient « prématuré ». Ce moyen, ce ne peut être que le versement d'une « compensation » pécuniaire. A supposer que la plupart des PTT se mettent d'accord sur le calendrier de mise en place d'un réseau numérique à intégration de services, la Hollande qui vient d'engloutir des sommes considérables dans une technologie différente, pourrait fort bien, arguant de la nécessité d'amortir ces investissements, demander que le projet pan-européen soit remis à plus tard ou étalé dans le temps, provoquant ainsi un retard dommageable à la Communauté dans son ensemble.

En l'occurrence, un Fonds de solidarité technologique, fonctionnant sur le modèle du Fonds social ou du Fonds de développement régional, constituerait le meilleur antidote contre la tentation récurrente d'une Europe à plusieurs vitesses, porteuse en elle d'un germe de désintégration.

Valorisation du mécénat culturel

Dans les cartons de la Commission de Bruxelles dorment trois projets qui n'ont rien perdu de leur valeur depuis que l'idée en avait été lancée. L'ex-président du Sénégal, Léopold Sédar Senghor, avait proposé que l'Europe prît en charge la création d'une série de banques interconnectées - de données, mais surtout d'images et de sons - afin de préserver l'héritage ethnique, social, culturel, musical évanescent des peuples africains. Utopique il y a dix ans, ce projet est désormais parfaitement réalisable en utilisant des technologies que l'Europe aurait justement intérêt à acquérir et à développer. Faut-il rappeler que l'UNESCO a financé en son temps le sauvetage des temples d'Abou Simbel en Haute-Égypte et la reconstruction de celui de Borobodur sur l'île de Java ?

Autre réminiscence : le célèbre musée de Berlin-Ouest, à Dahlem, a lancé, il y a sept ou huit ans, le concept d'un répertoire illustré intra-européen des trésors de nos grands musées, décrivant les collections exposées, mais aussi les chefs-d'œuvre, dix fois plus nombreux, qui restent invisibles. Ainsi se réaliserait l'idée chère à André Malraux de « musée imaginaire », cent fois plus complet. Ce serait aussi un outil d'une valeur inestimable pour les historiens, les artistes, les galeries d'art, mais aussi pour la douane et la police chargées de traquer le trafic international d'objets volés. L'affaire n'a pas eu de suite sous prétexte que le projet n'entrait pas dans le cadre IDST. Est-il trop tard pour le reprendre ?

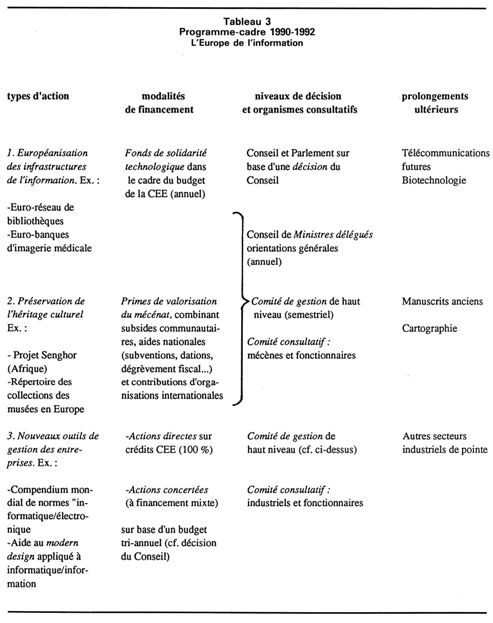

Il y aurait, cela va sans dire, le plus grand intérêt à procéder à de larges consultations avant d'arrêter les modalités d'intervention des pouvoirs publics et de la CEE en matière de mécénat culturel. On trouvera quelques premières indications à ce sujet dans le tableau récapitulatif n° 3.

Information choc pour l'industrie

Le troisième projet, à moitié oublié, dont la Commission européenne avait été saisie, est d'une inspiration plus directement utilitaire. Sous la dénomination d'UBINET (Urban business information network), un groupe de consultants parmi les plus connus avait, en effet, suggéré que fût mise sur pied une réplique européenne du réseau américain SBS utilisant des satellites pour véhiculer des flux importants d'informations industrielles, commerciales et techniques. En Europe de l'Ouest, près de 90 % des affaires sont concentrées dans moins de 75 agglomérations urbaines; il suffirait donc d'équiper ces villes-là en stations terrestres et réseaux locaux, les PTT agissant en tant que maître d'oeuvre (dans le cadre du futur RNIS ou en dehors), la CEE garantissant un volume minimum de trafic.

Voici, sous réserve d'inventaire, un premier échantillon d'actions concrètes susceptibles de « doper » un bon nombre d'entreprises européennes face à leurs concurrents américains et asiatiques :

- un centre de documentation, doublé d'une banque exhaustive en matière de normes et de standards en vigueur, en préparation, en projet, comportant des mises à jour fréquentes, couvrant, pour commencer, l'informatique et l'électronique;

- une agence de normalisation interindustrielle des documents administratifs et commerciaux : lettres de commande, factures, titres de transport..., préalable indispensable du développement à grande échelle de transactions électroniques entre fabricants, sous-traitants, entrepôts, distributeurs, ateliers de réparation et une foule d'autres corps de métier;

- une nomenclature douanière multilingue, et surtout simplifiée 11, disponible sur ordinateur et/ou sur cassettes, à l'intention des grossistes et des exportateurs-importateurs, signalant également les pratiques particulières par pays et par poste frontière, les facilités d'entrepôt en douanes, les entraves non tarifaires, les voies de recours, etc.;

- un programme de R-D sur les applications pertinentes et susceptibles de correspondre aux besoins du 3e âge, soit un marché en pleine expansion et particulièrement porteur en Europe;

- last but not least, la création de quelques centres de modern design appliqué systématiquement aux produits et aux prestations informatiques, y compris la recherche d'économies sur les matières premières, sur l'énergie et sur tous autres inputs comme, par exemple, le papier de print-out dont l'informatique fait un usage démesuré.

Un programme-cadre européen

L'un des buts visés par l'étude consacrée à la problématique de l'Europe de l'information, était de montrer qu'il est possible, dans ce vaste domaine aux contours imprécis et où tout s'enchevêtre au point de défier toute logique simple, de « faire autrement et mieux». C'est de cette même idée, empruntée à Alexis de Tocqueville, que procède notre proposition de programme-cadre « L'Europe de l'information », résumé sous forme de tableau (n° 3).

Cette récapitulation ne peut se comprendre qu'à la lumière des développements qui précèdent. Elle a les inconvénients d'une simplification que d'aucuns jugeront sans doute excessive. Mais elle a, par contre, l'avantage d'aider le lecteur et, en particulier le non-initié, à saisir d'un seul coup d'oeil l'éventail des moyens et des procédures disponibles au niveau communautaire - pour peu, naturellement, que la volonté des décideurs soit au rendez-vous.

En schématisant, la politique et l'action de la CEE, quel que soit le domaine d'application, peuvent être conçues de deux manières différentes. Elles peuvent, soit « accompagner » et partiellement « harmoniser » les politiques nationales et les actions menées par les gouvernements dans leurs pays respectifs, soit au contraire, comme en agriculture, servir de locomotive tirant un convoi auquel les pays membres accrochent « leurs » wagons.

Si l'auteur de ces lignes ne cache pas sa préférence pour cette deuxième approche, en revanche il doit s'interdire de « donner des conseils » concernant la mise en oeuvre pratique, dans les différents pays membres, d'un programme d'action qui n'en est encore qu'au stade d'une première ébauche.

Corollaire : Beaucoup de travail en perspective pour les dirigeants en place ou, à défaut, pour des équipes plus jeunes sachant gagner.

décembre 1987